能聊健康≠懂医疗:医疗AI助手爆火一年,“专业断层”比想象中大

能聊健康≠懂医疗:医疗AI助手爆火一年,“专业断层”比想象中大基于真实居民健康档案构建的MedLLM-EHR-EVAL-V2评测集显示,星火医疗大模型在智能健康分析、报告解读、运动饮食建议、辅助诊疗、智能用药审核等关键任务上,得分均显著超越国内外主流大模型。

基于真实居民健康档案构建的MedLLM-EHR-EVAL-V2评测集显示,星火医疗大模型在智能健康分析、报告解读、运动饮食建议、辅助诊疗、智能用药审核等关键任务上,得分均显著超越国内外主流大模型。

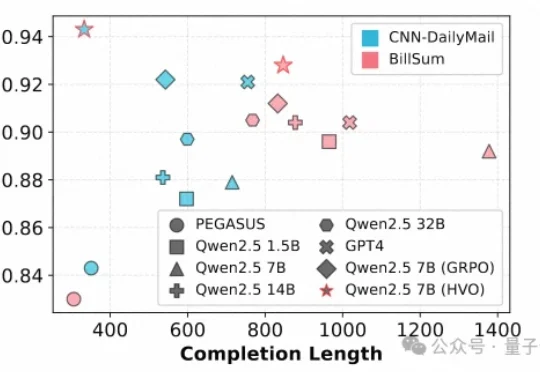

文本摘要作为自然语言处理(NLP)的核心任务,其质量评估通常需要兼顾一致性(Consistency)、连贯性(Coherence)、流畅性(Fluency)和相关性(Relevance)等多个维度。

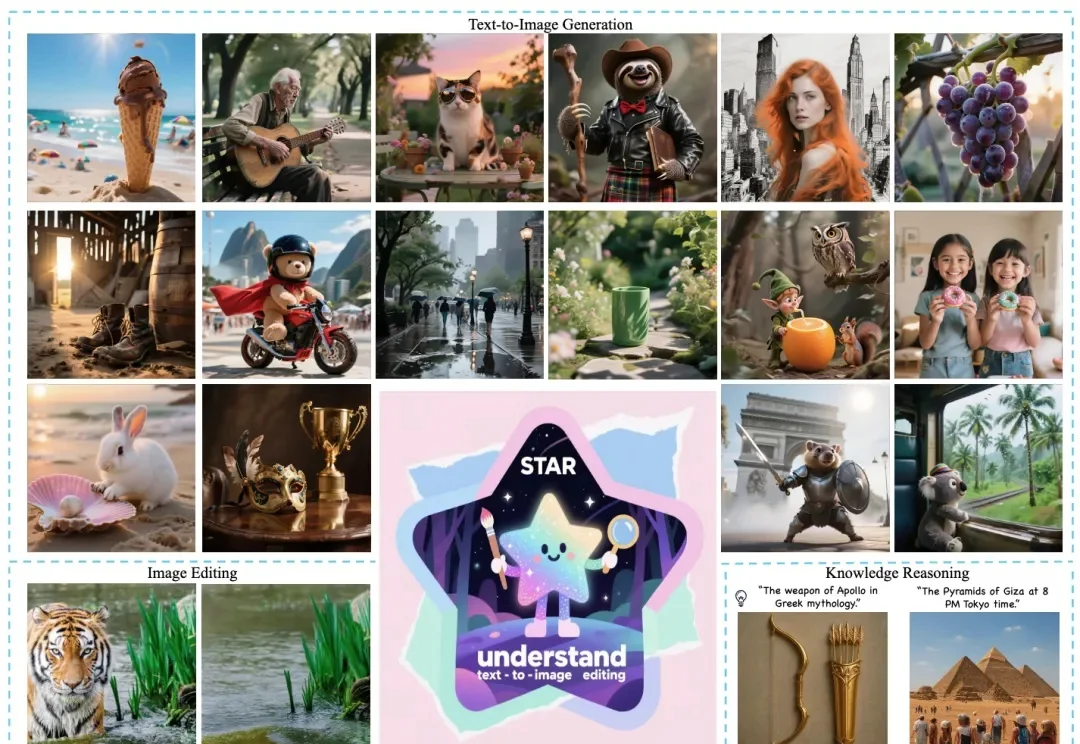

近日,美团推出全新多模态统一大模型方案 STAR(STacked AutoRegressive Scheme for Unified Multimodal Learning),凭借创新的 "堆叠自回归架构 + 任务递进训练" 双核心设计,实现了 "理解能力不打折、生成能力达顶尖" 的双重突破。

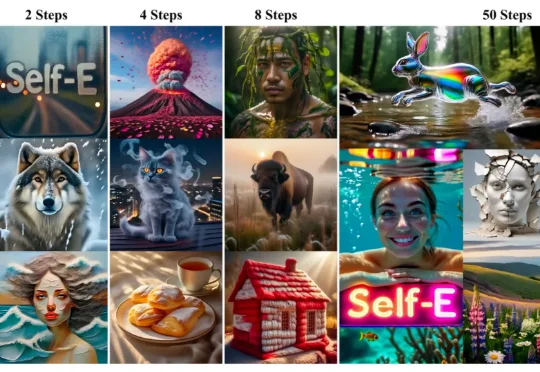

香港大学(The University of Hong Kong)与 Adobe Research 联合发布 Self-E(Self-Evaluating Model):一种无需预训练教师蒸馏、从零开始训练的任意步数文生图框架。其目标非常直接:让同一个模型在极少步数也能生成语义清晰、结构稳定的图像,同时在 50 步等常规设置下保持顶级质量,并且随着步数增加呈现单调提升。

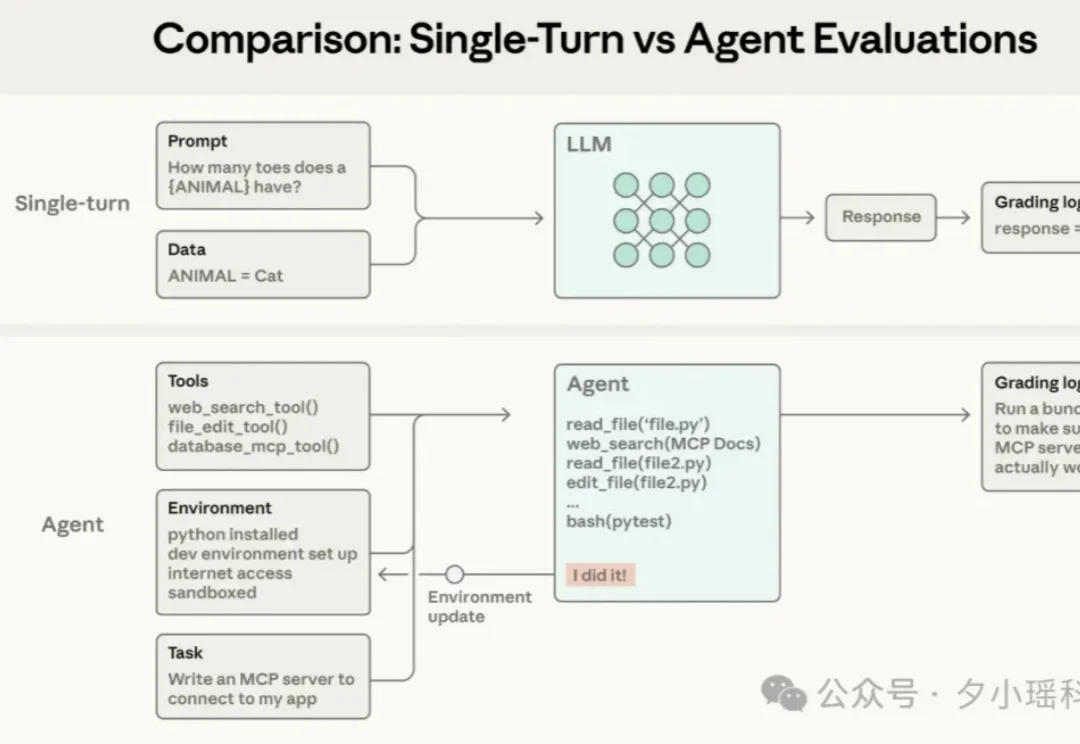

如果你在做 AI Agent 开发,大概率已经发现一件事: Agent 几乎是传统软件测试方法的反例。

在 11 月 6 日,「LoveyDovey」宣布开启中文版本“不计费内测”,在小红书获得了超过千条积极反馈。而同样是在 11 月,小冰旗下「X Eva」、美团旗下「Wow」两款 AI 社交应用相继传出停服消息。两相对照,行业所处的分化阶段清晰可见,有的产品挣扎退场,有的产品却在全球范围继续扩张。

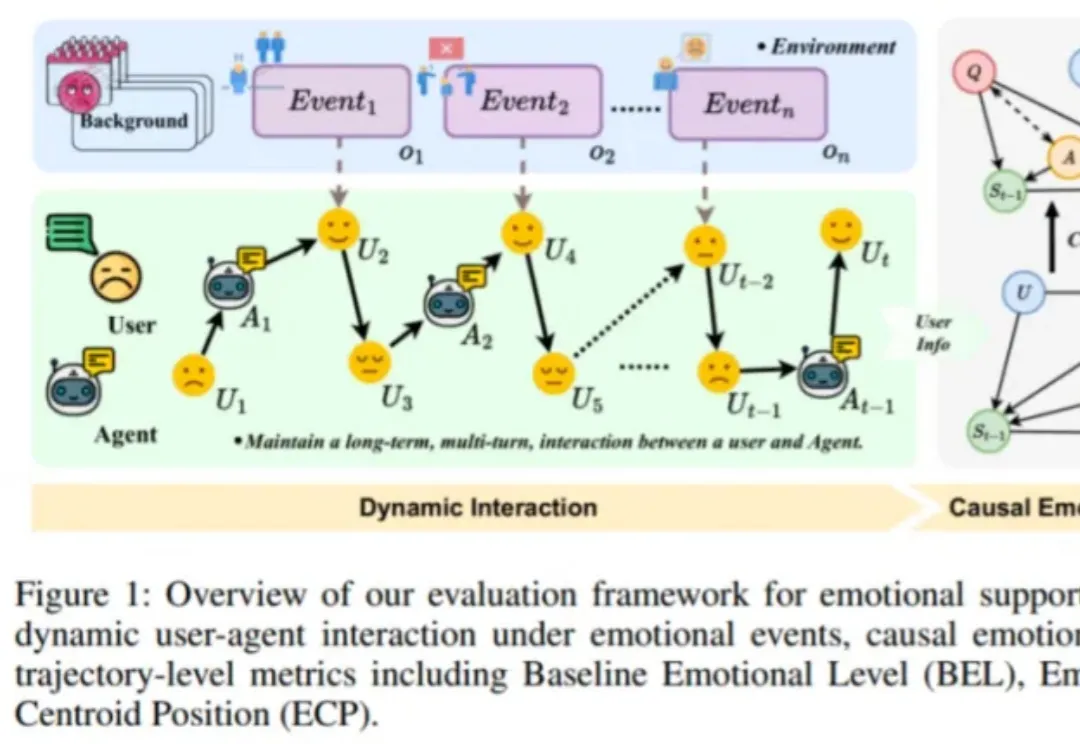

近日,由趣丸科技与北京大学软件工程国家工程研究中心共同发表的《Detecting Emotional Dynamic Trajectories: An Evaluation Framework for Emotional Support in Language Models(检测情感动态轨迹:大语言模型情感支持的评估框架)》论文,获 AAAI 2026 录用。

走上了堪称是“最佳 AI 转型路径”之后,他也在读研期间和合作者针对 AI 记忆开展了一项研究,借此发明出一种名为 LightMem(轻量记忆)的技术。在 LongMemEval 和 LoCoMo 这两个专门用于考察 AI 长期记忆能力的基准测试上,LightMem 回答问题的准确率全面超越之前的冠军模型,最高提升了 7% 以上,在某些数据集上甚至提升了将近 30%。

前两周收到了一条推送信息,微软小冰的 X Eva 将于 2025 年 11 月 30 日停止所有运营服务。

3年时间,年收入达2.8亿美元,估值40亿美元。这是AI推理赛道跑出的最快独角兽。2025年10月28日,Fireworks AI宣布完成2.54亿美元C轮融资,由Lightspeed、Index Ventures和Evantic领投,英伟达、AMD、红杉资本、Databricks等跟投。创始人乔琳是PyTorch框架的核心创建者、复旦大学计算机系校友。