6000 字全面复盘:马斯克与 OpenAI 的诉讼战

6000 字全面复盘:马斯克与 OpenAI 的诉讼战大家都知道 Elon Musk 最近和 OpenAI 在硅谷法庭上,「打得火热」,算是「一团和气」。前两天,OpenAI 的总裁 Greg Brockman 终于坐不住了。他直接发推 Diss Elon Musk,指责他为了打官司,竟然断章取义地把自己私人日记里的片段当成证据 😆。

大家都知道 Elon Musk 最近和 OpenAI 在硅谷法庭上,「打得火热」,算是「一团和气」。前两天,OpenAI 的总裁 Greg Brockman 终于坐不住了。他直接发推 Diss Elon Musk,指责他为了打官司,竟然断章取义地把自己私人日记里的片段当成证据 😆。

1 月 14 日下午,Thinking Machines Lab 正在召开全员大会。CEO Mira Murati 站在前面,宣布了一个令所有人震惊的消息:公司已解除联合创始人兼首席技术官 Barret Zoph 的职务,原因是“不道德行为”。会议还没结束,公司 Slack 上又炸了两颗雷,另一位联合创始人 Luke Metz 和创始团队成员 Sam Schoenholz 几乎同时发帖宣布离职。

继奥特曼在 OpenAI 的「宫斗」大戏后,他的老搭档 Mira 这周的经历也够拍一部电视剧了。我们报道了前 OpenAI CTO Mira Murati 创办的 Thinking Machines Lab 出现重大人事变动的消息:联合创始人兼 CTO Barret Zoph 被解雇,另一位联创 Luke Metz 以及创始团队成员 Sam Schoenholz 也一起离开

估值 120 亿美元的明星 AI 公司,创业没几年就把首任 CTO 给开了。就在刚刚,前 OpenAI CTO、Thinking Machines Lab 创始人 Mira Murati 在社交媒体上发了条措辞相当严厉的声明:

今早,媒体人Kylie Robison在社交平台X上发文称,据两位知情人士消息,由前OpenAI首席技术官Mira Murati共同创立的知名AI创企Thinking Machines Lab已解雇其首席技术官Barret Zoph,因其“不道德行为”。

昔日霸主CMU跌落神坛,清华上交联手登顶世界第一,中国高校以「屠榜」之势宣告CS新时代的到来!

《Nature Medicine》 的研究报道“A multimodal sleep foundation model for disease prediction”,研究人员开发了一种名为 SleepFM 的基础模型,从超过58万小时的记录中“学会”了睡眠的语言。这不仅是睡眠科学的进步,更是AI在生物医学领域的深层突围。

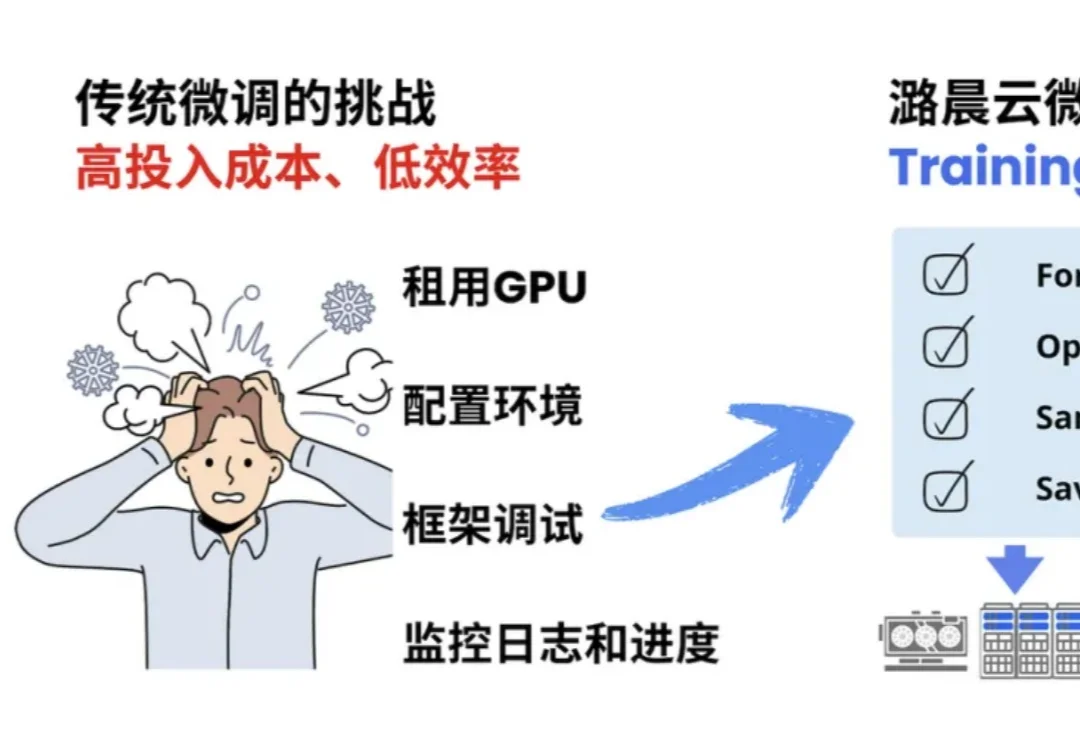

当 OpenAI 前 CTO Mira Murati 创立的 Thinking Machines Lab (TML) 用 Tinker 创新性的将大模型训练抽象成 forward backward,optimizer step 等⼀系列基本原语,分离了算法设计等部分与分布式训练基础设施关联,

文本领域的大模型满分选手,换成语音就集体挂科?大模型引以为傲的多轮对话逻辑,在真实人声面前竟然如此脆弱。Scale AI正式发布首个原生音频多轮对话基准Audio MultiChallenge,直接撕开了大模型靠合成语音评测维持的优等生假象。实验显示,强如Gemini 3 Pro在真实场景下的通过率也仅过半数,而GPT-4o Audio的表现更是令人大跌眼镜。

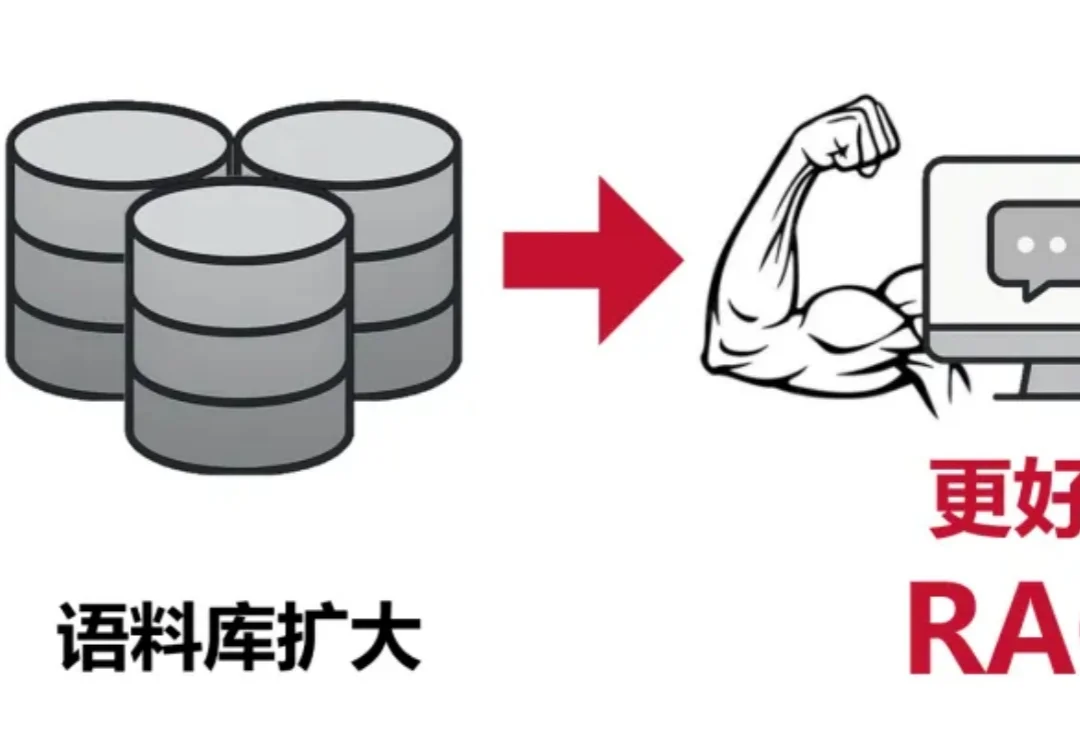

在检索增强生成中,扩大生成模型规模往往能提升准确率,但也会显著抬高推理成本与部署门槛。CMU 团队在固定提示模板、上下文组织方式与证据预算,并保持检索与解码设置不变的前提下,系统比较了生成模型规模与检索语料规模的联合效应,发现扩充检索语料能够稳定增强 RAG,并在多项开放域问答基准上让小中型模型在更大语料下达到甚至超过更大模型在较小语料下的表现,同时在更高语料规模处呈现清晰的边际收益递减。