复旦视频扩散模型综述:覆盖300+文献,探讨近期研究趋势与突破,Github揽星2k+

复旦视频扩散模型综述:覆盖300+文献,探讨近期研究趋势与突破,Github揽星2k+视频扩散模型新综述来了,覆盖300+文献的那种。

视频扩散模型新综述来了,覆盖300+文献的那种。

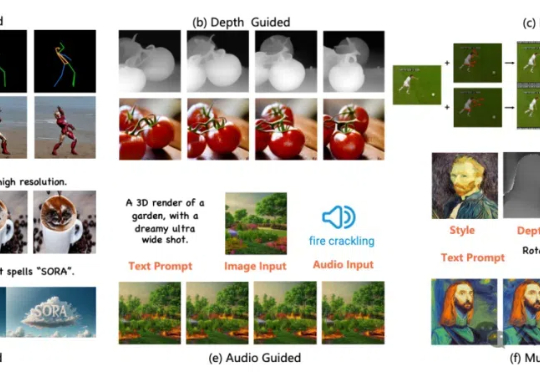

在过去的两年里,城市场景生成技术迎来了飞速发展,一个全新的概念 ——世界模型(World Model)也随之崛起。当前的世界模型大多依赖 Video Diffusion Models(视频扩散模型)强大的生成能力,在城市场景合成方面取得了令人瞩目的突破。然而,这些方法始终面临一个关键挑战:如何在视频生成过程中保持多视角一致性?

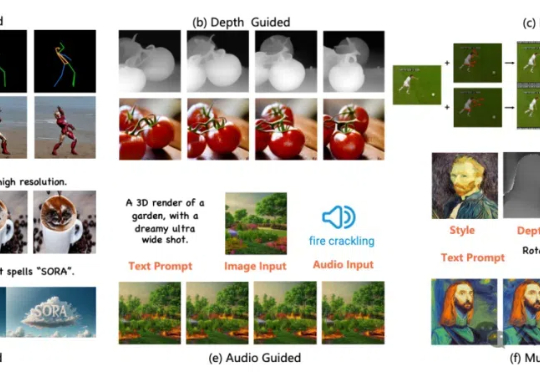

只需一张图,就能生成高质量、广范围的3D场景! 泰迪熊、花园、山谷都从平面图片变成了仿佛触手可及的立体物品。

近日,Stability AI又发布了新作SV3D,基于视频扩散模型的SV3D将3D模型生成的效果提升了一大截,模型权重已在huggingface开放。

Stable Diffusion背后公司Stability AI又上新了。 这次带来的是图生3D方面的新进展: 基于Stable Video Diffusion的Stable Video 3D(SV3D),只用一张图片就能生成高质量3D网格。

2 月 16 日,OpenAI Sora 的发布无疑标志着视频生成领域的一次重大突破。Sora 基于 Diffusion Transformer 架构,和市面上大部分主流方法(由 2D Stable Diffusion 扩展)并不相同。

想要AI生成更长的视频?现在,有人提出了一个效果很不错的免调优方法,直接就能作用于预训练好的视频扩散模型。

在视频生成场景中,用 Transformer 做扩散模型的去噪骨干已经被李飞飞等研究者证明行得通。这可算得上是 Transformer 在视频生成领域取得的一项重大成功。