只要强化学习1/10成本!翁荔的Thinking Machines盯上了Qwen的黑科技

只要强化学习1/10成本!翁荔的Thinking Machines盯上了Qwen的黑科技今天要讲的On-Policy Distillation(同策略/在线策略蒸馏)。这是一个Thinking Machines整的新活,这个新策略既有强化学习等在线策略方法的相关性和可靠性;又具备离线策略(Off-policy)方法的数据效率。

今天要讲的On-Policy Distillation(同策略/在线策略蒸馏)。这是一个Thinking Machines整的新活,这个新策略既有强化学习等在线策略方法的相关性和可靠性;又具备离线策略(Off-policy)方法的数据效率。

刚刚,不发论文、爱发博客的 Thinking Machines Lab (以下简称 TML)再次更新,发布了一篇题为《在策略蒸馏》的博客。在策略蒸馏(on-policy distillation)是一种将强化学习 (RL) 的纠错相关性与 SFT 的奖励密度相结合的训练方法。在将其用于数学推理和内部聊天助手时,TML 发现在策略蒸馏可以极低的成本超越其他方法。

马斯克的终极设想,正在成形。今天,特斯拉放出了「世界模拟器」震撼演示。一个神经网络,每天狂吞500年人类驾驶经验,并在无限的虚拟世界中自我进化。同款AI大脑,擎天柱也可共用。

数据集蒸馏是一种用少量合成数据替代全量数据训练模型的技术,能让模型高效又节能。WMDD和GUARD两项研究分别解决了如何保留原始数据特性并提升模型对抗扰动能力的问题,使模型在少量数据上训练时既准确又可靠。

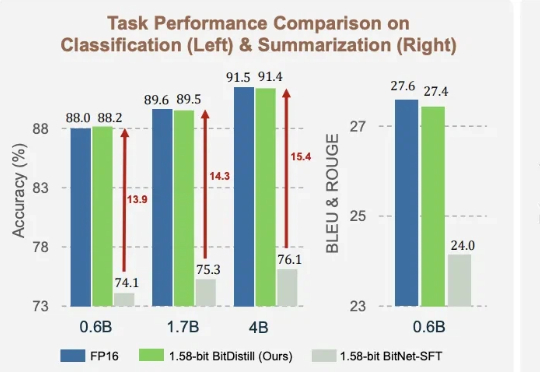

1.58bit量化,内存仅需1/10,但表现不输FP16? 微软最新推出的蒸馏框架BitNet Distillation(简称BitDistill),实现了几乎无性能损失的模型量化。

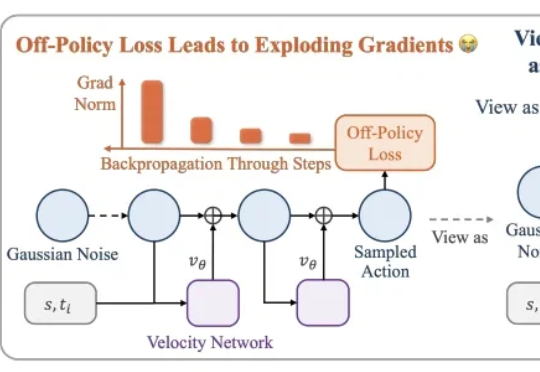

本文介绍了一种用高数据效率强化学习算法 SAC 训练流策略的新方案,可以端到端优化真实的流策略,而无需采用替代目标或者策略蒸馏。SAC FLow 的核心思想是把流策略视作一个 residual RNN,再用 GRU 门控和 Transformer Decoder 两套速度参数化。

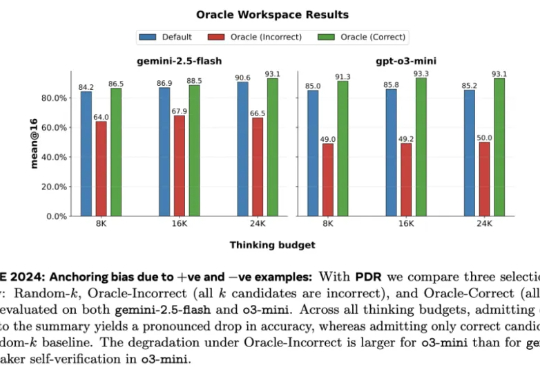

Meta 超级智能实验室、伦敦大学学院、Mila、Anthropic 等机构的研究者进行了探索。从抽象层面来看,他们将 LLM 视为其「思维」的改进操作符,实现一系列可能的策略。研究者探究了一种推理方法家族 —— 并行 - 蒸馏 - 精炼(Parallel-Distill-Refine, PDR),

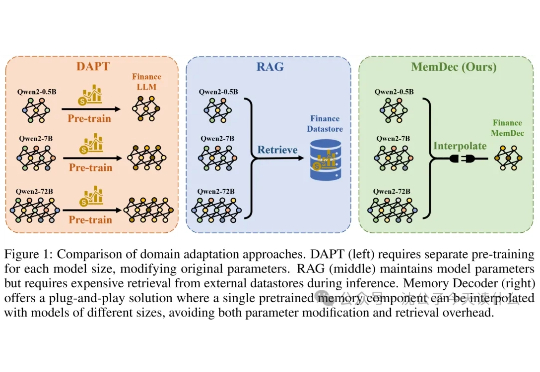

一句话概括,还在嫌弃RAG太慢?这帮研究员直接把检索数据库"蒸馏"成了一个小模型,实现了不检索的检索增强,堪称懒人福音。

网友在推特上爆料,一位Mistral离职女员工群发邮件,直指公司多项黑幕。其中最劲爆的就是:Mistral最新模型疑似直接蒸馏自DeepSeek,却对外包装成RL成功案例,并刻意歪曲基准测试结果。

AI视频生成进入了秒生极速时代!UCSD等机构发布的FastWan系模型,在一张H200上,实现了5秒即生视频。稀疏蒸馏,让去噪时间大减,刷新SOTA。