Sora之后,视频生成模型的中国牌局

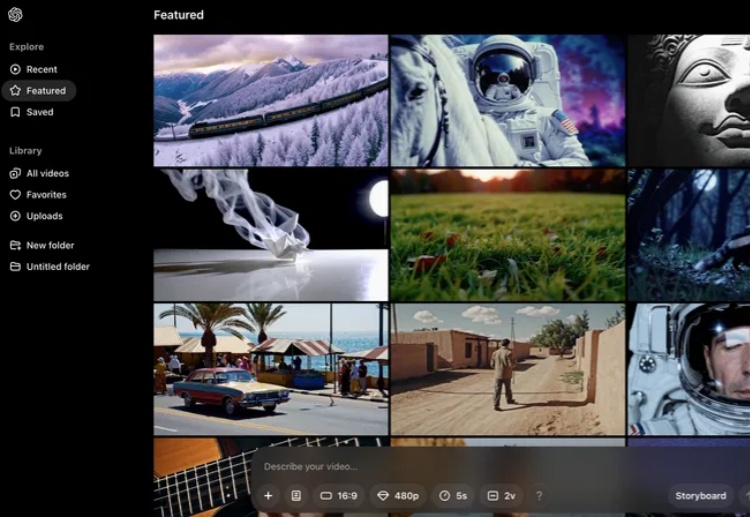

Sora之后,视频生成模型的中国牌局大模型的牌局,国内企业正在找到自己的节奏感。Sora,自2月16日OpenAI发布后一直被吐槽是“技术期货”,终于在12月10日,正式版Sora露面了,可以生成最高 1080p 分辨率、最长 20 秒的视频。

大模型的牌局,国内企业正在找到自己的节奏感。Sora,自2月16日OpenAI发布后一直被吐槽是“技术期货”,终于在12月10日,正式版Sora露面了,可以生成最高 1080p 分辨率、最长 20 秒的视频。

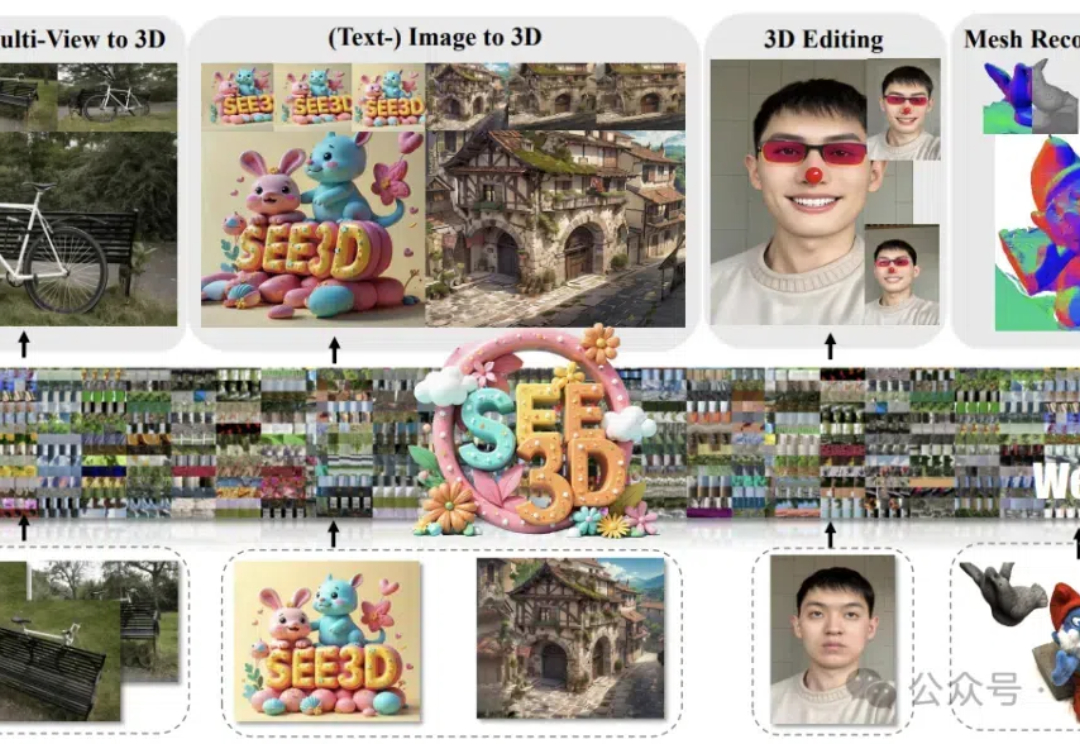

上周,李飞飞空间智能首个3D生成模型刚刚交卷。这边,国内来自智源的See3D模型,在学习了无标注的1600万个视频之后,重建出全新的3D世界,效果令人惊叹。

今天凌晨,在Open AI第三天的年终直播中,山姆·奥特曼终于官宣面向大众上线视频生成模型Sora。

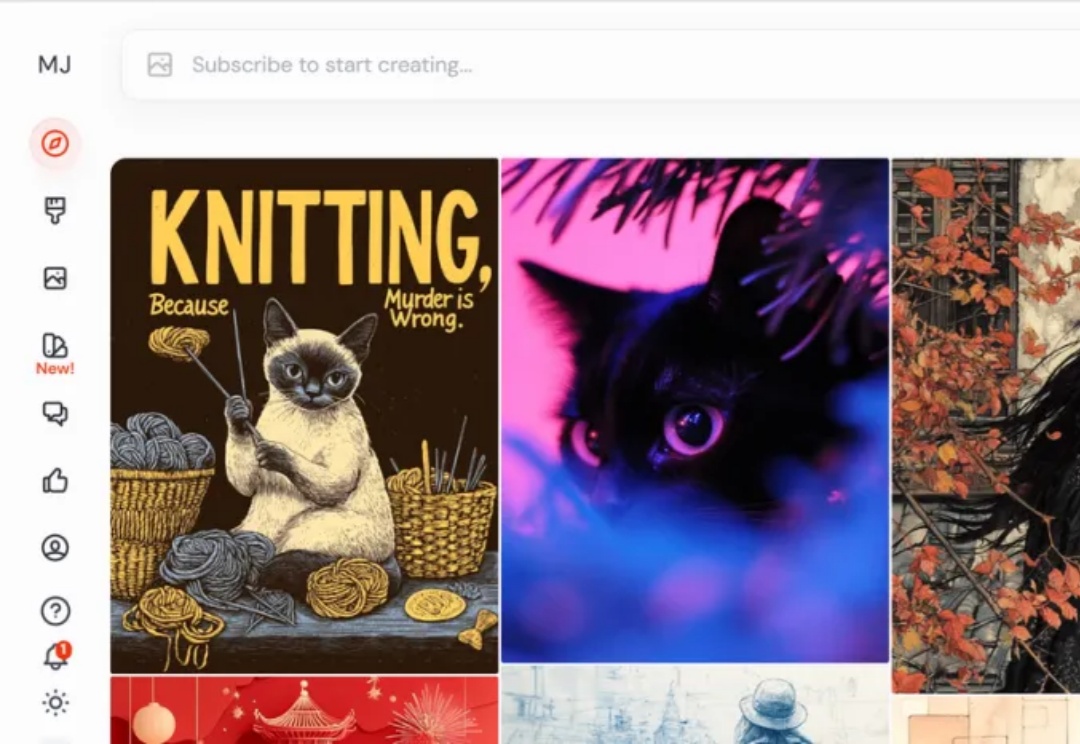

OpenAI 连续 12 天 “Shipmas”发布活动终于要发布让大家期待已久的视频生成模型 Sora,这再一次激起人们对图片生成、视频生成的关注。而AI Creativity 一直是我们非常关注的 GenAI 落地方向,图像生成和视频生成模型快速迭代,离商业可用越来越近。

OpenAI发布会直播第3天,继第1天完全版o1和200美元月费ChatGPT Pro会员,以及第2天的强化微调工具后,OpenAI终于填上9个月前的期货大坑,正式发布了观众敲碗已久的全新视频生成模型——Sora Turbo。

埃隆·马斯克 (Elon Musk) 最近将 Grok AI 的可用性扩展至每个 X 用户,几个小时后,Grok 的母公司 xAI 宣布了其最新的图像生成模型 Aurora,可从 X 上的 Grok 助手中访问。然而,在推出后的最初几个小时内,一些用户已经无法访问 Aurora,而原因目前尚不清楚。

MinMax海螺AI新模型,让2D角色动起来了!

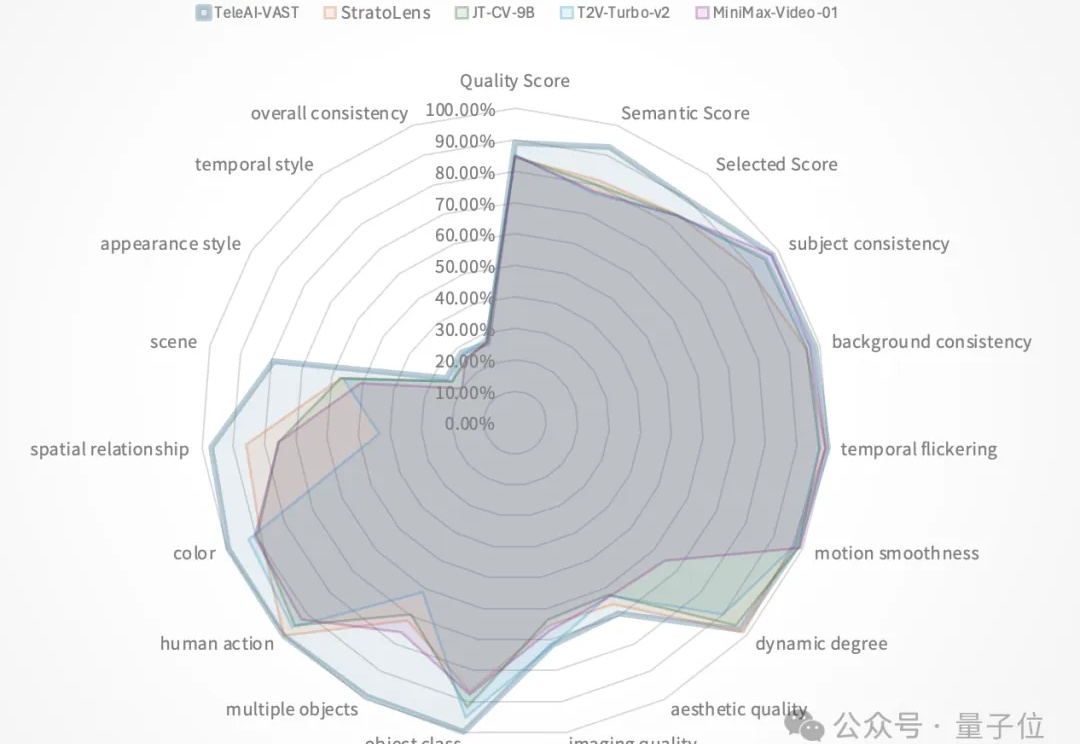

视频生成模型评测权威榜单VBench,突遭“屠榜”。

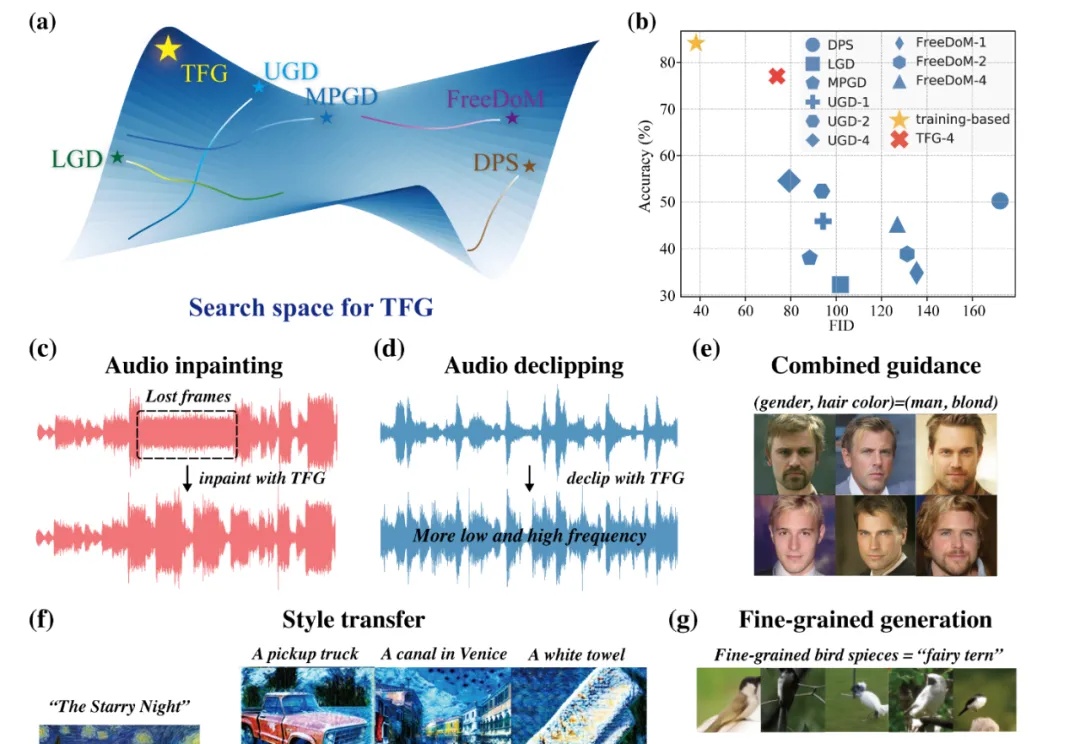

近年来,扩散模型(Diffusion Models)已成为生成模型领域的研究前沿,它们在图像生成、视频生成、分子设计、音频生成等众多领域展现出强大的能力。

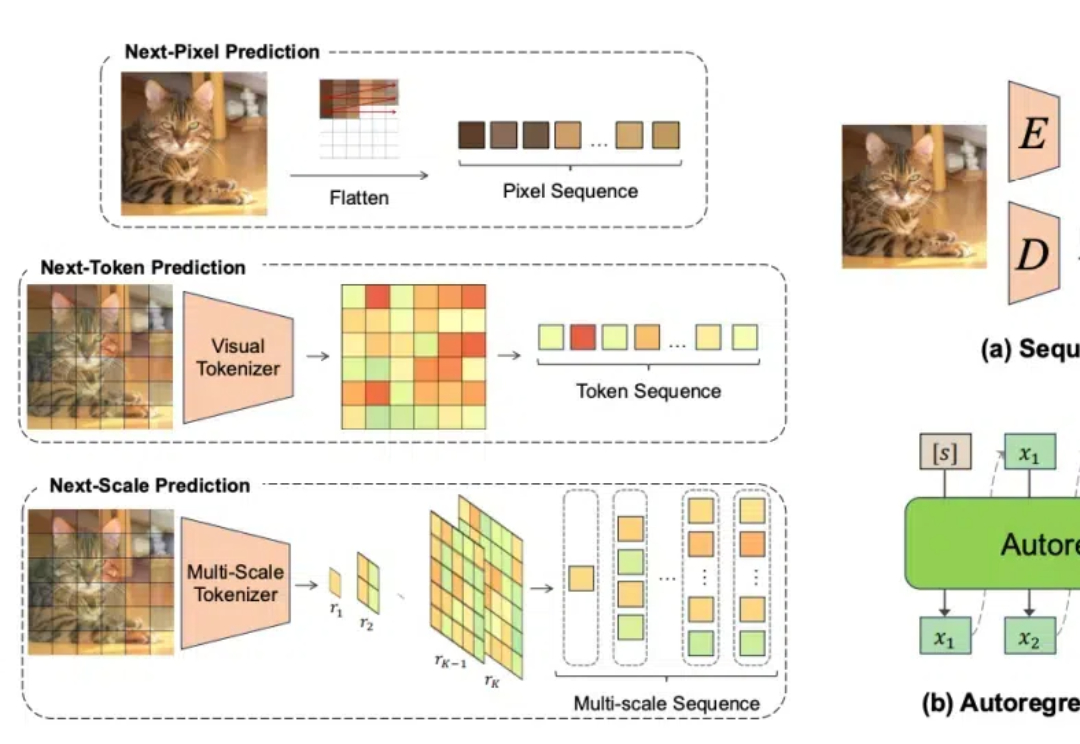

随着计算机视觉领域的不断发展,自回归模型作为一种强大的生成模型,在图像生成、视频生成、3D 生成和多模态生成等任务中展现出了巨大的潜力。然而,由于该领域的快速发展,及时、全面地了解自回归模型的研究现状和进展变得至关重要。本文旨在对视觉领域中的自回归模型进行全面综述,为研究人员提供一个清晰的参考框架。