全球首个造物 Agent,Leewow把 AI 生图变成快递送到家

全球首个造物 Agent,Leewow把 AI 生图变成快递送到家创意这东西保质期很短,那股兴奋劲儿一过,大多数想法就不了了之。直到最近我在看一批新的 AI 产品时,碰到了 Leewow。

创意这东西保质期很短,那股兴奋劲儿一过,大多数想法就不了了之。直到最近我在看一批新的 AI 产品时,碰到了 Leewow。

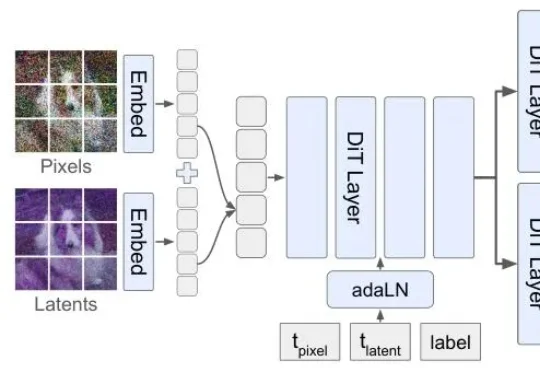

但扩散模型生图,顺序真的对吗?李飞飞团队最新论文提出的Latent Forcing方法直接打破了这一共识,他们发现生成的质量瓶颈不在架构,而在顺序。

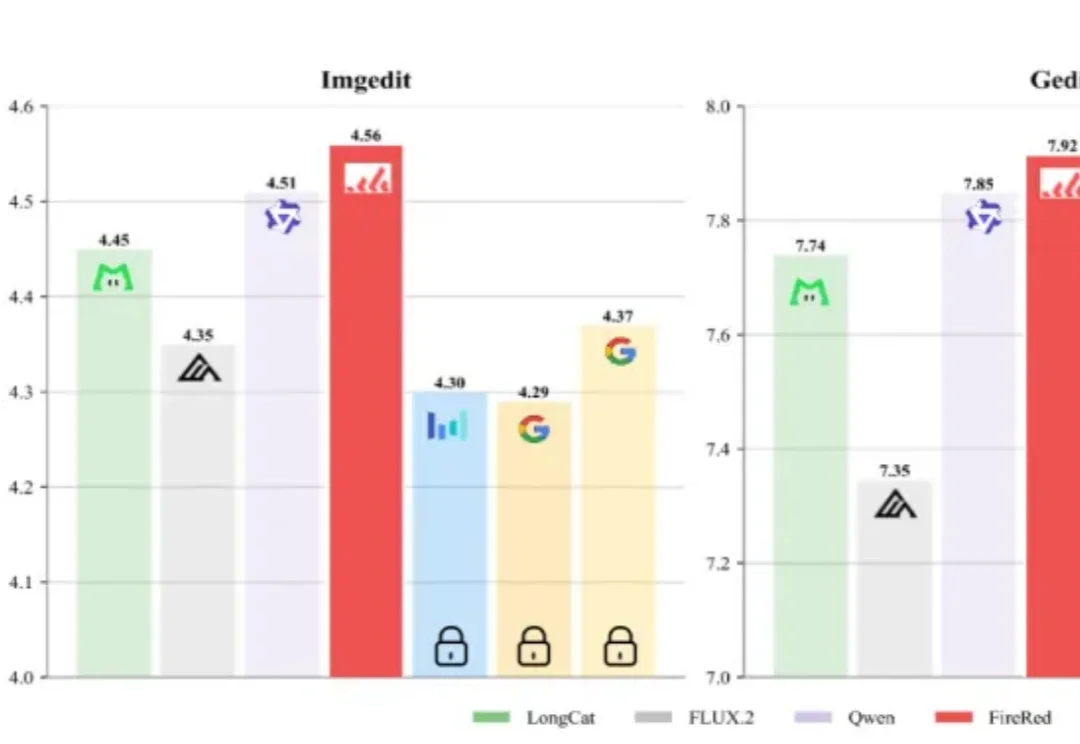

AI生图领域,又出了个“狠角色”。

AI生成一张图片,你愿意等多久?在主流扩散模型还在迭代中反复“磨叽”、让用户盯着进度条发呆时,阿里智能引擎团队直接把进度条“拉爆”了——5秒钟,到手4张2K级高清大图。

现如今,任意打开一款AI社交应用,映入眼帘的可能是这样的画面:银发高马尾的少女、带着猫耳的少年、暗黑覆面系的成熟青年……但核心标签始终离不开三个字:二次元。

一句话P电商海报、一键换装滑冰。

过去一年,AI的主战场几乎被大模型、生图和生视频占满。2026年伊始,市场终于开始把目光投向一个更难、也更关键的领域:3D生成。

编辑|Panda 在文生图模型的技术版图中,VAE 几乎已经成为共识。从 Stable Diffusion 到 FLUX,再到一系列扩散 Transformer,主流路线高度一致:先用 VAE 压缩视

北邮最新综述探讨了文生图扩散模型的可控生成技术,总结了在文本条件之外引入新条件信号的方法,从任务和方法两个层面梳理了可控生成技术。

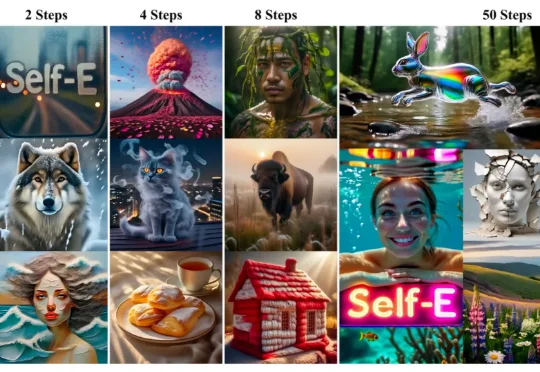

香港大学(The University of Hong Kong)与 Adobe Research 联合发布 Self-E(Self-Evaluating Model):一种无需预训练教师蒸馏、从零开始训练的任意步数文生图框架。其目标非常直接:让同一个模型在极少步数也能生成语义清晰、结构稳定的图像,同时在 50 步等常规设置下保持顶级质量,并且随着步数增加呈现单调提升。