硬核解决Sora的物理bug!美国四所顶尖高校联合发布:给视频生成器装个物理引擎

硬核解决Sora的物理bug!美国四所顶尖高校联合发布:给视频生成器装个物理引擎Sora刚发布后没多久,火眼金睛的网友们就发现了不少bug,比如模型对物理世界知之甚少,小狗在走路的时候,两条前腿就出现了交错问题,让人非常出戏。 对于生成视频的真实感来说,物体的交互非常重要,但目前来说,合成真实3D物体在交互中的动态行为仍然非常困难。

Sora刚发布后没多久,火眼金睛的网友们就发现了不少bug,比如模型对物理世界知之甚少,小狗在走路的时候,两条前腿就出现了交错问题,让人非常出戏。 对于生成视频的真实感来说,物体的交互非常重要,但目前来说,合成真实3D物体在交互中的动态行为仍然非常困难。

如今的生成式AI在人工智能领域迅猛发展,在计算机视觉中,图像和视频生成技术已日渐成熟,如Midjourney、Stable Video Diffusion [1]等模型广泛应用。然而,三维视觉领域的生成模型仍面临挑战。

过去一年,AI大模型无疑是科技行业中最亮眼的主角,从FAAMG到BAT、再到一众初创企业,无数优秀的大脑、海量的资源都投入到了这个有望解放人类生产力的赛道中。

Meta最近开源的Llama 3模型再次证明了「数据」是提升性能的关键,但现状是,开源的大模型有一堆,可开源的大规模数据却没多少,而收集、清洗数据又是一项极其费时费力的工作,也导致了大模型预训练技术仍然掌握在少数高端机构的手中。

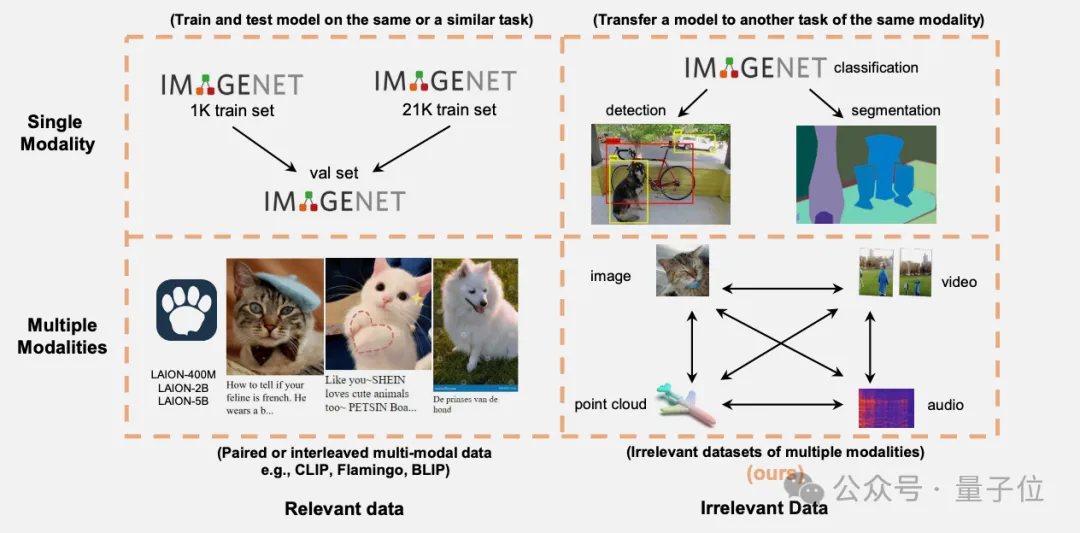

万万没想到,与任务无直接关联的多模态数据也能提升Transformer模型性能。

“预测下一个token”被认为是大模型的基本范式,一次预测多个tokens又会怎样?

语言建模领域的最新进展在于在极大规模的网络文本语料库上预训练高参数化的神经网络。在实践中,使用这样的模型进行训练和推断可能会成本高昂,这促使人们使用较小的替代模型。然而,已经观察到较小的模型可能会出现饱和现象,表现为在训练的某个高级阶段性能下降并趋于稳定。

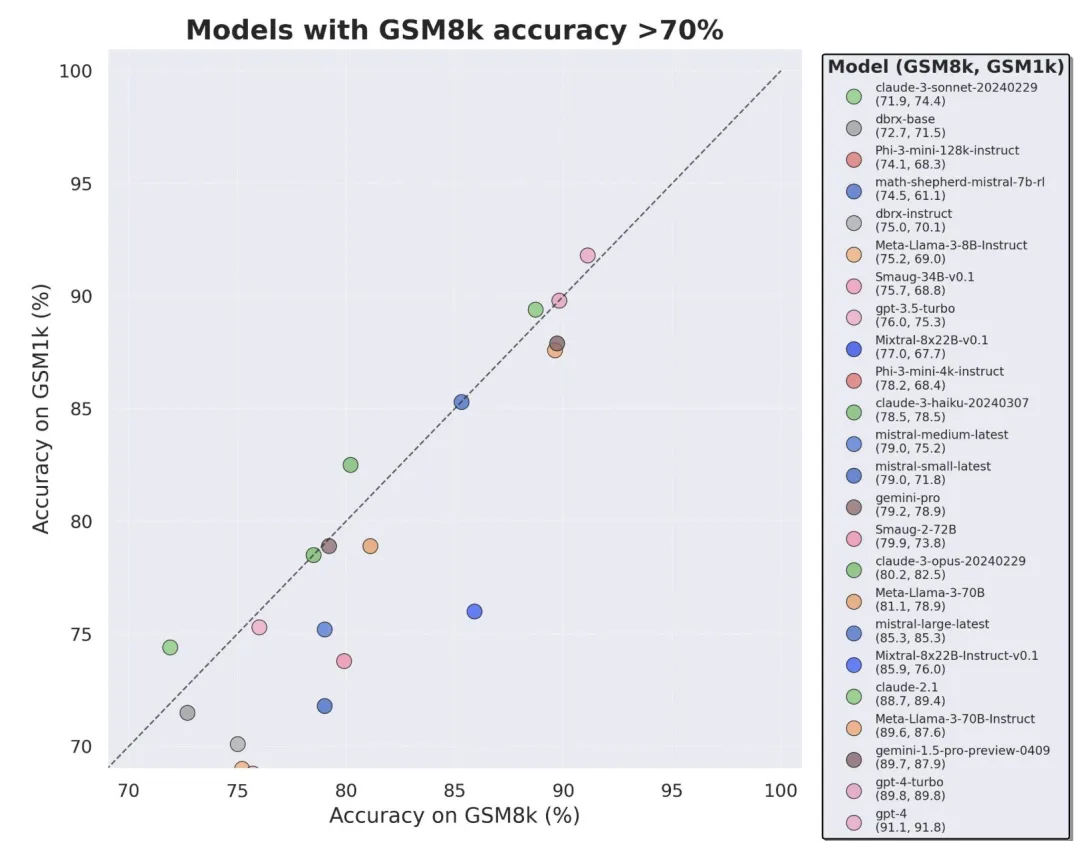

当前最火的大模型,竟然三分之二都存在过拟合问题?

自2021年诞生,CLIP已在计算机视觉识别系统和生成模型上得到了广泛的应用和巨大的成功。我们相信CLIP的创新和成功来自其高质量数据(WIT400M),而非模型或者损失函数本身。虽然3年来CLIP有大量的后续研究,但并未有研究通过对CLIP进行严格的消融实验来了解数据、模型和训练的关系。

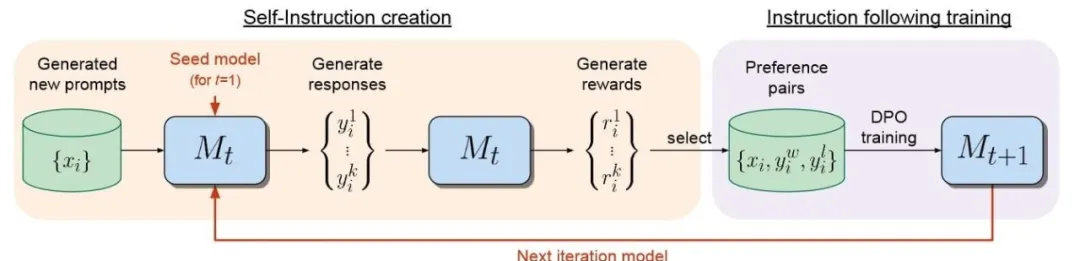

在大语言模型领域,微调是改进模型的重要步骤。伴随开源模型数量日益增多,针对LLM的微调方法同样在推陈出新。