Flash Attention稳定吗?Meta、哈佛发现其模型权重偏差呈现数量级波动

Flash Attention稳定吗?Meta、哈佛发现其模型权重偏差呈现数量级波动众所周知,大语言模型的训练常常需要数月的时间,使用数百乃至上千个 GPU。以 LLaMA2 70B 模型为例,其训练总共需要 1,720,320 GPU hours。由于这些工作负载的规模和复杂性,导致训练大模型存在着独特的系统性挑战。

众所周知,大语言模型的训练常常需要数月的时间,使用数百乃至上千个 GPU。以 LLaMA2 70B 模型为例,其训练总共需要 1,720,320 GPU hours。由于这些工作负载的规模和复杂性,导致训练大模型存在着独特的系统性挑战。

大模型回答如何更可靠?MIT研究团队设计出「共识博弈」,将数学家常用的博弈论引入LLM改进中。没想到,LLaMA-7B的表现,击败了LLaMA-65B,甚至与PaLM-540B相媲美。

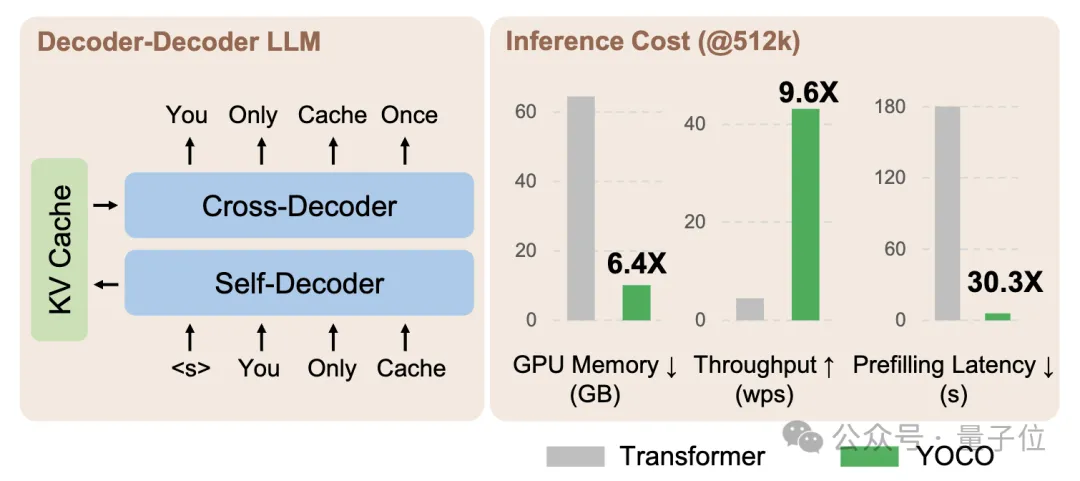

微软&清华最新研究,打破GPT系列开创的Decoder-Only架构——

Richard Sutton 在 「The Bitter Lesson」中做过这样的评价:「从70年的人工智能研究中可以得出的最重要教训是,那些利用计算的通用方法最终是最有效的,而且优势巨大。」

在一个昏暗的机箱里,一台 RTX 3090 GPU「唱」着经典英语儿歌《一闪一闪亮晶晶》(Twinkle,Twinkle,Little Star)的旋律。

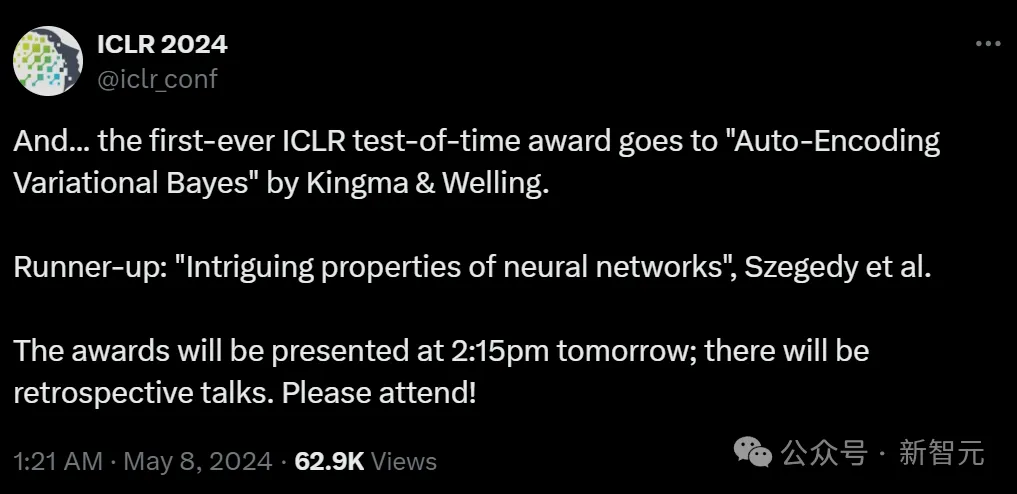

当地时间5月7日,ICLR 2024颁发了自大会举办以来的首个「时间检验奖」!

DeepMind新发布的AlphaFold 3是科技圈今天的绝对大热门,成为了Hacker News等许多科技媒体的头版头条。

传统上,大型语言模型(LLMs)被认为是顺序解码器,逐个解码每个token。

众多神经网络模型中都会有一个有趣的现象:不同的参数值可以得到相同的损失值。这种现象可以通过参数空间对称性来解释,即某些参数的变换不会影响损失函数的结果。基于这一发现,传送算法(teleportation)被设计出来,它利用这些对称变换来加速寻找最优参数的过程。尽管传送算法在实践中表现出了加速优化的潜力,但其背后的确切机制尚不清楚。

由深度学习巨头、图灵奖获得者 Yoshua Bengio 和 Yann LeCun 在 2013 年牵头举办的 ICLR 会议,在走过第一个十年后,终于迎来了首届时间检验奖。