仅靠开源数据复刻出LLaMA3指令学习效果,在线迭代RLHF全流程解决方案来了

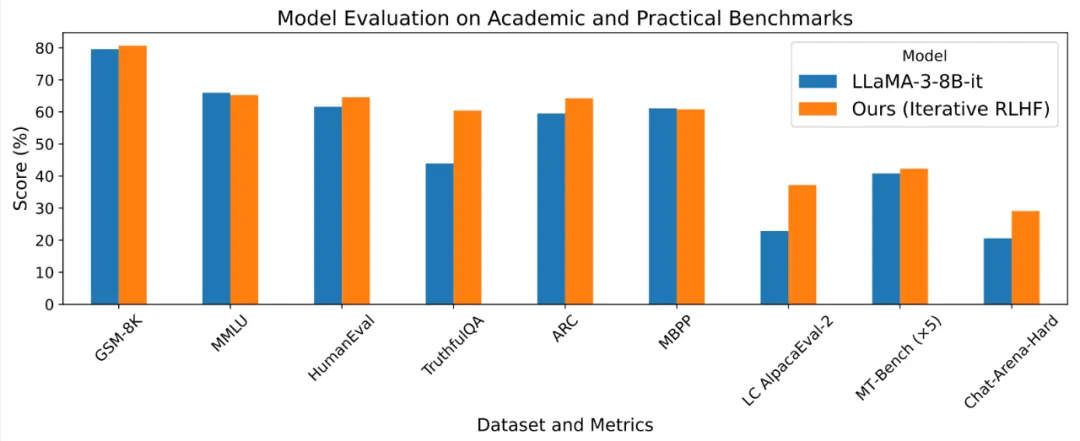

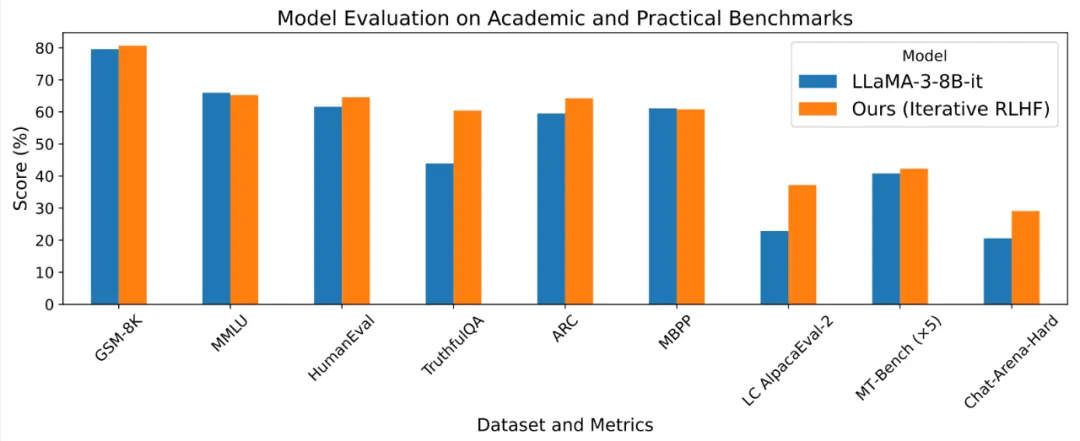

仅靠开源数据复刻出LLaMA3指令学习效果,在线迭代RLHF全流程解决方案来了基于人类反馈的强化学习 (RLHF) 使得大语言模型的输出能够更加符合人类的目标、期望与需求,是提升许多闭源语言模型 Chat-GPT, Claude, Gemini 表现的核心方法之一。

基于人类反馈的强化学习 (RLHF) 使得大语言模型的输出能够更加符合人类的目标、期望与需求,是提升许多闭源语言模型 Chat-GPT, Claude, Gemini 表现的核心方法之一。

本周,生成式 AI 的竞争达到了新的高潮。

前有OpenAI的GPT-4o,后有谷歌的系列王炸,先进的多模态大模型接连炸场。

最近一周KAN的热度逐渐褪去,正好静下心来仔细学习KAN的原理,收获颇多。

生成式AI时代,数据编织将成为下一代数据管理的主流范式。

在大型语言模型的训练过程中,数据的处理方式至关重要。

本论文作者包括帝国理工学院硕士生杨润一、北航二年级硕士生朱贞欣、北京理工大学二年级硕士生姜洲、北京理工大学四年级本科生叶柏均、中国科学院大学本科大三学生张逸飞、中国电信人工智能研究院多媒体认知学习实验室(EVOL Lab)负责人赵健、清华大学智能产业研究院(AIR)助理教授赵昊等。

在《如何制造一个垂直领域大模型》一文中我们列举了几种开发垂直领域模型的方法。其中医疗、法律等专业是比较能体现模型垂直行业能力的,因此也深受各大厂商的重视。

关于大模型分词(tokenization),大神Karpathy刚刚推荐了一篇必读新论文。

随着深度学习大语言模型的越来越火爆,大语言模型越做越大,使得其推理成本也水涨船高。模型量化,成为一个热门的研究课题。