最高提速1440倍!15秒用GCN搞定随机规划,中科院自动化所新成果入选ICML 24

最高提速1440倍!15秒用GCN搞定随机规划,中科院自动化所新成果入选ICML 24仅需15秒即可搞定随机规划问题,速度比传统方法快了1440倍!

仅需15秒即可搞定随机规划问题,速度比传统方法快了1440倍!

在人工智能迅猛发展的今天,我们不断探索着机器的智能化,但却往往忽视了这些智能体如何深层地理解我们 —— 它们的创造者。

混合专家,也得术业有专攻。

用 FlexAttention 尝试一种新的注意力模式。

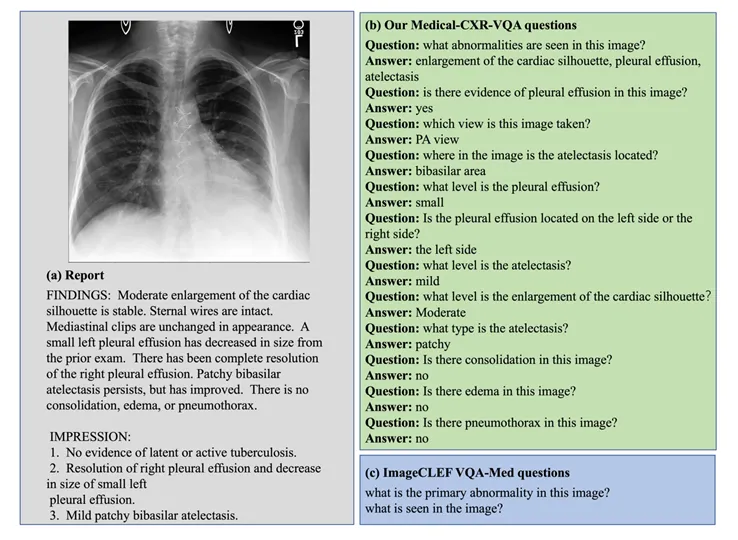

多模态大语言模型 (Multimodal Large Language Moodel, MLLM) 以其强大的语言理解能力和生成能力,在各个领域取得了巨大成功。

LLM数学水平不及小学生怎么办?CMU清华团队提出了Lean-STaR训练框架,在语言模型进行推理的每一步中都植入CoT,提升了模型的定理证明能力,成为miniF2F上的新SOTA。

RLHF到底是不是强化学习?最近,AI大佬圈因为这个讨论炸锅了。和LeCun同为质疑派的Karpathy表示:比起那种让AlphaGo在围棋中击败人类的强化学习,RLHF还差得远呢。

假如你目前正在使用和研究类似CAMEL的多智能体系统,现在已经有了扮演研究者的Agent和负责写论文的Agent,再添加一个事实核查Agent会改善结果吗?

前段时间冲上热搜的问题「9.11比9.9大吗?」,让几乎所有LLM集体翻车。看似热度已过,但AI界大佬Andrej Karpathy却从中看出了当前大模型技术的本质缺陷,以及未来的潜在改进方向。

用光训练神经网络,清华成果最新登上了Nature!