港大黄超团队推出AnyGraph, 首次揭秘图大模型的Scaling Law

港大黄超团队推出AnyGraph, 首次揭秘图大模型的Scaling Law本文的主要作者来自香港大学的数据智能实验室 (Data Intelligence Lab@HKU)。

本文的主要作者来自香港大学的数据智能实验室 (Data Intelligence Lab@HKU)。

人工神经网络、深度学习方法和反向传播算法构成了现代机器学习和人工智能的基础。但现有方法往往是一个阶段更新网络权重,另一个阶段在使用或评估网络时权重保持不变。这与许多需要持续学习的应用程序形成鲜明对比。

最近,又一款国产 AI 神器吸引了众网友和圈内研究人员的关注!它就是全新的图像和视频生成控制工具 —— ControlNeXt,由思谋科技创始人、港科大讲座教授贾佳亚团队开发。

最近,Meta的多个工程团队联合发表了一篇论文,描述了在引入基于GPU的分布式训练时,他们如何为其「量身定制」专用的数据中心网络。

EasyRec利用语言模型的语义理解能力和协同过滤技术,提升了在零样本学习场景下的推荐性能。通过整合用户和物品的文本描述,EasyRec能够生成高质量的语义嵌入,实现个性化且适应性强的推荐。

来自复旦大学视觉与学习实验室的研究者们提出了一种新型的面向视频模型的对抗攻击方法 - 基于扩散模型的视频非限制迁移攻击(ReToMe-VA)。该方法采用逐时间步对抗隐变量优化策略,以实现生成对抗样本的空间不可感知性;同时,在生成对抗帧的去噪过程中引入了递归 token 合并策略,通过匹配及合并视频帧之间的自注意力 token,显著提升了对抗视频的迁移性和时序一致性。

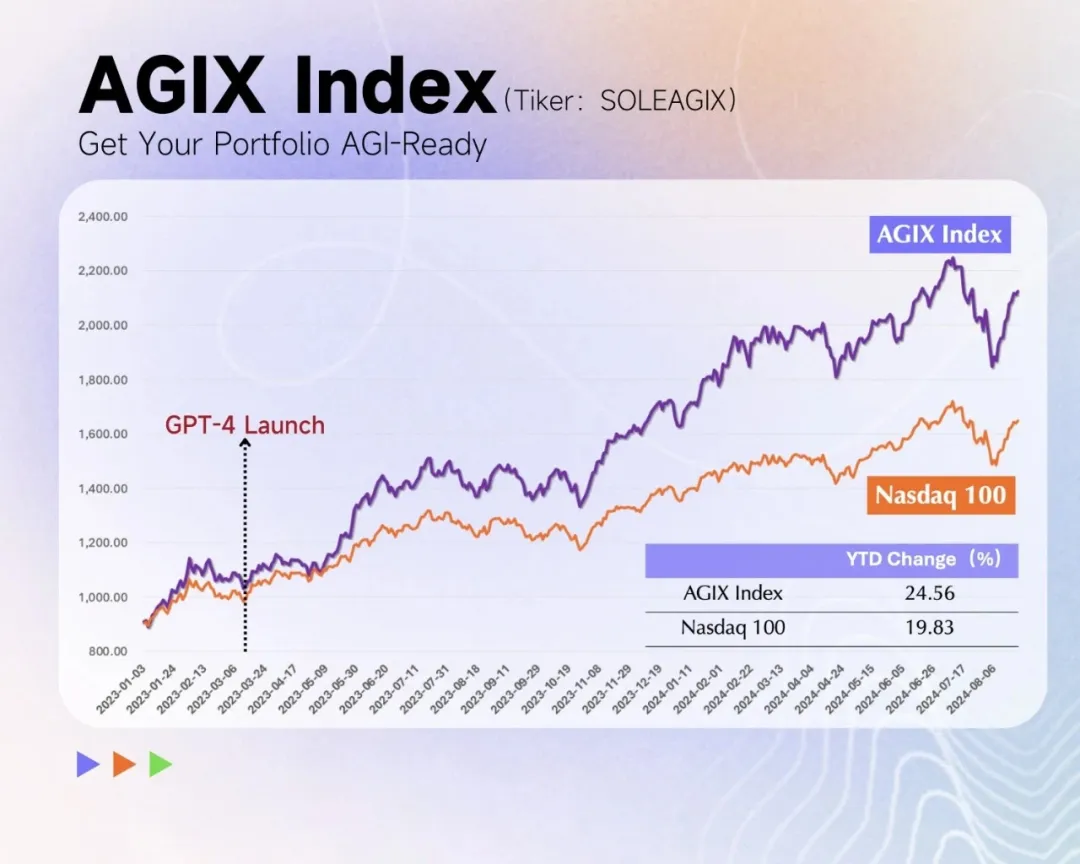

AGI 正在迎来新范式,RL 是 LLM 的秘密武器。

计算机是二进制的世界,所以浮点数也是用二进制来表示的,与整型不同的是,浮点数通过3个区间来表示:

「相比于强化学习(RL),我确实更喜欢模型预测控制(MPC)。至少从 2016 年起,我就一直在强调这一点。强化学习在学习任何新任务时都需要进行极其大量的尝试。相比之下,模型预测控制是零样本的:如果你有一个良好的世界模型和一个良好的任务目标,模型预测控制就可以在不需要任何特定任务学习的情况下解决新任务。这就是规划的魔力。这并不意味着强化学习是无用的,但它的使用应该是最后的手段。」

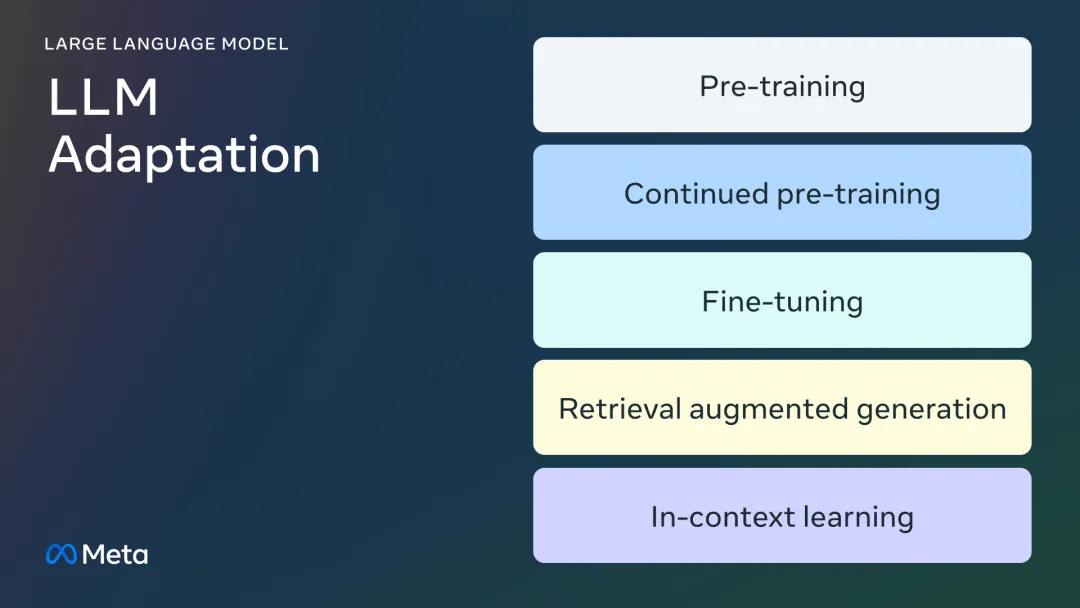

微调的所有门道,都在这里了。