红熊AI获 5500 万融资:补大模型 “失忆” 短板,AI 记忆科学撑起5亿估值

红熊AI获 5500 万融资:补大模型 “失忆” 短板,AI 记忆科学撑起5亿估值在AI客服这个看似红海的赛道里,几乎每个人都遇到过这样的尴尬:明明刚刚告诉AI你的会员账号,转个身的功夫它就不记得了。这种被称为“金鱼脑”的AI失忆现象,正是大模型在企业级应用中最大的痛点。

在AI客服这个看似红海的赛道里,几乎每个人都遇到过这样的尴尬:明明刚刚告诉AI你的会员账号,转个身的功夫它就不记得了。这种被称为“金鱼脑”的AI失忆现象,正是大模型在企业级应用中最大的痛点。

Transformer 架构对计算和内存的巨大需求使得大模型效率的提升成为一大难题。为应对这一挑战,研究者们投入了大量精力来设计更高效的 LM 架构。

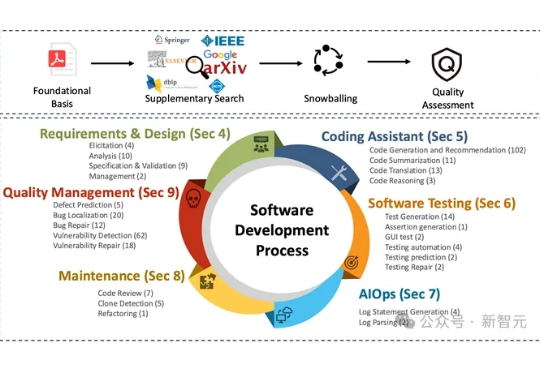

大语言模型正加速重塑软件工程领域的各个环节,从需求分析到代码生成,再到自动化测试,几乎无所不能,但衡量这些模型到底「好不好用」、「好在哪里」、「还有哪些短板」,一直缺乏系统、权威的评估工具。

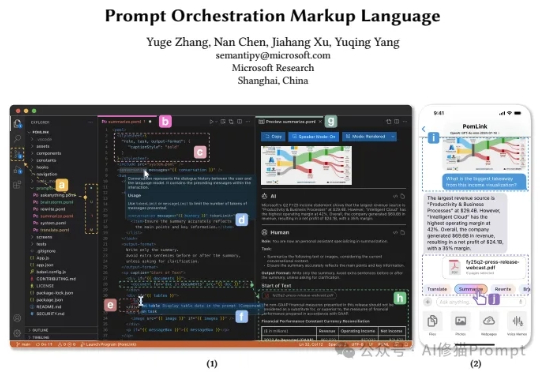

最近来自微软的研究者们带来了一个全新的思路,他们开源发布了POML(Prompt Orchestration Markup Language),它的的解决方案它的核心思想非常直接:为什么我们不能像开发网页一样,用工程化的思维来构建和管理我们的Prompt呢?这个编排语言很类似IBM的PDL

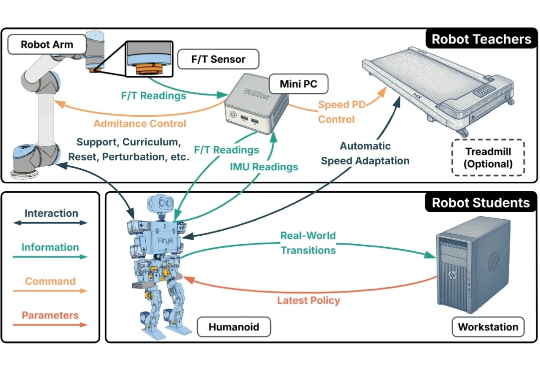

人形机器人的运动控制,正成为强化学习(RL)算法应用的下一个热点研究领域。当前,主流方案大多遵循 “仿真到现实”(Sim-to-Real)的范式。研究者们通过域随机化(Domain Randomization)技术,在成千上万个具有不同物理参数的仿真环境中训练通用控制模型,期望它能凭借强大的泛化能力,直接适应动力学特性未知的真实世界。

昨晚,神秘且强大的图像生成与编辑模型 nano banana 终于正式显露真身。没有意外,它果然来自谷歌,并且也获得了一个正式但无趣的名字:gemini-2.5-flash-image-preview。

今天,我们正式开源 8B 参数的面壁小钢炮 MiniCPM-V 4.5 多模态旗舰模型,成为行业首个具备“高刷”视频理解能力的多模态模型,看得准、看得快,看得长!高刷视频理解、长视频理解、OCR、文档解析能力同级 SOTA,且性能超过 Qwen2.5-VL 72B,堪称最强端侧多模态模型。

上周三,DeepSeek 开源了新的基础模型,但不是万众期待的 V4,而是 V3.1-Base,而更早时候,DeepSeek-V3.1 就已经上线了其网页、App 端和小程序。

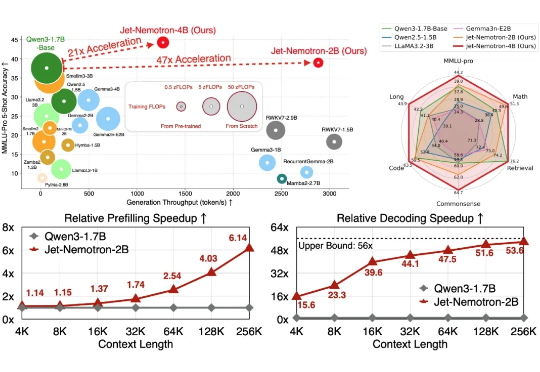

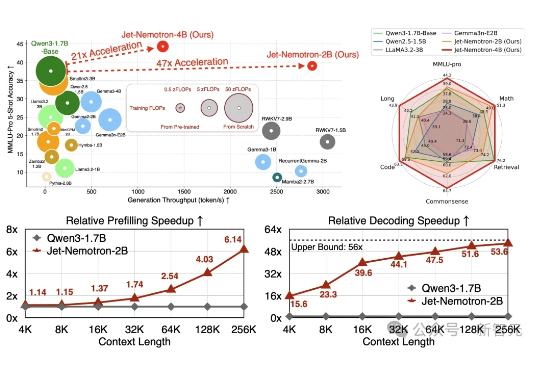

Jet-Nemotron是英伟达最新推出的小模型系列(2B/4B),由全华人团队打造。其核心创新在于提出后神经架构搜索(PostNAS)与新型线性注意力模块JetBlock,实现了从预训练Transformer出发的高效架构优化。

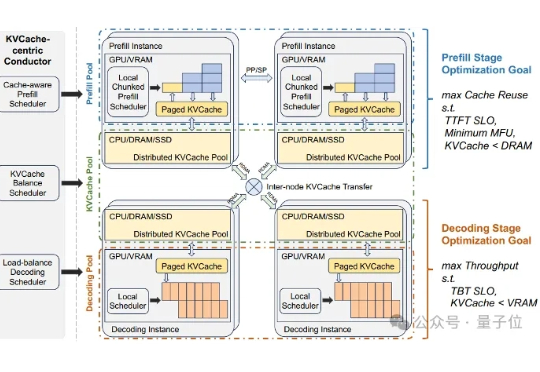

当大语言模型(LLM)走向千行百业,推理效率与显存成本的矛盾日益尖锐。