中国团队引领太空算力:首次太空在轨部署通用大模型,发2800颗卫星服务数亿硅基智能体

中国团队引领太空算力:首次太空在轨部署通用大模型,发2800颗卫星服务数亿硅基智能体岁末年初,全球AI竞争聚焦到了最新趋势—— 太空算力。

岁末年初,全球AI竞争聚焦到了最新趋势—— 太空算力。

刚刚,Clawdbot之父在采访中自曝了惊魂瞬间:这个AI回答自己的那一刻,简直让人后背发凉!10天手搓爆火智能体,GitHub一天狂飙1374次提交,一个人撬动的力量足以震撼几大科技巨头——AGI真的近了。

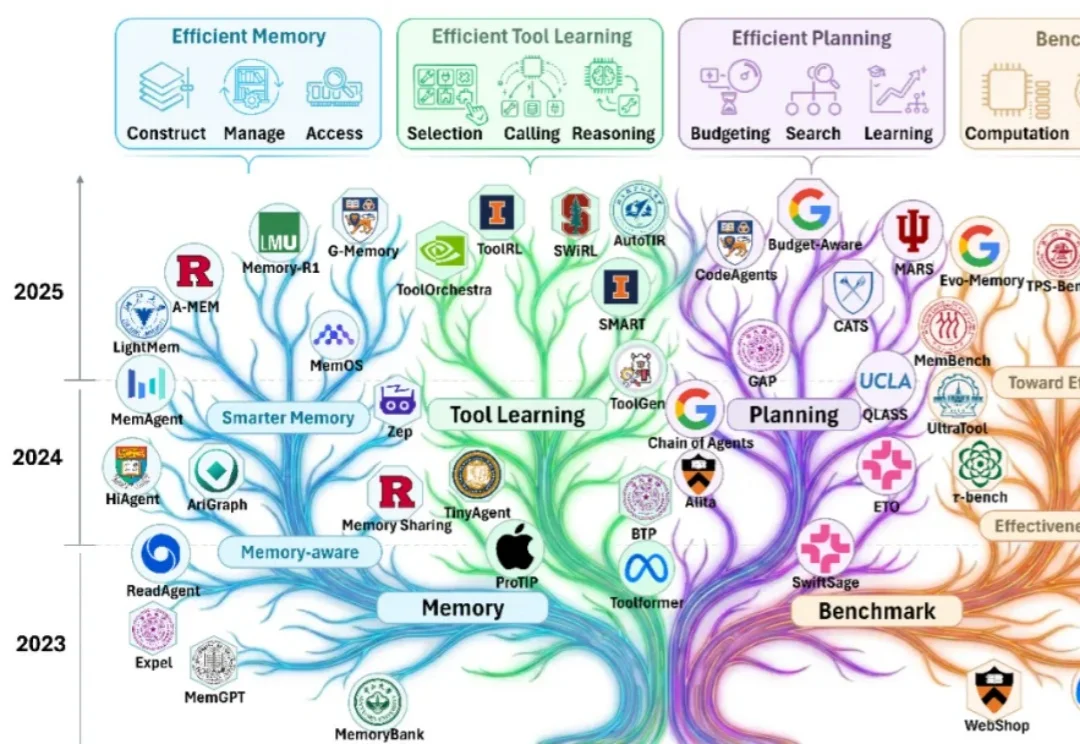

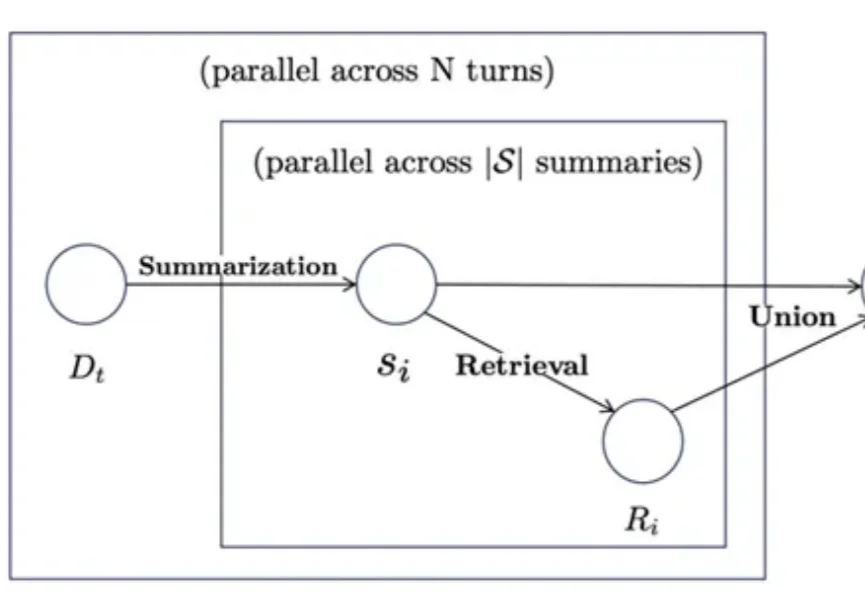

随着大模型能力的跃迁,业界关注点正在从 “模型能不能做” 快速转向 “智能体能不能落地”。过去一年可以看到大量工作在提升智能体的有效性(effectiveness):如何让它更聪明、更稳、更会用工具、更能完成复杂任务。

讯飞星辰智能体平台升级,创建数字人、多模态交互、自动执行全配齐。

Skills刚爆火,又有新的Agent范式来搅局了……

思维导图曾被证明可以帮助学习障碍者快速提升成绩,那么当前已经可堪一用的智能体系统如果引入类似工具是否可以帮助改善长期学习记忆能力呢?有研究团队做出了探索性尝试。

革命性AI开源智能体—Clawdbot火了, 看看投资人Rahul Sood怎么说, 他也是Microsoft Ventures创始人。I've been messing with Clawdbot this week and I get the hype.

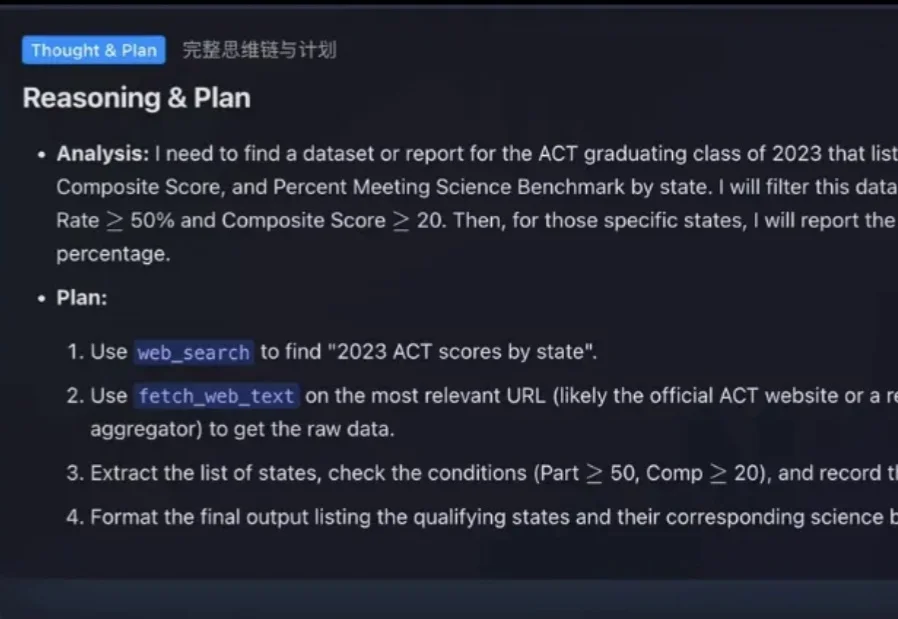

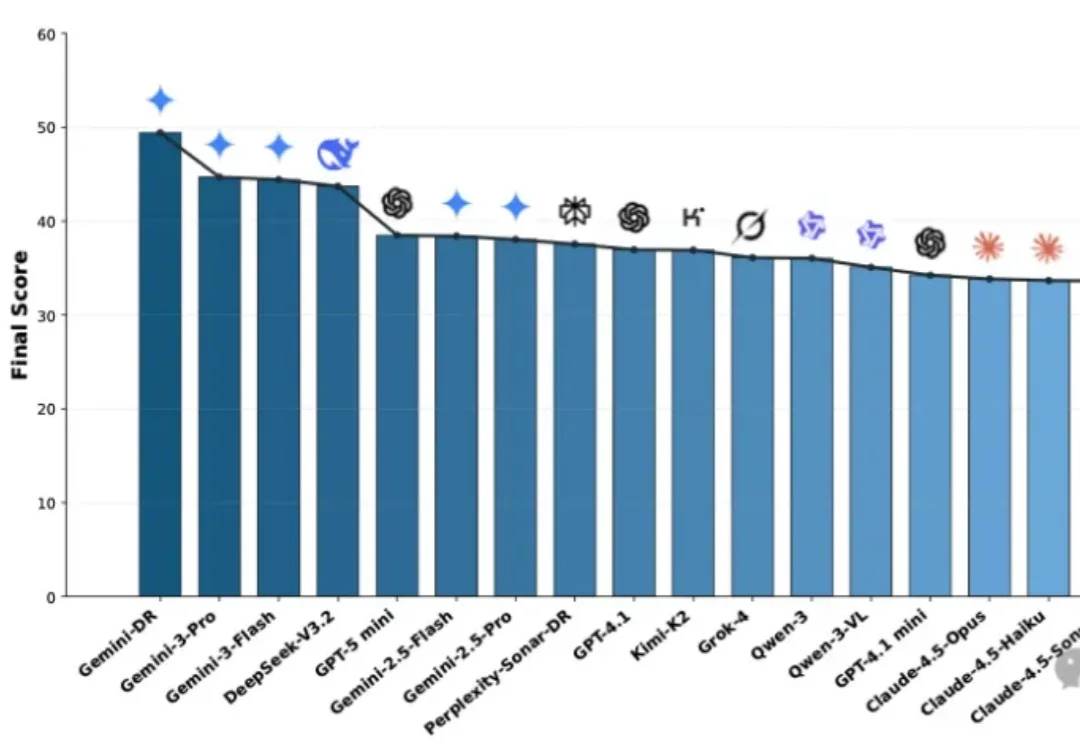

面对琳琅满目的Deep Research Agent(深度研究智能体),究竟该如何选型?本文基于OSU与Amazon最新发布的MMDR-Bench论文,为您提供一份经过严谨科学验证的“避坑指南”。结论先行:综合任务首选谷歌Gemini Deep Research,而涉及计算机科学与数据结构的硬核任务,GPT-5.2依然是专家首选。

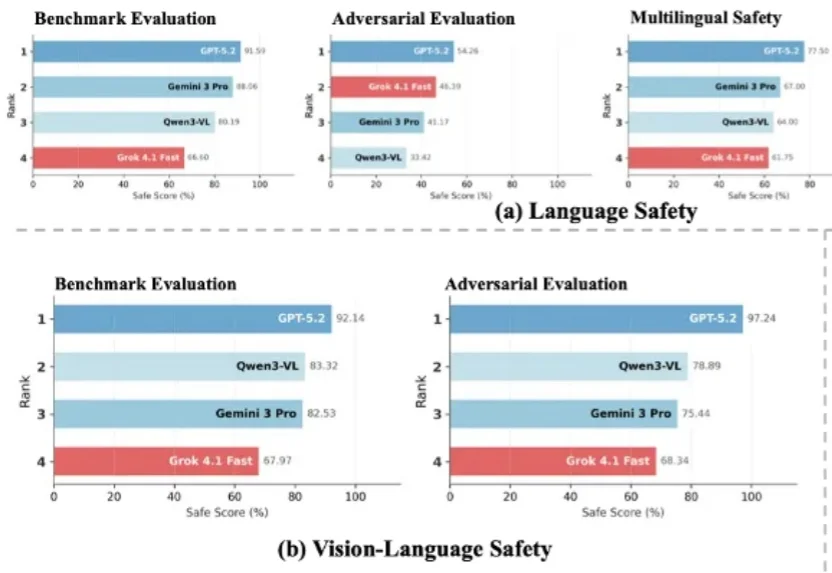

随着大语言模型加速迈向多模态与智能体形态,传统以单一维度为主的安全评估体系已难以覆盖真实世界中的复杂风险图景。在模型能力持续跃升的 2026 年,开发者与用户也愈发关注一个核心问题:前沿大模型的安全性,到底如何?

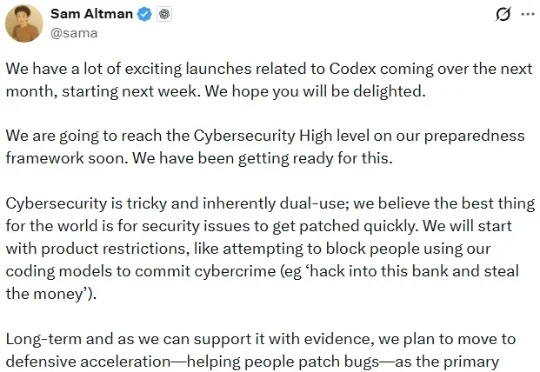

刚刚,OpenAI CEO 山姆・奥特曼发了一条推文:「从下周开始的接下来一个月,我们将会发布很多与 Codex 相关的激动人心的东西。」他尤其强调了网络安全这个主题。