斯坦福博士后创业,给机器人做“电子皮肤”|涌现新项目

斯坦福博士后创业,给机器人做“电子皮肤”|涌现新项目途见科技通过“电子皮肤”触觉系统,为具身智能增加视觉、听觉之外的感知。

途见科技通过“电子皮肤”触觉系统,为具身智能增加视觉、听觉之外的感知。

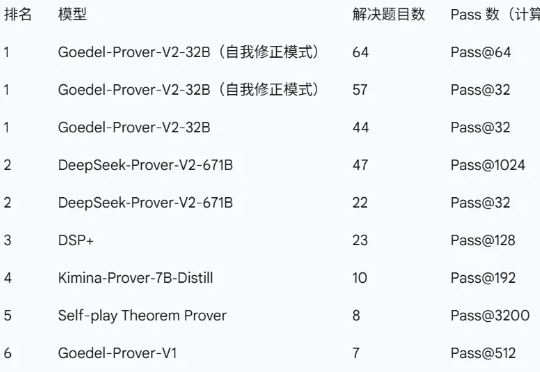

近日,由普林斯顿大学牵头,联合清华大学、北京大学、上海交通大学、斯坦福大学,以及英伟达、亚马逊、Meta FAIR 等多家顶尖机构的研究者共同推出了新一代开源数学定理证明模型——Goedel-Prover-V2。

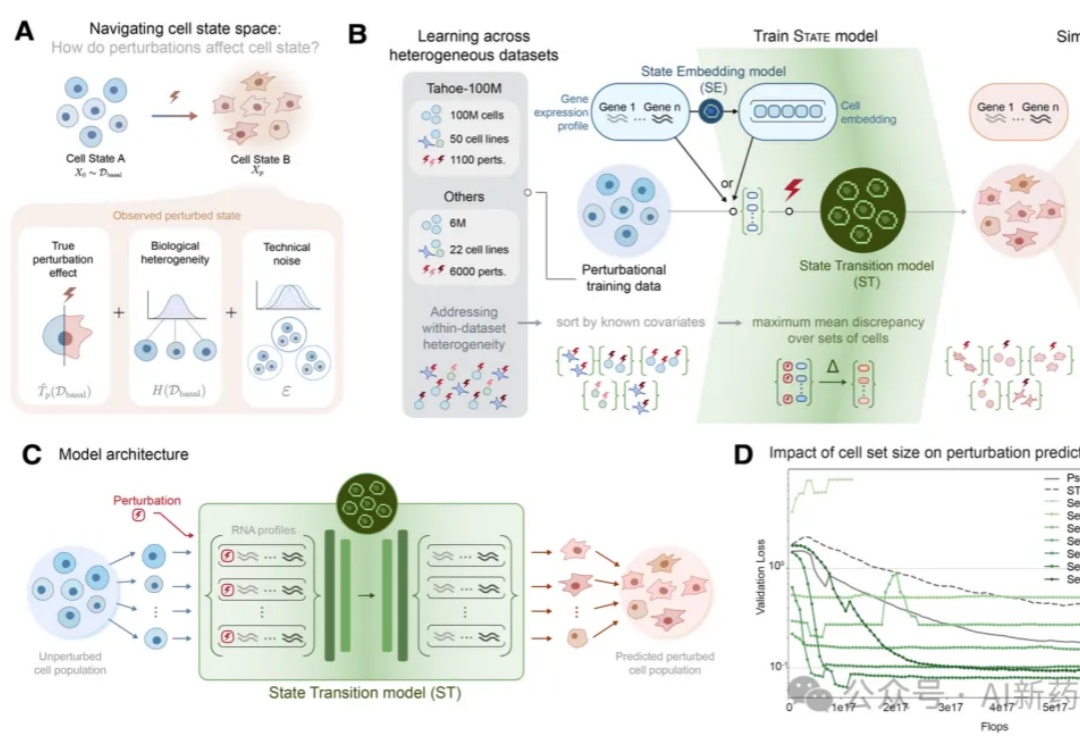

Vevo Therapeutics(现为Tahoe)与Arc研究所,两家分别在生物技术商业转化和非营利性基础研究领域领先的机构,于2025年2月联合发布了一项里程碑式的成果:全球最大的单细胞药物扰动数据集Tahoe-100M。

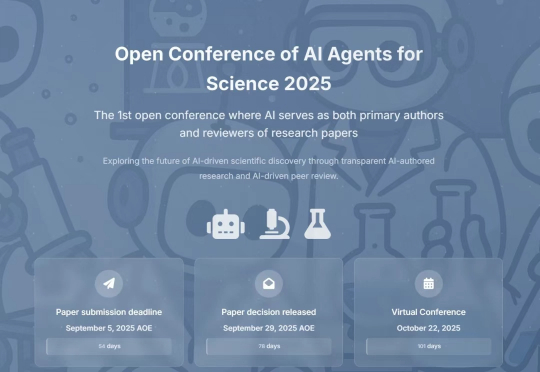

AI 终于可以当「第一作者」了。斯坦福大学近日宣布,将于 2025 年举办一个史无前例的学术会议 —— 科学 AI 智能体开放会议(Agents4Science 2025),全称 Open Conference of AI Agents for Science。 它的投稿要求堪称颠覆:第一作者必须是 AI。

MoCa框架把单向视觉语言模型转化为双向多模态嵌入模型,通过持续预训练和异构对比微调,提升模型性能和泛化能力,在多模态基准测试中表现优异,尤其小规模模型性能突出。

「哈喽,可以听到吗?」北京时间上午 10 点,大洋彼岸的 Pokee.ai 创始人朱哲清接通了我们的连线电话,此刻他正位于美国西海岸,当地时间为前一日晚上 7 点。「哈喽,可以听到吗?」北京时间上午 10 点,大洋彼岸的 Pokee.ai 创始人朱哲清接通了我们的连线电话,此刻他正位于美国西海岸,当地时间为前一日晚上 7 点。

谷歌、斯坦福等陆续推出「AI科学家」,协助人类科学家推动科研范式革新。科学家亲身试用后或震惊其洞察之深,或质疑其缺乏灵感与人性温度,AI能代替人类思考吗?

近期,他与合作者创建了名为 EVO 2 的生物学基础模型,该模型通过学习生命的基础信息层——DNA,来解释和生成跨所有生命领域的基因序列。

生物医学研究是我们进行人类健康研究、疾病治疗、药物研发以及促进临床护理进步的基石。

细胞治疗,尤其是CAR-T,被誉为“活的药物”,但其开发与生产面临着一个根本性挑战:我们难以精准控制和预测这些活细胞在人体内的最终状态和功能。同一批次生产的CAR-T细胞,有的能高效清除肿瘤,有的却迅速“耗竭”,这种功能异质性是制约疗效、导致高昂制造成本的核心瓶颈。如何通过基因编辑等手段,将细胞调整到最理想的“战斗”状态,是该领域亟待突破的圣杯。