一个模型超了DeepSeek R1、V3,参数671B,成本不到350万美元

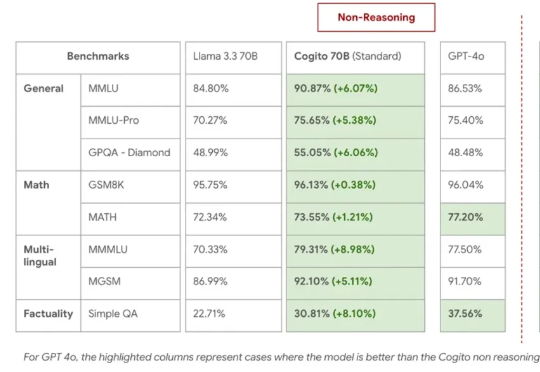

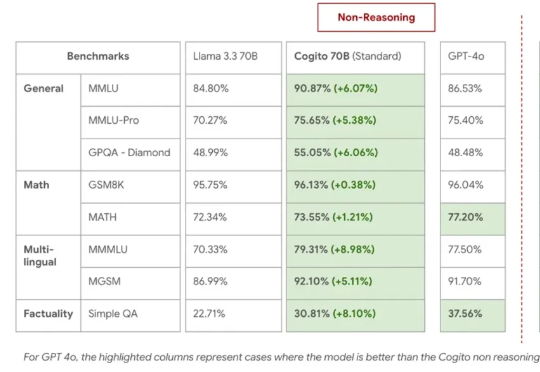

一个模型超了DeepSeek R1、V3,参数671B,成本不到350万美元Deep Cogito,一家鲜为人知的 AI 初创公司,总部位于旧金山,由前谷歌员工创立,如今开源的四款混合推理模型,受到大家广泛关注。

Deep Cogito,一家鲜为人知的 AI 初创公司,总部位于旧金山,由前谷歌员工创立,如今开源的四款混合推理模型,受到大家广泛关注。

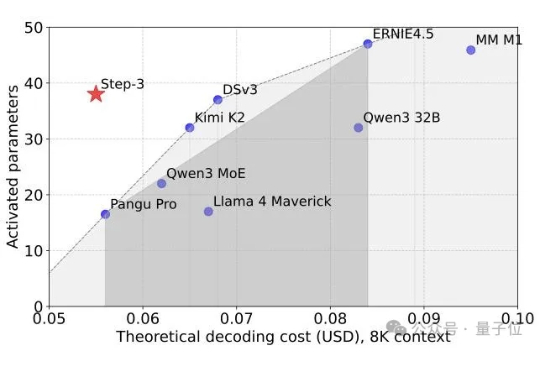

又一个SOTA基础模型开源,而且依然是国产。 刚刚,阶跃星辰兑现了WAIC上的承诺,将最新多模态推理模型Step-3正式开源! 在MMMU等多个多模态榜单上,它一现身就取得了开源多模态推理模型新SOTA的成绩。

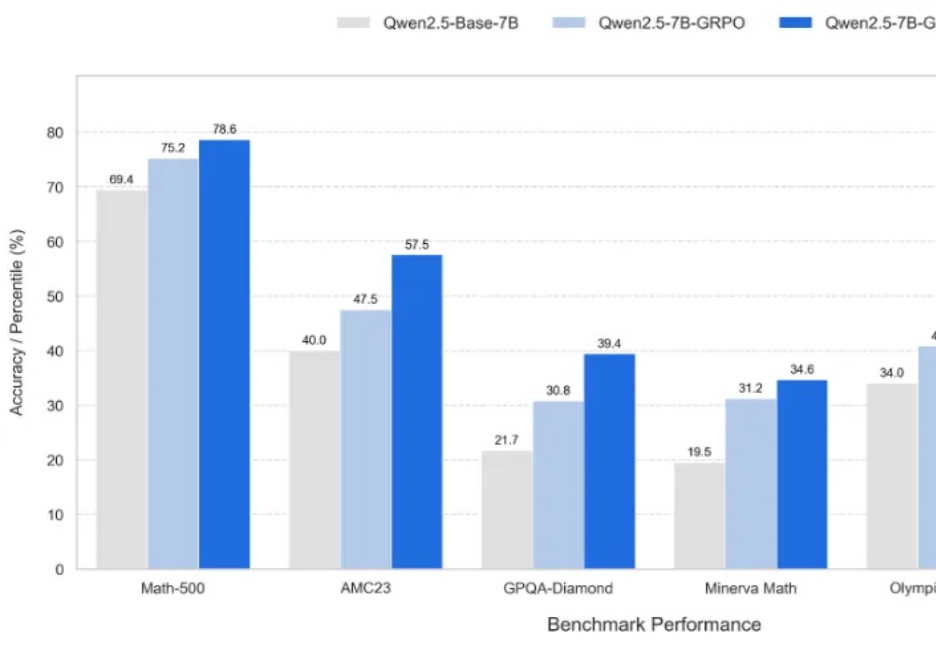

新一代大型推理模型,如 OpenAI-o3、DeepSeek-R1 和 Kimi-1.5,在复杂推理方面取得了显著进展。该方向核心是一种名为 ZERO-RL 的训练方法,即采用可验证奖励强化学习(RLVR)逐步提升大模型在强推理场景 (math, coding) 的 pass@1 能力。

就在刚刚,阿里正式发布全球最强开源推理模型——Qwen3-235B-A22B-Thinking-2507。就在刚刚,阿里正式发布全球最强开源推理模型——Qwen3-235B-A22B-Thinking-2507。

OpenAI通用推理模型在国际奥数竞赛中达到金牌水平,解出5题得分35/42。模型通过新技术实现长时间复杂推理和自然语言证明,非专用系统。标志AI在创造性思考和科学研究的重大突破,为解决千年难题铺路。GPT-5即将发布但暂缺此能力。

今日,昆仑万维重磅开源多模态推理模型Skywork-R1V 3.0,这是其迄今最强多模态推理模型,参数规模为38B,在多个多模态推理基准测试中取得了开源最佳(SOTA)性能。

Jack Clark 是最关注和熟悉中国在芯片、计算和模型上进展的 AI Lab 领导人之一。他毫不吝啬对中国 AI 进展的认可,将 DeepSeek R1 视作“推理模型大范围扩散”的起点,近期又把 HyperHetero 使用的异构集群叫做通过“超级智能进行持续自我训练”的垫脚石。

2025年上半年,AI开源领域的竞赛异常激烈,主要围绕着几个核心方向展开:首先是效率竞赛,各路玩家不再单纯追求千亿、万亿参数的“巨无霸”模型,而是更专注于通过新架构和训练方法,用更小的参数实现更强的性能。其次,多模态已成标配,纯文本模型越来越少,新发布的旗舰模型几乎都具备了处理图像、视频等多种信息的能力。

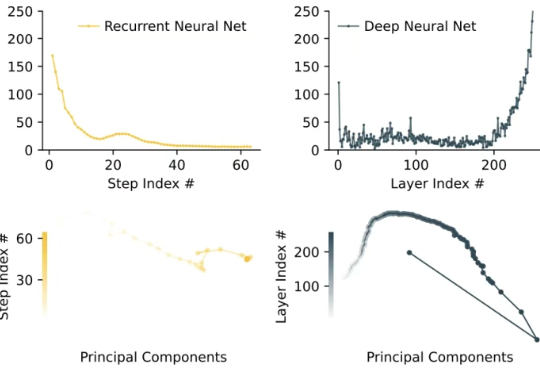

像人一样推理。 大模型的架构,到了需要变革的时候? 在对复杂任务的推理工作上,当前的大语言模型(LLM)主要采用思维链(CoT)技术,但这些技术存在任务分解复杂、数据需求大以及高延迟等问题。

6 月 27 日,腾讯混元宣布开源首个混合推理 MoE 模型 Hunyuan-A13B,总参数 80B,激活参数仅 13B,效果比肩同等架构领先开源模型,但是推理速度更快,性价比更高。模型已经在 Github 和 Huggingface 等开源社区上线,同时模型 API 也在腾讯云官网正式上线,支持快速接入部署。