OpenAI到底亏了多少钱?

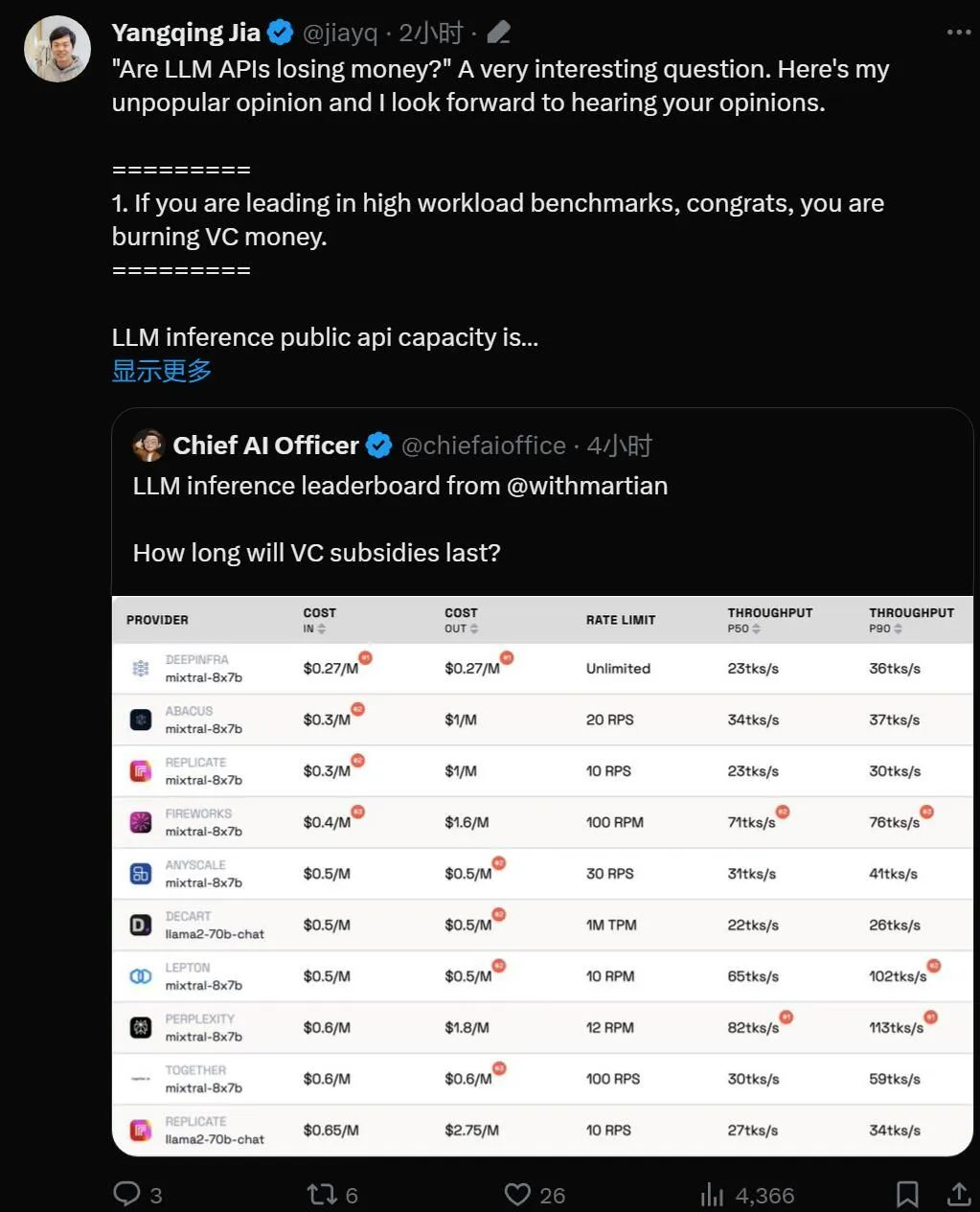

OpenAI到底亏了多少钱?The Information近日爆出了一则OpenAI的亏损新闻,其中新增的关键数据包括: OpenAI目前单月收入约为2.83mnUSD,全年营收可能在35~45亿美金。 OpenAI 24年推理成本将达到40亿美金,训练成本将达到30亿美金。

The Information近日爆出了一则OpenAI的亏损新闻,其中新增的关键数据包括: OpenAI目前单月收入约为2.83mnUSD,全年营收可能在35~45亿美金。 OpenAI 24年推理成本将达到40亿美金,训练成本将达到30亿美金。

本研究评估了先进多模态基础模型在 10 个数据集上的多样本上下文学习,揭示了持续的性能提升。批量查询显著降低了每个示例的延迟和推理成本而不牺牲性能。这些发现表明:利用大量演示示例可以快速适应新任务和新领域,而无需传统的微调。

随着深度学习大语言模型的越来越火爆,大语言模型越做越大,使得其推理成本也水涨船高。模型量化,成为一个热门的研究课题。

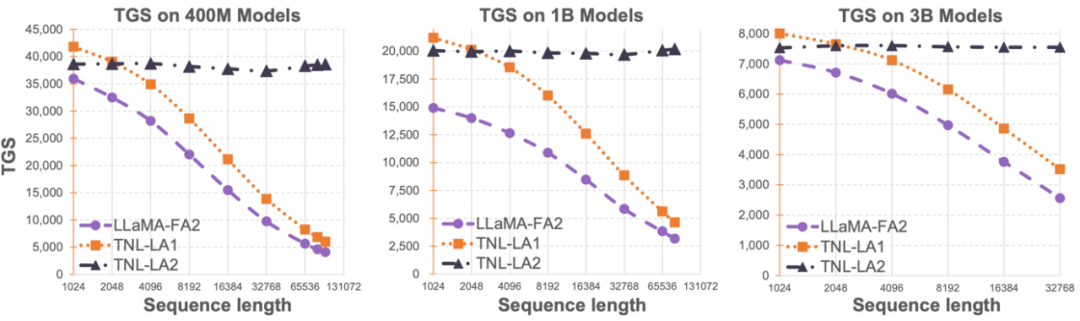

基于 Transformer 架构的大语言模型在 NLP 领域取得了令人惊艳的效果,然而,Transformer 中自注意力带来的二次复杂度使得大模型的推理成本和内存占用十分巨大,特别是在长序列的场景中。

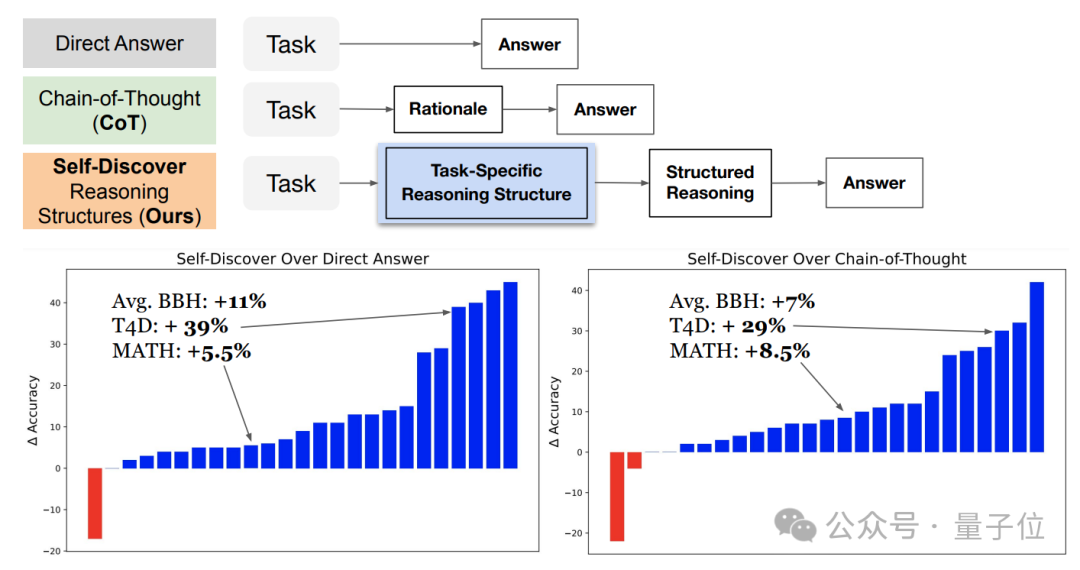

谷歌&南加大推出最新研究“自我发现”(Self-Discover),重新定义了大模型推理范式。与已成行业标准的思维链(CoT)相比,新方法不仅让模型在面对复杂任务时表现更佳,还把同等效果下的推理成本压缩至1/40。

MoE(混合专家)作为当下最顶尖、最前沿的大模型技术方向,MoE能在不增加推理成本的前提下,为大模型带来性能激增。比如,在MoE的加持之下,GPT-4带来的用户体验较之GPT-3.5有着革命性的飞升。

在 AI 赛道中,与动辄上千亿参数的模型相比,最近,小模型开始受到大家的青睐。比如法国 AI 初创公司发布的 Mistral-7B 模型,其在每个基准测试中,都优于 Llama 2 13B,并且在代码、数学和推理方面也优于 LLaMA 1 34B。

对于大型视觉语言模型(LVLM)而言,扩展模型可以有效提高模型性能。然而,扩大参数规模会显著增加训练和推理成本,因为计算中每个 token 都会激活所有模型参数。

风投烧完之后,哪些大模型创业公司会开始盈利?

Lightning Attention-2 是一种新型的线性注意力机制,让长序列的训练和推理成本与 1K 序列长度的一致。