深度|硅谷明星华裔投资人谈DeepSeek:AI模型训练和推理成本在过去18个月180倍成本降低,推动更多开源项目涌现

深度|硅谷明星华裔投资人谈DeepSeek:AI模型训练和推理成本在过去18个月180倍成本降低,推动更多开源项目涌现AI模型的训练和推理成本在过去18个月内大幅下降,达到180倍的成本降低。这一趋势推动了更多开源项目的涌现。

AI模型的训练和推理成本在过去18个月内大幅下降,达到180倍的成本降低。这一趋势推动了更多开源项目的涌现。

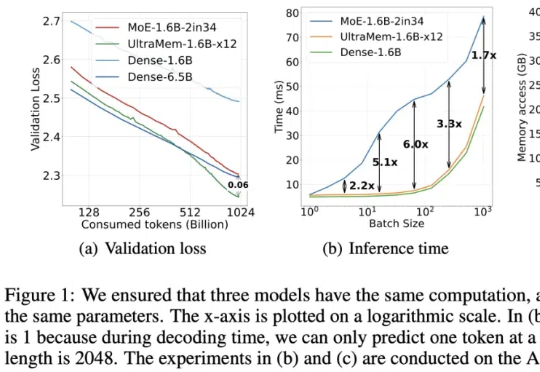

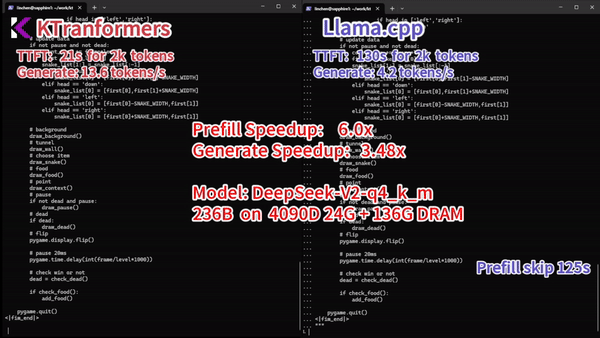

字节出了个全新架构,把推理成本给狠狠地打了下去!推理速度相比MoE架构提升2-6倍,推理成本最高可降低83%。

SANA 1.5是一种高效可扩展的线性扩散Transformer,针对文本生成图像任务进行了三项创新:高效的模型增长策略、深度剪枝和推理时扩展策略。这些创新不仅大幅降低了训练和推理成本,还在生成质量上达到了最先进的水平。

外媒SemiAnalysis的一篇深度长文,全面分析了DeepSeek背后的秘密——不是「副业」项目、实际投入的训练成本远超600万美金、150多位高校人才千万年薪,攻克MLA直接让推理成本暴降......

来了,国内首个对标AlphaFold3的产品—— HelixFold3,来自百度智能云与百度螺旋桨团队。

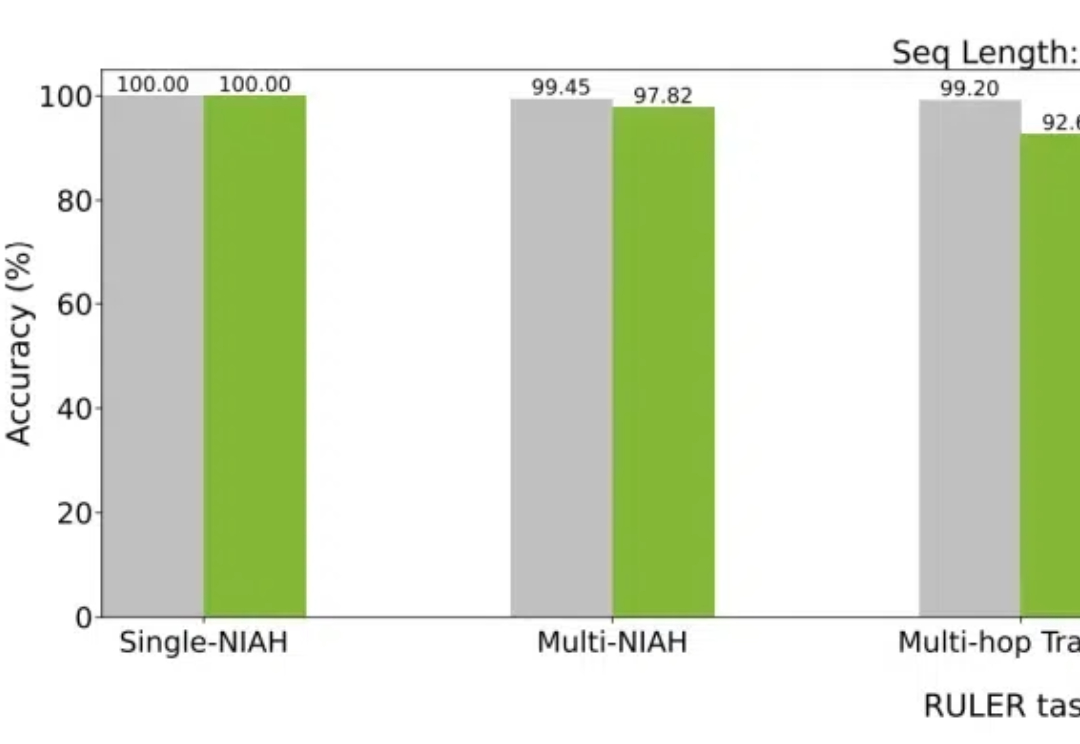

大模型如今已具有越来越长的上下文,而与之相伴的是推理成本的上升。英伟达最新提出的Star Attention,能够在不损失精度的同时,显著减少推理计算量,从而助力边缘计算。

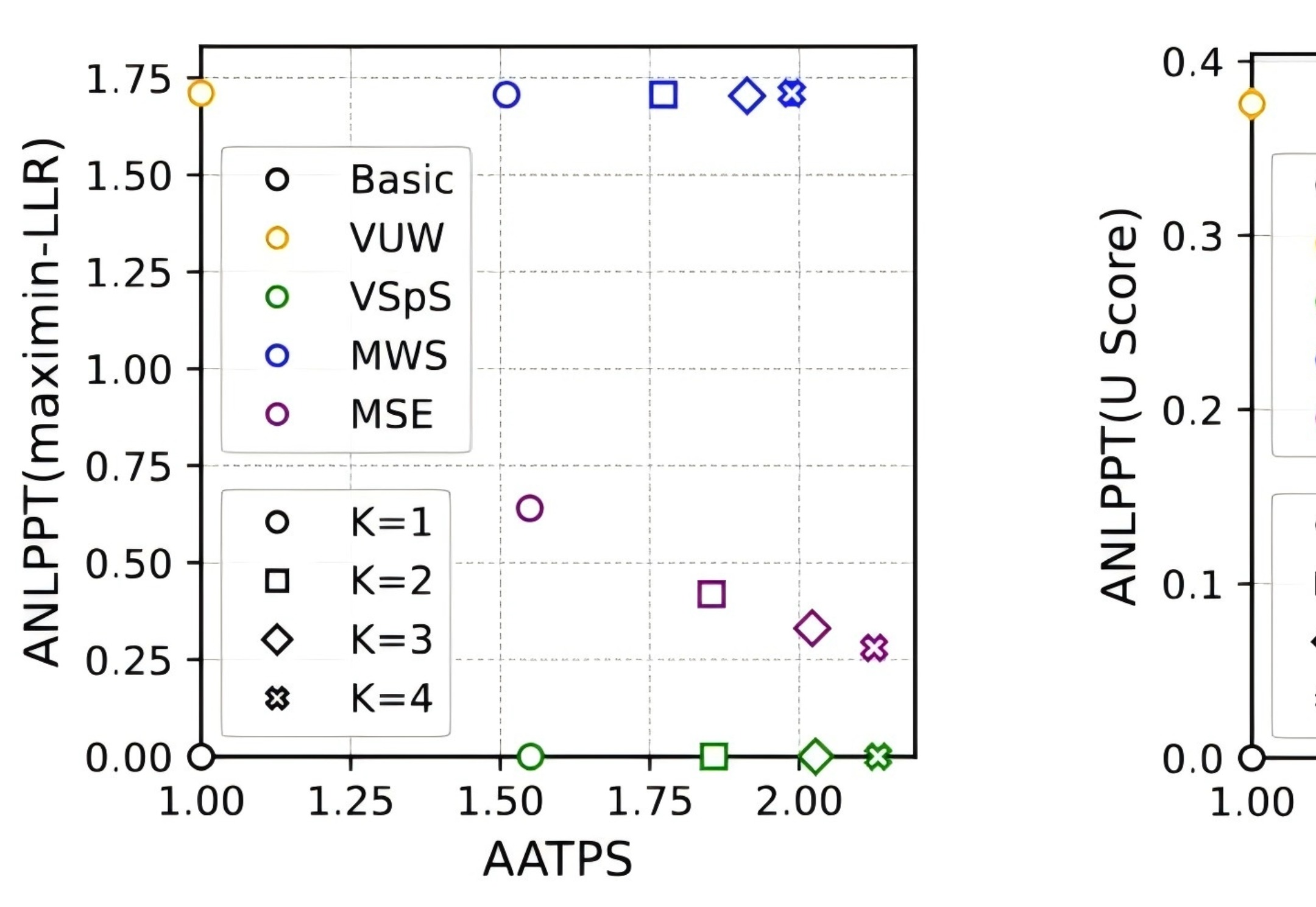

近日,DeepMind 团队将水印技术和投机采样(speculative sampling)结合,在为大语言模型加入水印的同时,提升其推理效率,降低推理成本,因此适合用于大规模生产环境。

大模型热,企业落地难?就在刚刚,百川智能推出「1+3」产品矩阵,一站式解决大模型商业化难题。「系列优质通用数据+领域增强训练工具链」,仅需10分钟就能让企业自主成为模型定制增强专家,实现行业最佳的多场景可用率。

训练代码、中间 checkpoint、训练日志和训练数据都已经开源。

2024年,落地,无疑是大模型最重要的主题。