晚点独家丨快手可灵 AI 月活突破 1200 万,盖坤:用 AI 规模化产生好内容的临界点即将到来

晚点独家丨快手可灵 AI 月活突破 1200 万,盖坤:用 AI 规模化产生好内容的临界点即将到来《晚点 LatePost》独家获悉,快手旗下视频生成大模型可灵 AI 的月活跃用户(MAU)在今年 1 月突破 1200 万。

《晚点 LatePost》独家获悉,快手旗下视频生成大模型可灵 AI 的月活跃用户(MAU)在今年 1 月突破 1200 万。

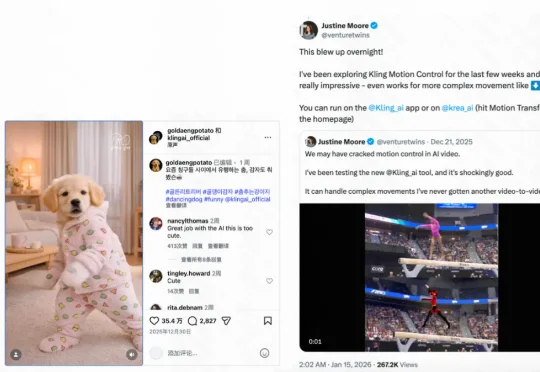

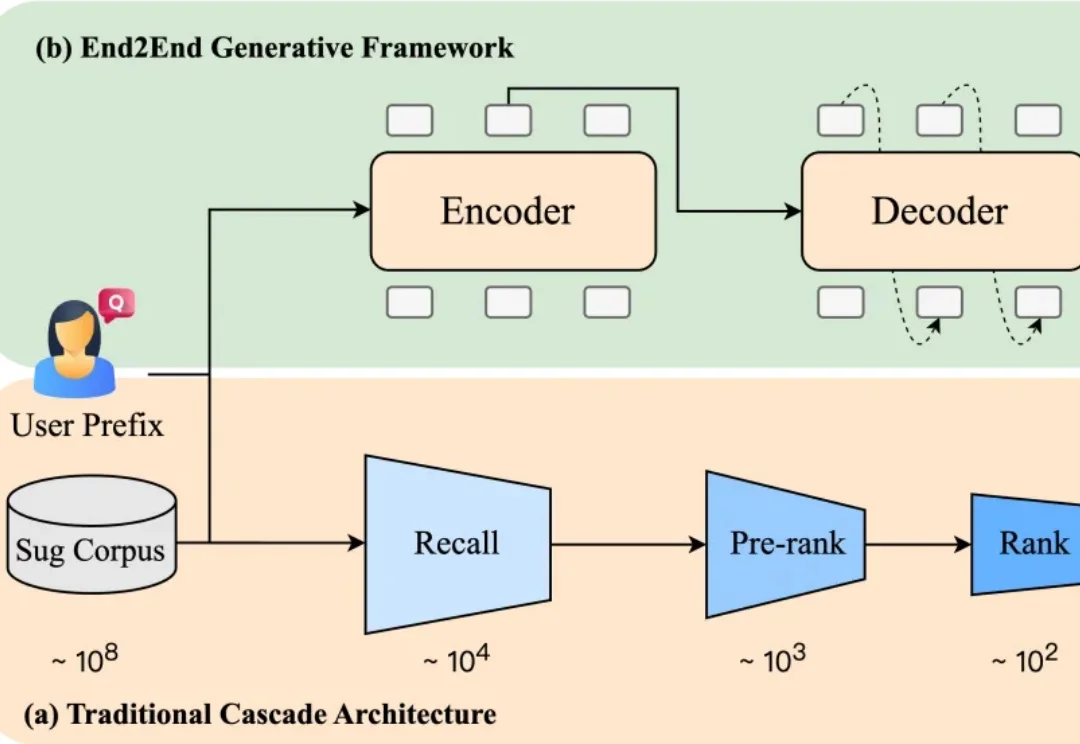

当你在电商平台搜索“苹果”,系统会推荐“水果”还是“手机”?或者直接跳到某个品牌旗舰店?短短一个词,背后承载了完全不同的购买意图。而推荐是否精准,直接影响用户的搜索体验,也影响平台的转化效率。

短视频搜索业务是向量检索在工业界最核心的应用场景之一。然而,当前业界普遍采用的「自强化」训练范式过度依赖历史点击数据,导致系统陷入信息茧房,难以召回潜在相关的新鲜内容。

快手大模型掌舵人,被曝出即将离职!今天,多个媒体爆料,快手副总裁、基础大模型及推荐模型负责人周国睿即将离职。关于周国睿下一步去向,也成了谜团:据传他将加入Meta,也有消息称,他可能会转投TikTok,具体不得而知。

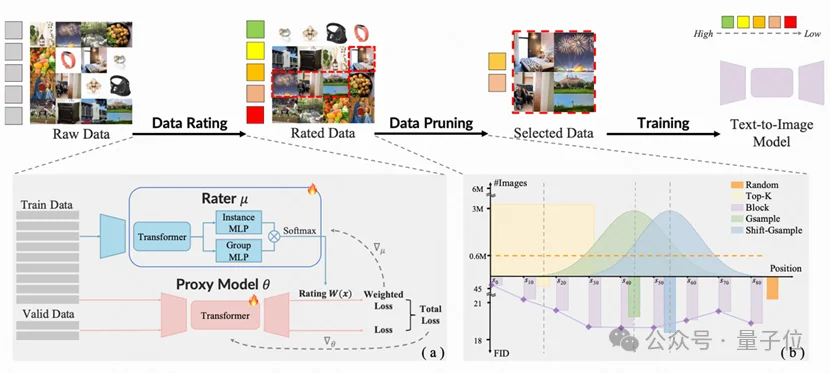

由香港大学丁凯欣领导,联合华南理工大学周洋以及快手科技Kling团队共同完成的这项研究,开发出了一个名为“炼金师”(Alchemist)的AI系统。它就像一位挑剔的大厨,能从海量图片数据中精准挑选出最有价值的一半。

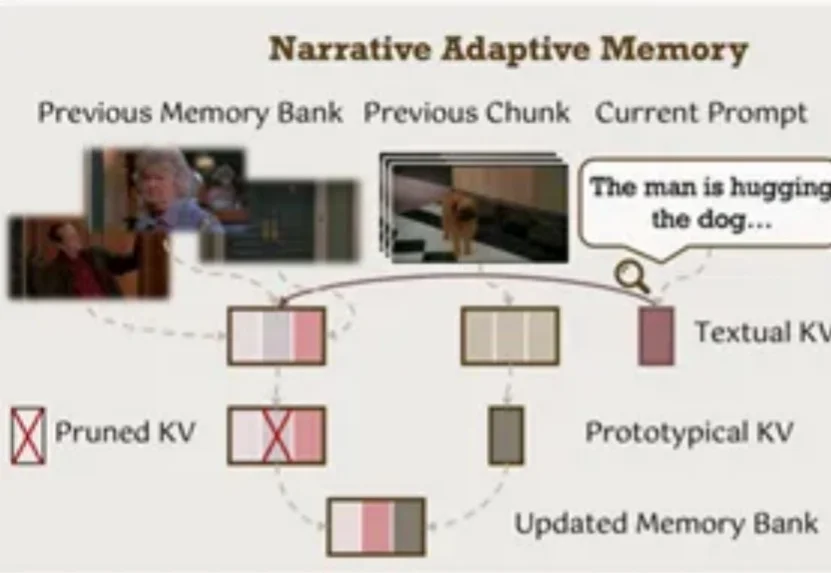

你是否曾被AI视频生成的不连贯性所困扰?

不仅能“听懂”物体的颜色纹理,还能“理解”深度图、人体姿态、运动轨迹……

ChatGPT发布三周年,OpenAI没发布,各大AI玩家倒纷纷整出大活。

智东西11月28日报道,刚刚,快手开源其新一代旗舰多模态大模型Keye-VL-671B-A37B。该模型基于DeepSeek-V3-Terminus打造,拥有6710亿个参数,在保持基础模型通用能力的前提下,对视觉感知、跨模态对齐与复杂推理链路进行了升级,实现了较强的多模态理解和复杂推理能力。

快手直播间的 AI 礼物是如何诞生的?