访谈|OpenAI/Google 一线产品人揭秘:99% AI 产品第一天就错了

访谈|OpenAI/Google 一线产品人揭秘:99% AI 产品第一天就错了在过去一年里,无论是企业还是独立开发者,都在“做 AI”。

在过去一年里,无论是企业还是独立开发者,都在“做 AI”。

发现一个很有意思的现象,模型能力已经不是瓶颈了。

故事得从我们那个行业交流群说起。

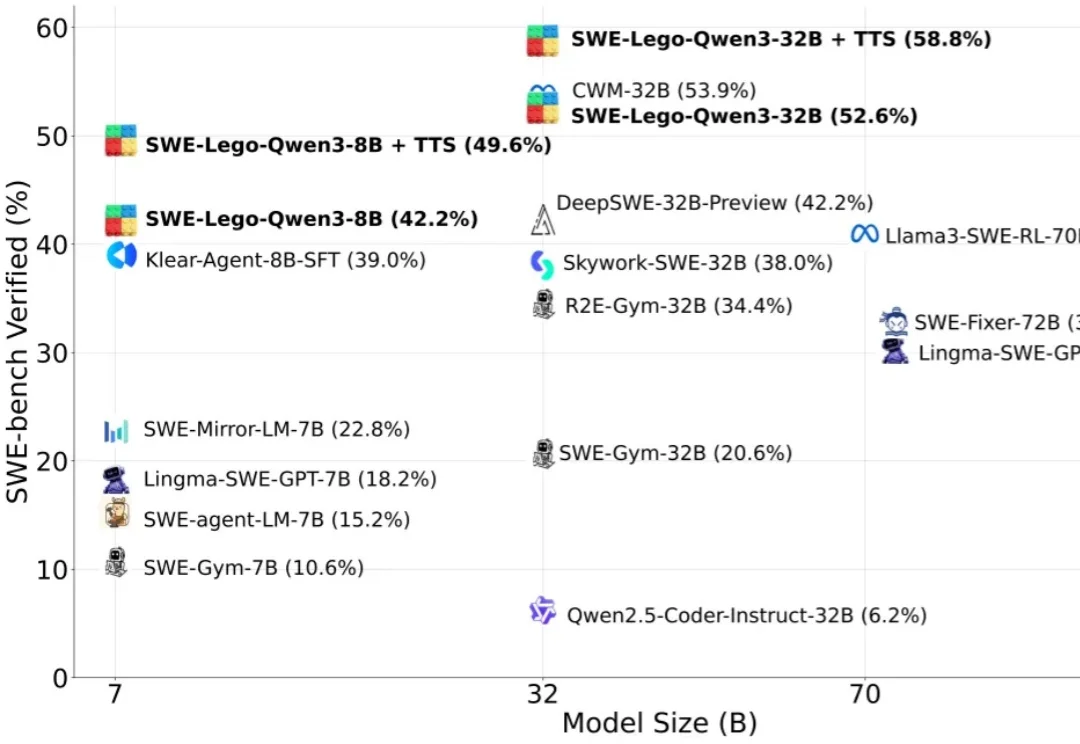

“软工任务要改多文件、多轮工具调用,模型怎么学透?高质量训练数据稀缺,又怕轨迹含噪声作弊?复杂 RL 训练成本高,中小团队望而却步?”

这正是动画制作的过程,当它第一次出现时,人们对它产生了反感。现在的 AI 发展情况与之非常相似,但技术的发展是无法阻挡的,它必然会发生。你要么成为其中的一部分,要么被时代淘汰。

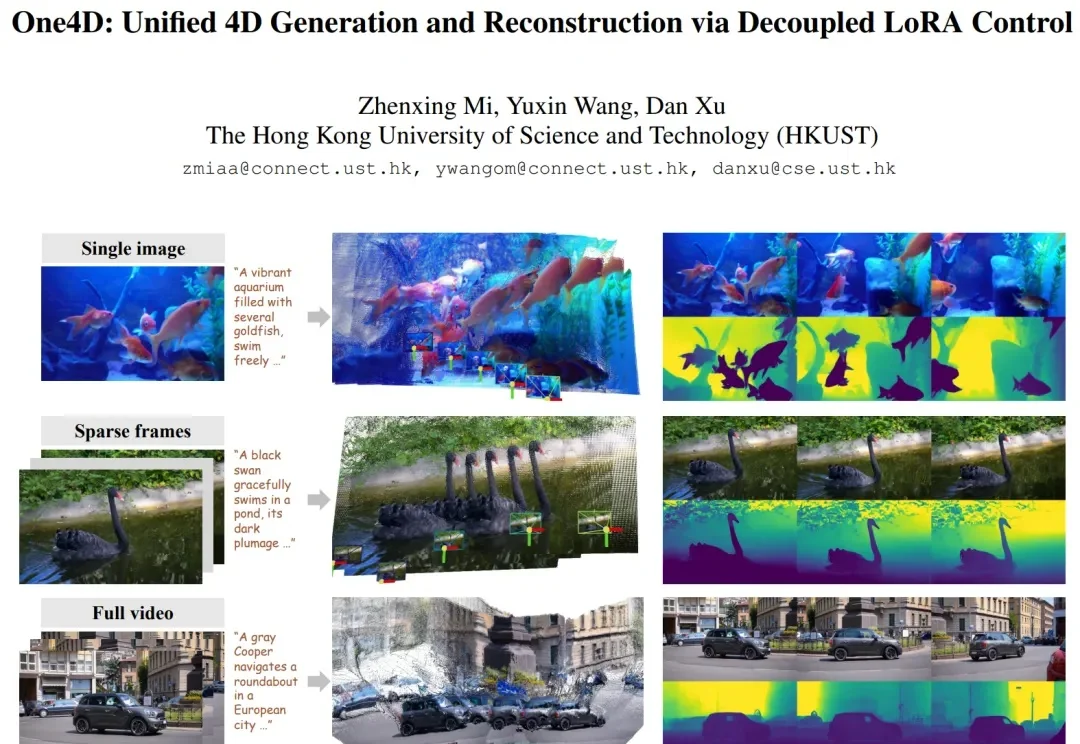

近年来,视频扩散模型在 “真实感、动态性、可控性” 上进展飞快,但它们大多仍停留在纯 RGB 空间。模型能生成好看的视频,却缺少对三维几何的显式建模。这让许多世界模型(world model)导向的应用(空间推理、具身智能、机器人、自动驾驶仿真等)难以落地,因为这些任务不仅需要像素,还需要完整地模拟 4D 世界。

现在,我们越来越多地将大语言模型应用于搜索、编程、内容生成和决策辅助等现实场景中。尽管每天有数百万人使用大模型,但它的问题也随之而来,例如有时会产生幻觉,甚至在特定情境下表现出误导或欺骗用户的倾向。

当代花钱上班的形式有很多:买咖啡提神、怕迟到打专车、下午来两杯奶茶、还有买各种会员和订阅服务。

爆火神经网络架构KAN一作,毕业新去向已获清华官网认证: 刘子鸣,拟于今年9月加入清华大学人工智能学院,任助理教授。

作为全球最具影响力的科技智库之一,《麻省理工科技评论》始终致力于追踪科技创新的最前沿,在纷繁复杂的技术浪潮中识别那些真正具有改变世界的新兴技术方向。自 2001 年起,我们开始发布“十大突破性技术”(10 Breakthrough Technologies),旨在挖掘尚处早期、却有望深刻影响未来的创新。