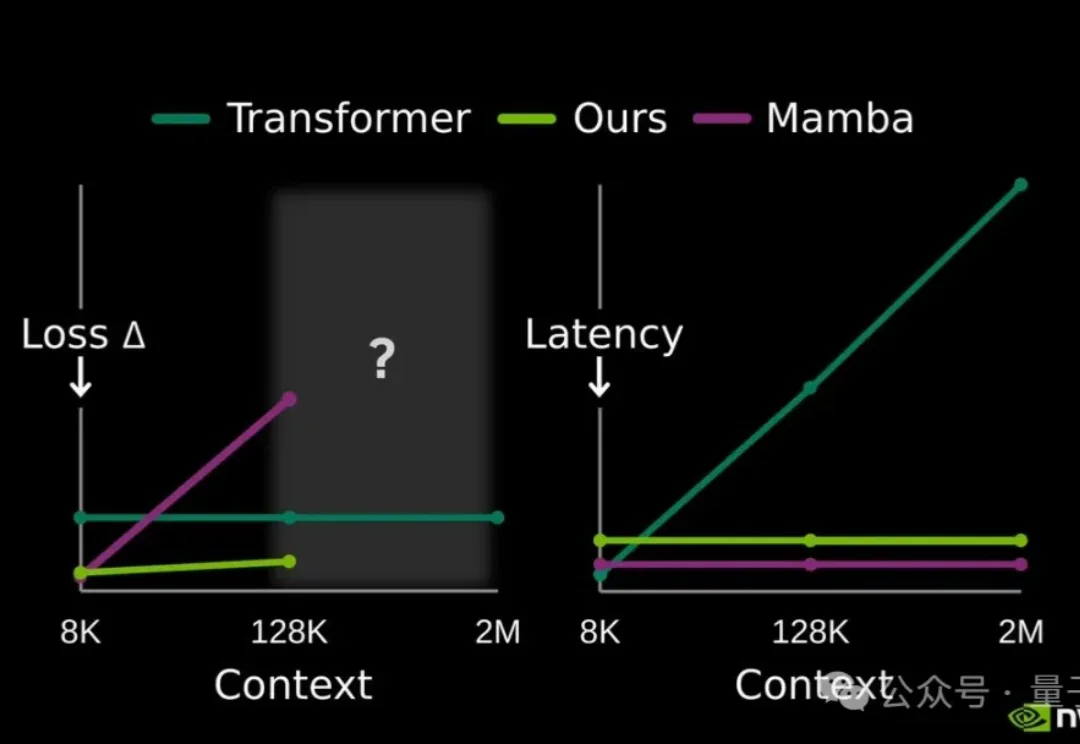

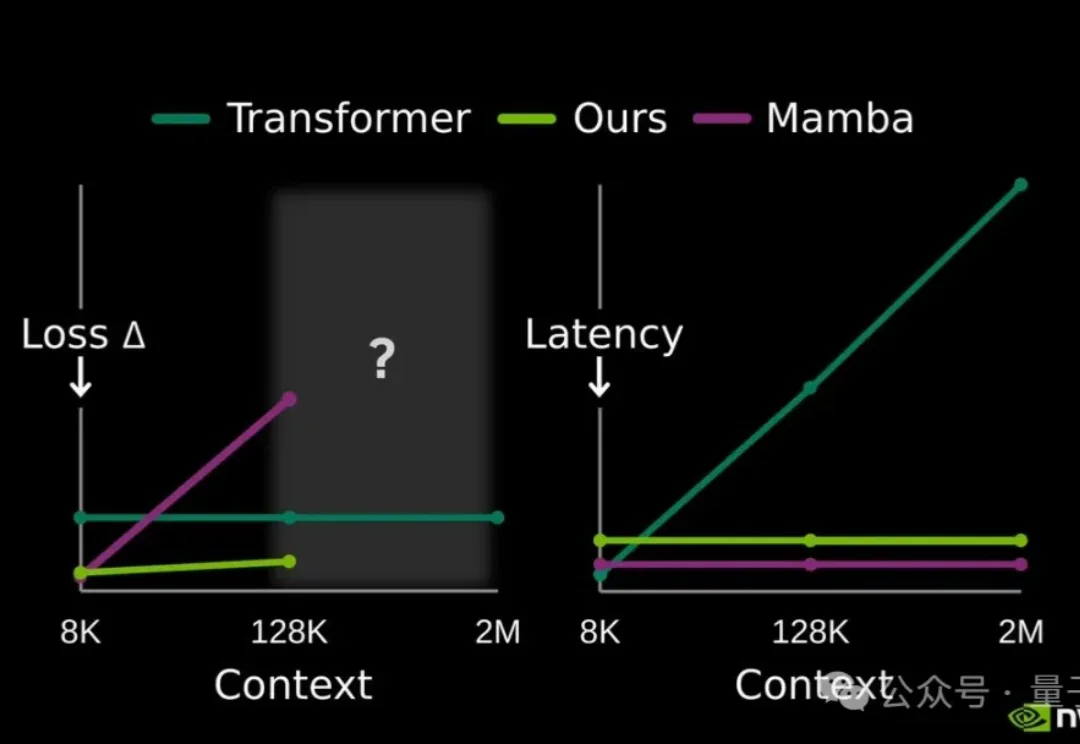

不用额外缓存!英伟达开源大模型记忆压缩方案,128K上下文提速2.7倍

不用额外缓存!英伟达开源大模型记忆压缩方案,128K上下文提速2.7倍提高大模型记忆这块儿,美国大模型开源王者——英伟达也出招了。

提高大模型记忆这块儿,美国大模型开源王者——英伟达也出招了。

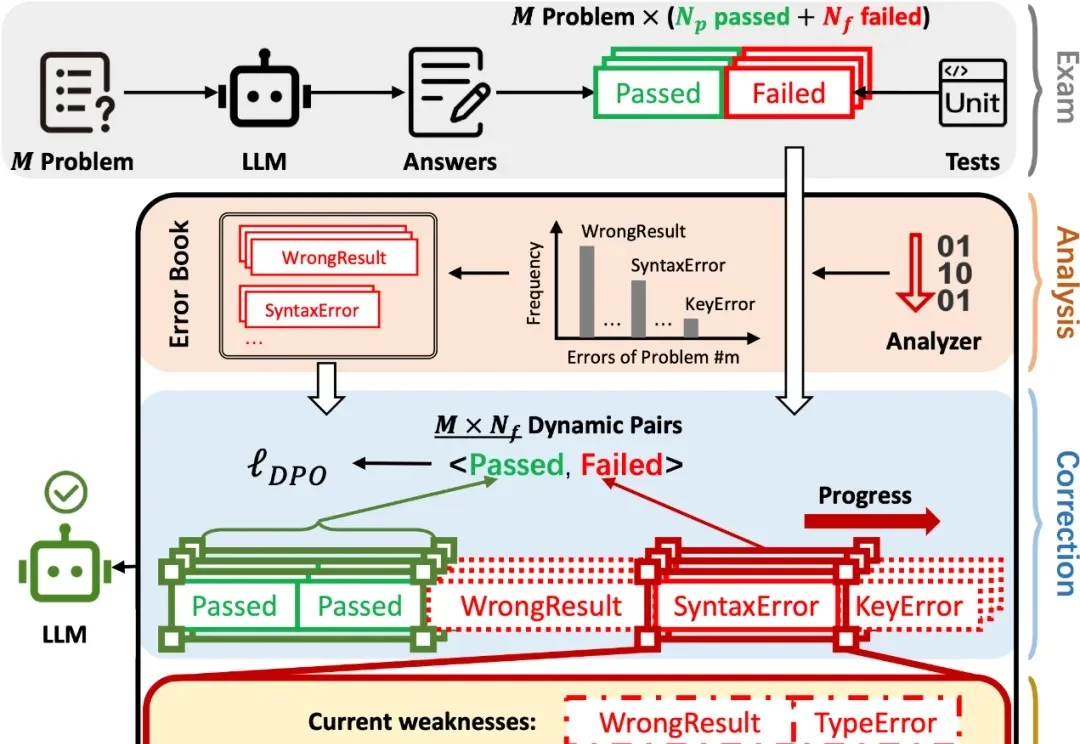

在 AI 辅助 Coding 技术快速发展的背景下,大语言模型(LLMs)虽显著提升了软件开发效率,但开源的 LLMs 生成的代码依旧存在运行时错误,增加了开发者调试成本。

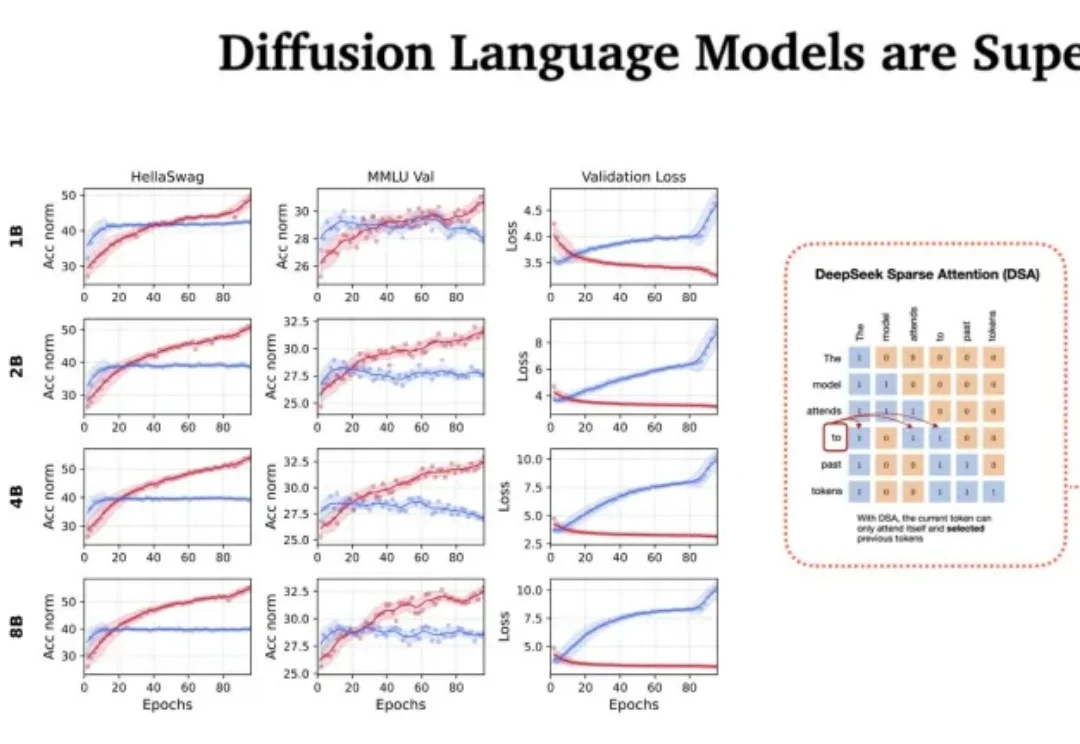

站在 2026 年的开端回望,LLM 的架构之争似乎进入了一个新的微妙阶段。过去几年,Transformer 架构以绝对的统治力横扫了人工智能领域,但随着算力成本的博弈和对推理效率的极致追求,挑战者们从未停止过脚步。

无论你是否身处AI行业,近期总能频繁刷到关于中国AI新物种的新闻。在美国拉斯维加斯会展中心举办的CES大会上,来自中国的AI产品遍布各个展馆,成为全场关注的焦点,这也恰如其分地印证了2025年中国AI应用落地的蓬勃发展态势。

干爆整个韩服 LOL,让中韩两国网友误以为是 AI 的乌龙事件。

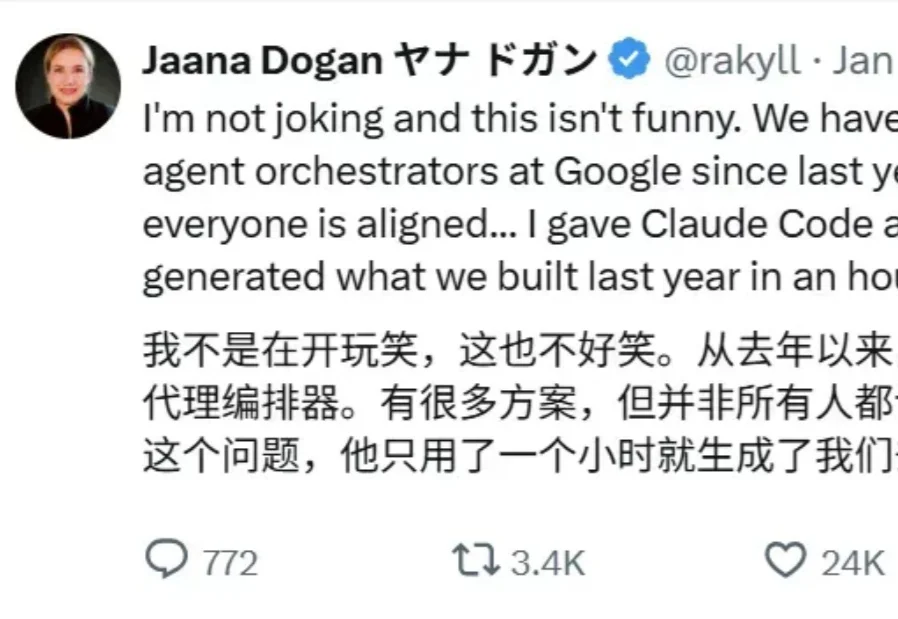

自从开年谷歌首席工程师 Jaana Dogan 公开称赞 Claude Code 后,它就又火了一把。

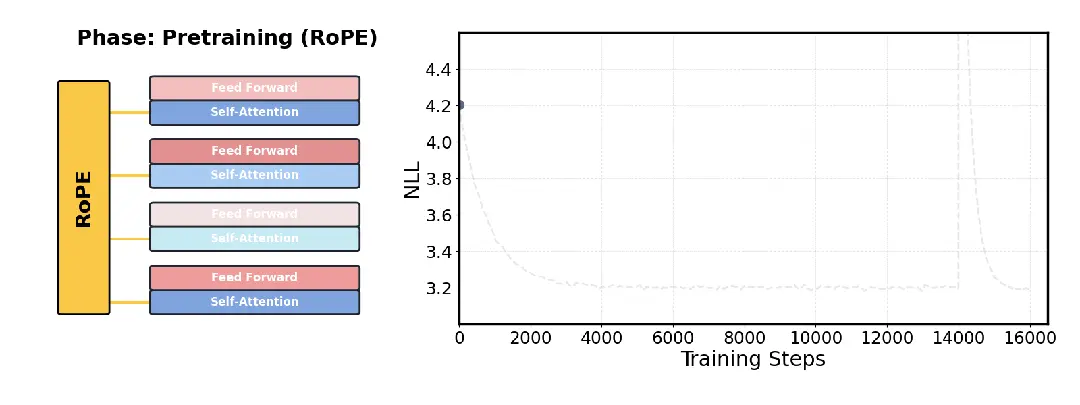

针对大模型长文本处理难题,Transformer架构的核心作者之一Llion Jones领导的研究团队开源了一项新技术DroPE。

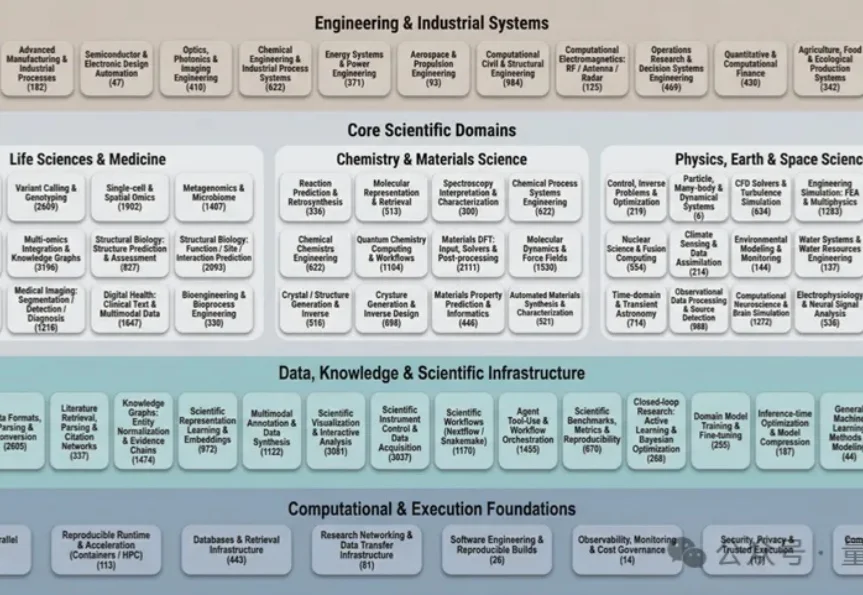

过去几十年里,科学计算领域积累了数量空前的开源软件工具。

在过去一年里,无论是企业还是独立开发者,都在“做 AI”。

发现一个很有意思的现象,模型能力已经不是瓶颈了。