国产医疗大模型登顶权威榜单!核心秘籍:PB级训练数据、模拟医生真实会诊过程

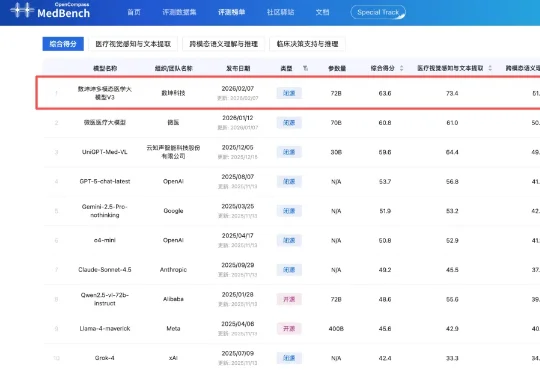

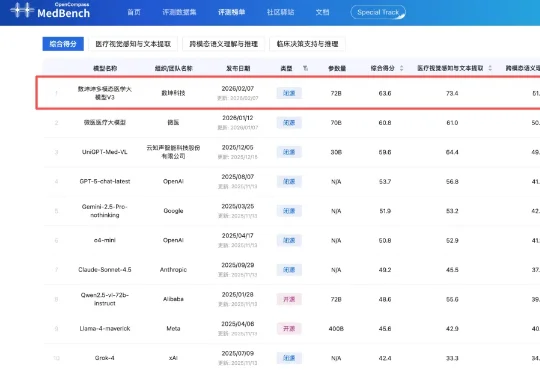

国产医疗大模型登顶权威榜单!核心秘籍:PB级训练数据、模拟医生真实会诊过程2月7日,中文医疗大模型评测平台MedBench公布最新多模态大模型评测榜单,数坤科技的数坤坤多模态医学大模型V3以63.6分拿下第一。在榜单中,V3的表现超过微医、云知声旗下医疗行业大模型,以及OpenAI、谷歌、阿里千问旗下通用大模型。

2月7日,中文医疗大模型评测平台MedBench公布最新多模态大模型评测榜单,数坤科技的数坤坤多模态医学大模型V3以63.6分拿下第一。在榜单中,V3的表现超过微医、云知声旗下医疗行业大模型,以及OpenAI、谷歌、阿里千问旗下通用大模型。

这个国产开源模型,把多模态玩出了“魔法”感。

梦瑶 发自 凹非寺 量子位 | 公众号 QbitAI 不是,谁也没跟我说今年的AI春节大战搞得这么猛猛猛啊!?! 年还没到呢,可灵就超绝不经意甩出一个「过大年计划」:推出可灵3.0多模态全家桶。 让每

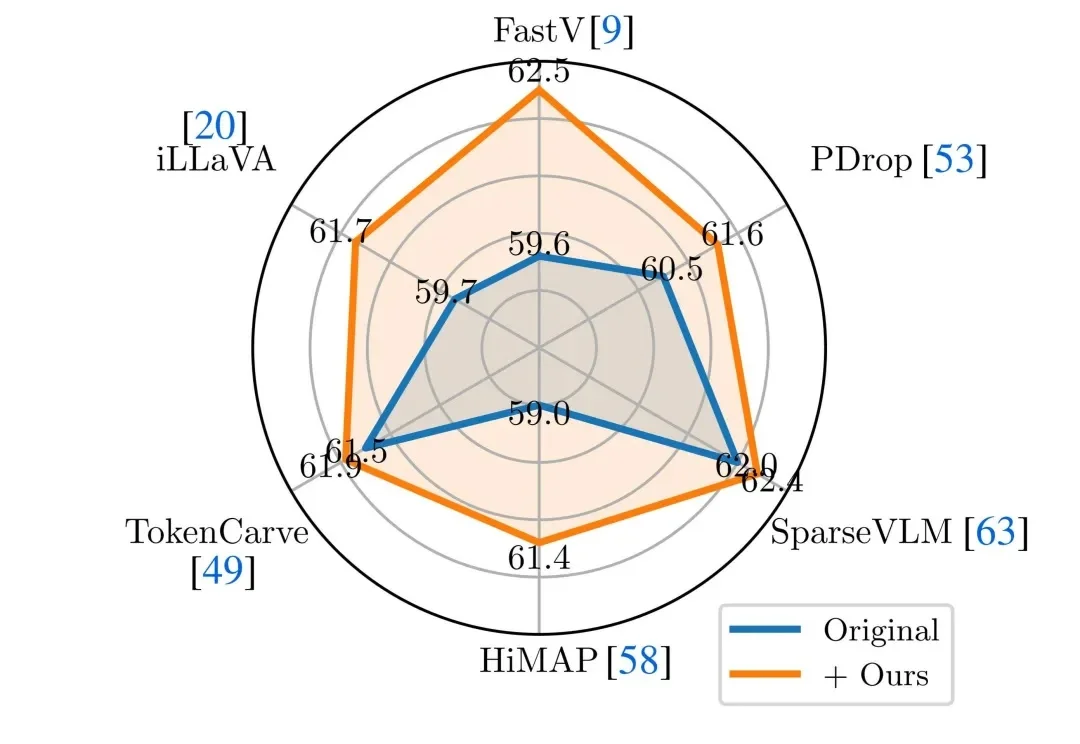

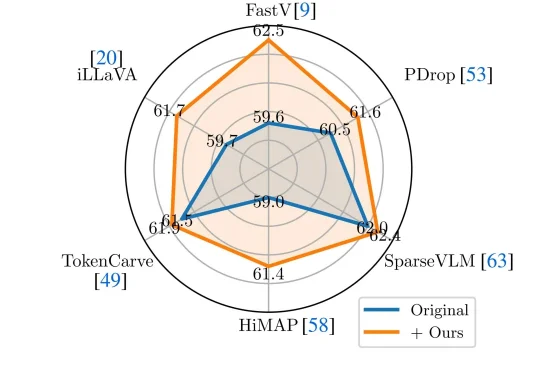

近年来,Vision-Language Models(视觉 — 语言模型)在多模态理解任务中取得了显著进展,并逐渐成为通用人工智能的重要技术路线。然而,这类模型在实际应用中往往面临推理开销大、效率受限的问题,研究者通常依赖 visual token pruning 等策略降低计算成本,其中 attention 机制被广泛视为衡量视觉信息重要性的关键依据。

今天,北京多模态生成技术创企生数科技宣布完成超过6亿元人民币A+轮融资。生数科技还披露,2025年该公司实现用户和收入超10倍增长,用户和业务覆盖全球200多个国家和地区。

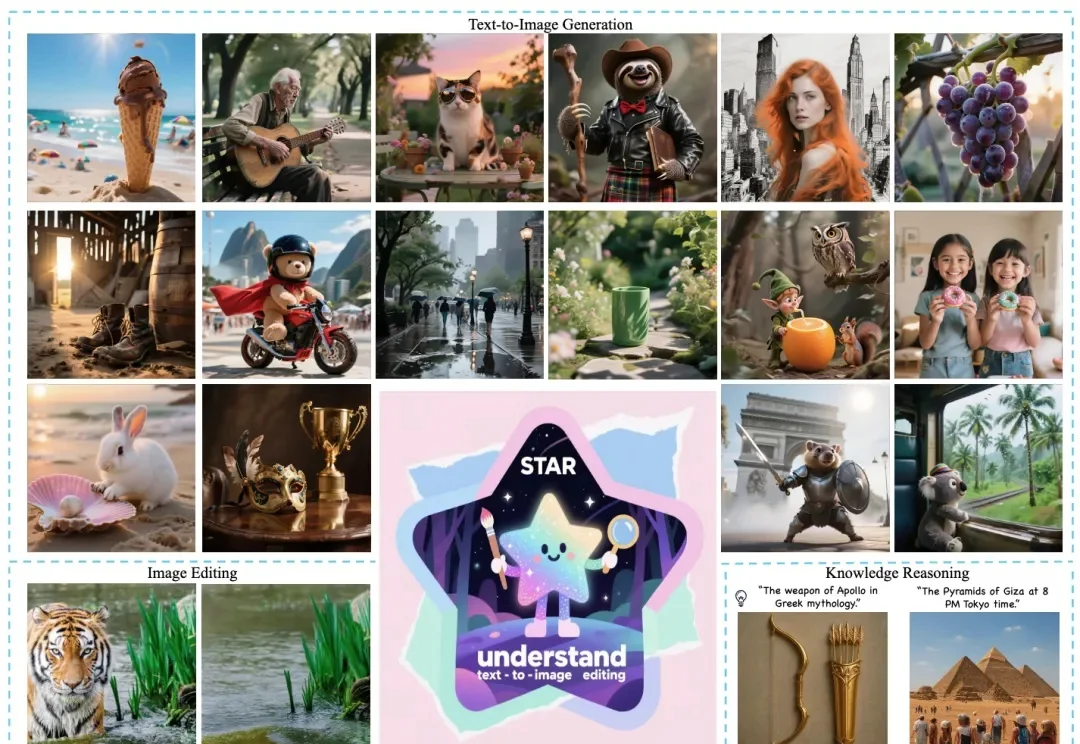

近日,美团推出全新多模态统一大模型方案 STAR(STacked AutoRegressive Scheme for Unified Multimodal Learning),凭借创新的 "堆叠自回归架构 + 任务递进训练" 双核心设计,实现了 "理解能力不打折、生成能力达顶尖" 的双重突破。

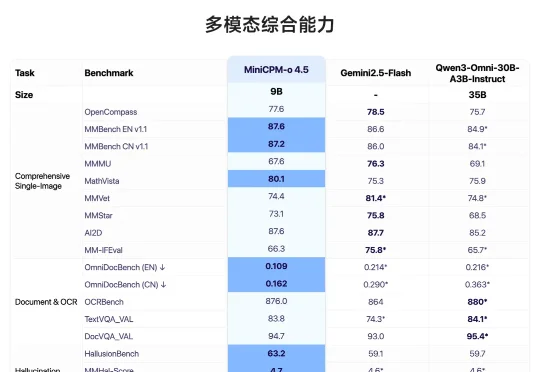

面壁开源了行业首个全双工全模态大模型 MiniCPM-o 4.5,相比已有多模态模型,MiniCPM-o 4.5 首次实现了「边看边听边说」以及「自主交互」的全模态能力,模型不再只是把视觉、语音作为静态输入处理,而是能够在实时、多模态信息流中持续感知环境变化,并在输出的同时保持对外界的理解。

「暗涌Waves」独家获悉,一家成立刚不过4个月的AI-Native用户研究平台Trooly.AI已完成近千万美元的种子轮融资,投资方包括蓝驰创投、高瓴创投和王慧文。与市面上无数“超级个体”、“虚拟陪伴”、“碳基硅基共生世界”的宏大叙事不同,Trooly.AI想要用AI实现真实的商业闭环。其核心产品面向有用户调研需求的B端客户,通过多模态Voice Agent技术

近年来,Vision-Language Models(视觉—语言模型)在多模态理解任务中取得了显著进展,并逐渐成为通用人工智能的重要技术路线。

继OpenAI大神姚顺雨之后,腾讯AI再添猛将!95后清华「天骄」庞天宇,正式入职腾讯,出任混元首席研究科学家,负责多模态强化学习。腾讯的大模型「梦之队」版图,正在极速扩张。