自主深度研究DR代理究竟走向何方?四步操作「流程」让你不迷糊 |华为最新

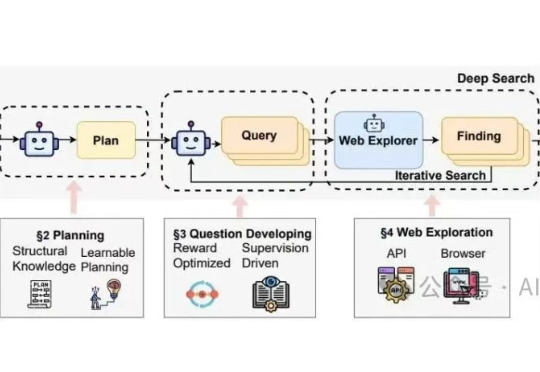

自主深度研究DR代理究竟走向何方?四步操作「流程」让你不迷糊 |华为最新华为诺亚方舟实验室最近联合香港大学发了一篇针对"Deep Research Agents"(深度研究代理)的系统性综述,在我的印象中,这是他们第二次发布关于Deep Research的综述论文。上一篇里提供了一个结构导向 (Structure-Oriented) 的视角,核心是“分类”。

华为诺亚方舟实验室最近联合香港大学发了一篇针对"Deep Research Agents"(深度研究代理)的系统性综述,在我的印象中,这是他们第二次发布关于Deep Research的综述论文。上一篇里提供了一个结构导向 (Structure-Oriented) 的视角,核心是“分类”。

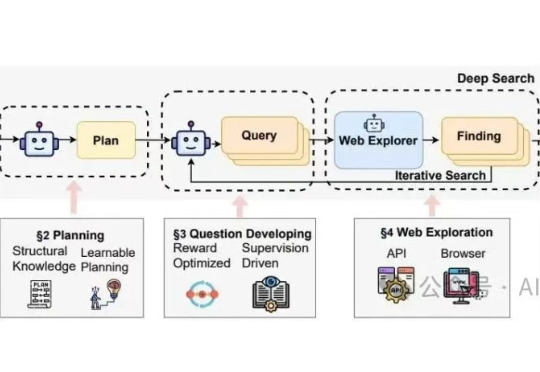

英伟达封王,谷歌、亚马逊、华为“稳赚不赔”,AMD意外亏损。AI推理,是一门利润惊人的生意。

具身智能,成了这个夏天最炙手可热的创业赛道。 量子位独家获悉,华为诺亚方舟实验室首席研究员,刚刚创办了一家具身智能公司。

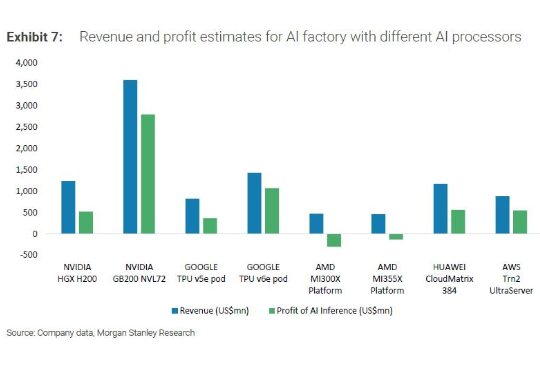

近期,基于大语言模型的智能体(LLM-based agent)在学术界和工业界中引起了广泛关注。对于智能体而言,记忆(Memory)是其中的重要能力,承担了记录过往信息和外部知识的功能,对于提高智能体的个性化等能力至关重要。

华为版本CUDA,全面开源开放! 最新消息,华为宣布为其昇腾AI GPU开源其CANN软件工具包。

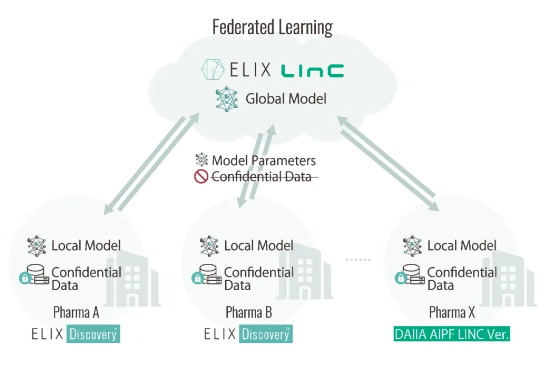

近日,日本AI制药公司Elix与AI生命科学合作组织Life Intelligence Consortium(简称“LINC”)宣布,在全球首次实现了 AI 药物发现平台的商业化。

英伟达CEO黄仁勋再访北京,盛赞华为是「非常优秀」的竞争对手,并认为「DeepSeek、Qwen、Kimi都很优秀」。

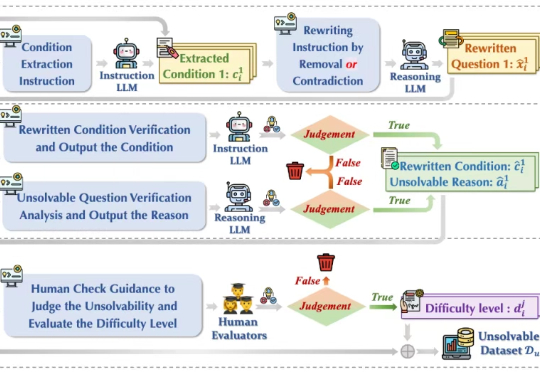

今年初以 DeepSeek-r1 为代表的大模型在推理任务上展现强大的性能,引起广泛的热度。然而在面对一些无法回答或本身无解的问题时,这些模型竟试图去虚构不存在的信息去推理解答,生成了大量的事实错误、无意义思考过程和虚构答案,也被称为模型「幻觉」 问题,如下图(a)所示,造成严重资源浪费且会误导用户,严重损害了模型的可靠性(Reliability)。

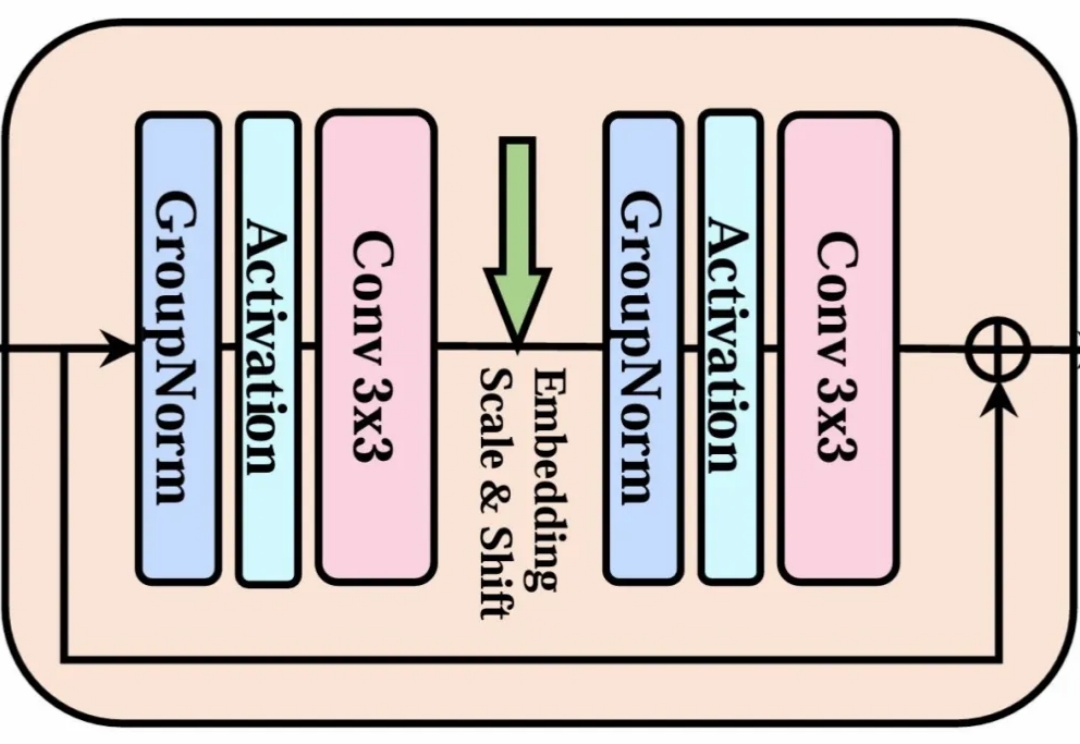

当整个 AI 视觉生成领域都在 Transformer 架构上「卷生卷死」时,一项来自北大、北邮和华为的最新研究却反其道而行之,重新审视了深度学习中最基础、最经典的模块——3x3 卷积。

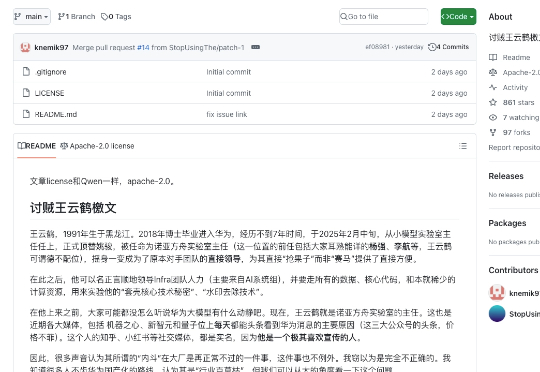

我们先给不知道剧情的朋友回归一下事件事件线:2025年6月30日,华为宣布开源盘古7B稠密和72B混合专家模型。然而发布会后,网络上出现华为盘古大模型抄袭的言论。7月5日,诺亚方舟实验室发布《关于盘古大模型开源代码相关讨论的声明》。本以为官方已经出来站台,这件事到此为止。