童年的滚球兽「走进」现实?华为天才少年创业,Xmax AI推出全球首个虚实融合的实时交互视频模型 X1

童年的滚球兽「走进」现实?华为天才少年创业,Xmax AI推出全球首个虚实融合的实时交互视频模型 X1初创公司 Xmax AI 推出的首个虚实融合的实时交互视频模型 X1,没有复杂的 Prompt,不需要漫长的渲染等待,只需要手势进行交互,就可以让虚拟世界与现实相连,在镜头中令「幻想」成真,让用户体验到实时交互的心流体验。

初创公司 Xmax AI 推出的首个虚实融合的实时交互视频模型 X1,没有复杂的 Prompt,不需要漫长的渲染等待,只需要手势进行交互,就可以让虚拟世界与现实相连,在镜头中令「幻想」成真,让用户体验到实时交互的心流体验。

今天,首个在国产芯片上完成全程训练的SOTA(最佳水平)多模态模型开源。这是智谱联合华为开源的图像生成模型GLM-Image。从数据到训练的全流程,该模型完全基于昇腾Atlas 800T A2设备和昇思MindSpore AI框架完成构建。

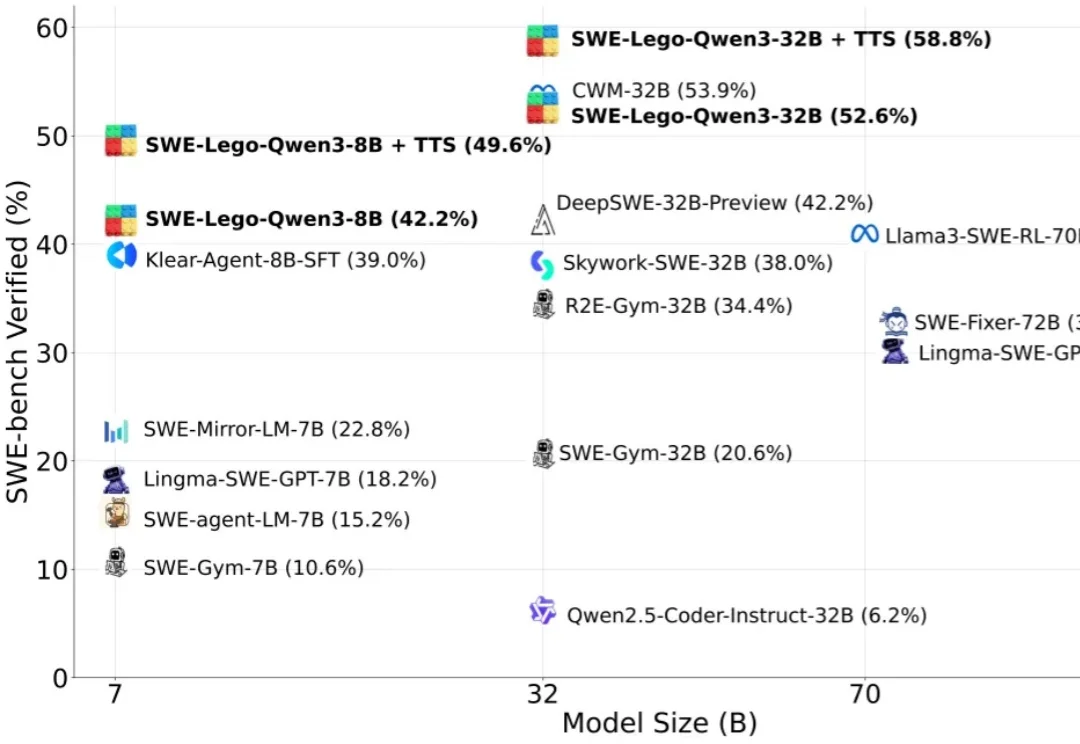

“软工任务要改多文件、多轮工具调用,模型怎么学透?高质量训练数据稀缺,又怕轨迹含噪声作弊?复杂 RL 训练成本高,中小团队望而却步?”

今天我们就借着科技领域的东风,花1分钟时间来了解一下MiniMax的创始人闫俊杰的个人履历和创业故事:1989年,闫俊杰出生于河南某县城。闫俊杰的爸爸是一名初中老师,妈妈是一名公务员,尽管闫俊杰说小时候县城的教育资源相对匮乏,但他父母都有稳定的工作,想必他的童年也比较幸福。

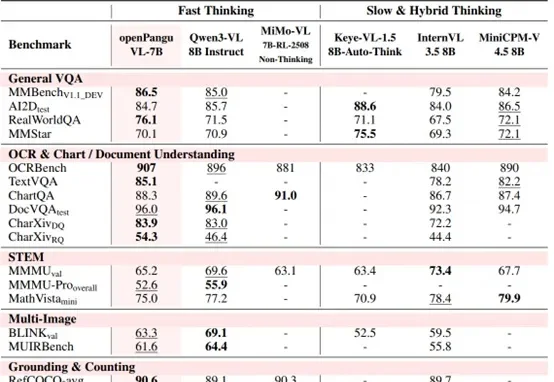

7B量级模型,向来是端侧部署与个人开发者的心头好。

刚刚,AI 前线获悉,前华为天才少年、原华为云具身智能核心负责人李元庆已正式加入乐享科技,后续将重点负责乐享科技的创新业务战略规划与核心技术攻关。

《智能涌现》独家获悉,由朱森华创立的“具脑磐石”,近期已完成数千万元的种子轮融资,资方为乐聚机器人等。

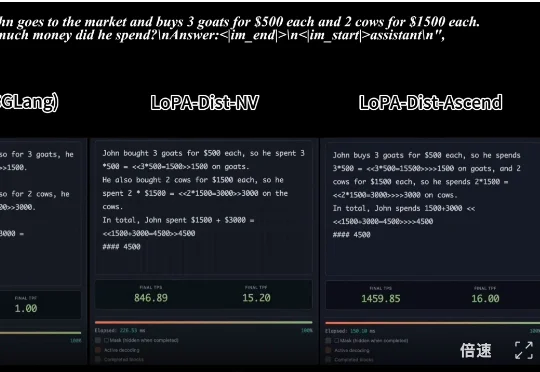

,时长 00:20 视频 1:单样例推理速度对比:SGLang 部署的 Qwen3-8B (NVIDIA) vs. LoPA-Dist 部署 (NVIDIA & Ascend)(注:NVIDIA 平台

在 LLM Agent 领域,有一个常见的问题:Agent 明明 "看到了" 错误信息,却总是重蹈覆辙。

最近,在 AI 基础算力上重磅频出的华为,又亮出了一张王牌:昇腾的底层基础软件,CANN 全面开源开放。昇腾宣布将通过一系列新举措,持续支持开发者在 AI 模型、算子、内核、底层资源等多个层级进行自主优化与自定义开发。通过开放共建,一个新兴的 AI 算力生态正在快速崛起,改变计算架构领域本已固化的格局。