模型「漂移」新范式,何恺明新作让生成模型无须迭代推理

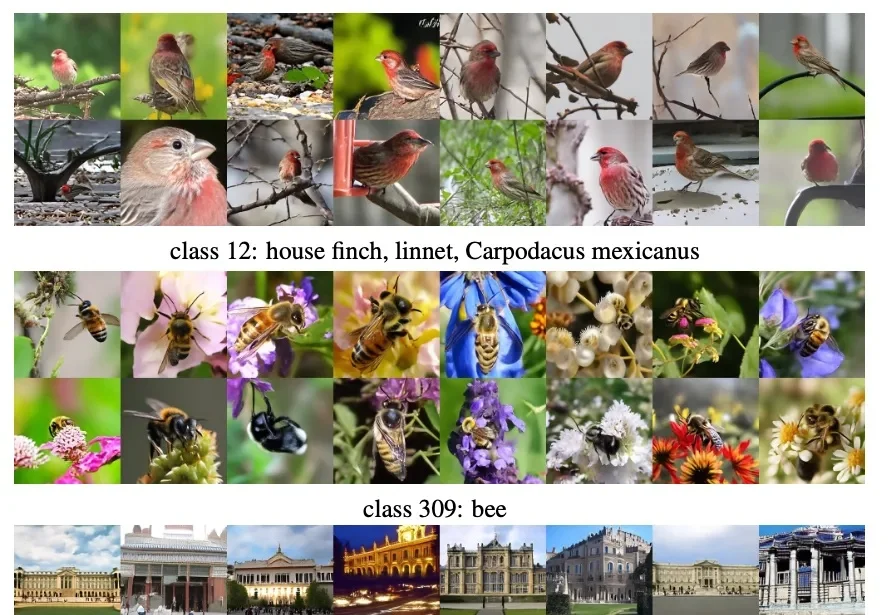

模型「漂移」新范式,何恺明新作让生成模型无须迭代推理训练一个生成模型是很复杂的一件事儿。 从底层逻辑上来看,生成模型是一个逐步拟合的过程。与常见的判别类模型不同,判别类模型通常关注的是将单个样本映射到对应标签,而生成模型则关注从一个分布映射到另一个分布。

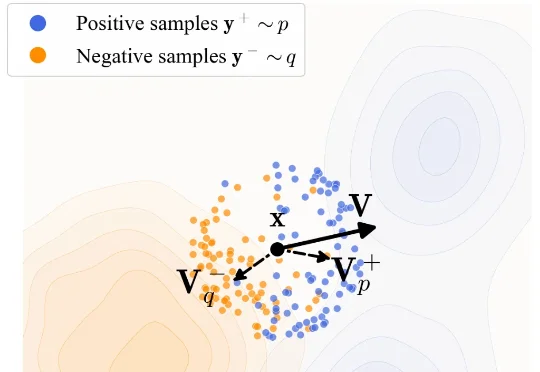

训练一个生成模型是很复杂的一件事儿。 从底层逻辑上来看,生成模型是一个逐步拟合的过程。与常见的判别类模型不同,判别类模型通常关注的是将单个样本映射到对应标签,而生成模型则关注从一个分布映射到另一个分布。

刚刚,何恺明团队提出全新生成模型范式漂移模型(Drifting Models)。

何恺明团队新论文,再次「大道至简」。

何恺明,再次出手精简架构。

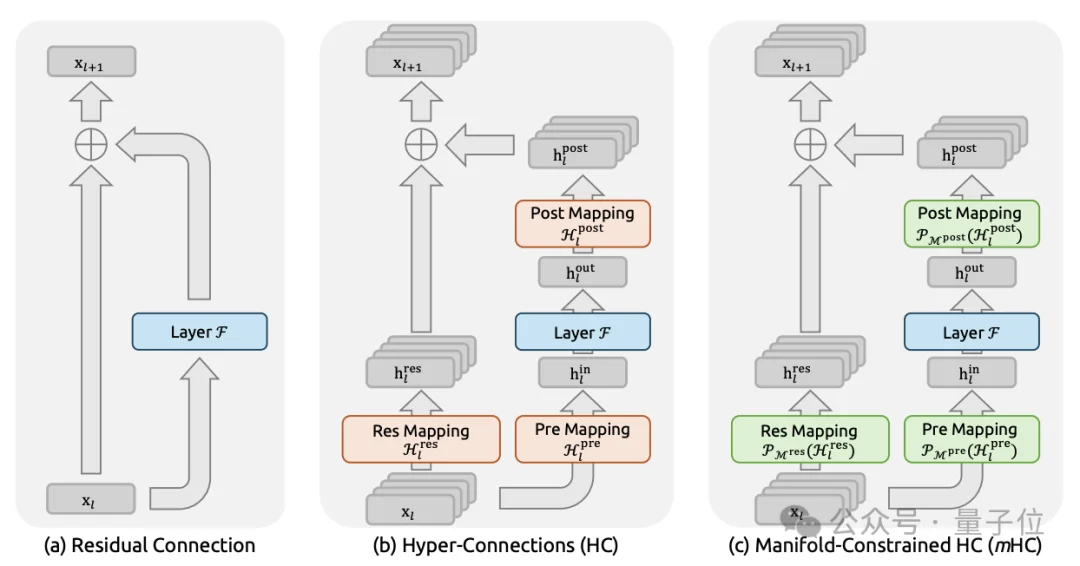

2026年新年第一天,DeepSeek上传新论文。给何恺明2016成名作ResNet中提出的深度学习基础组件“残差连接”来了一场新时代的升级。残差连接自2016年ResNet问世以来,一直是深度学习架构的基石。

不久前,NeurIPS 2025 顺利举办,作为人工智能学术界的顶级会议之一,其中不乏学术界大佬的工作和演讲。

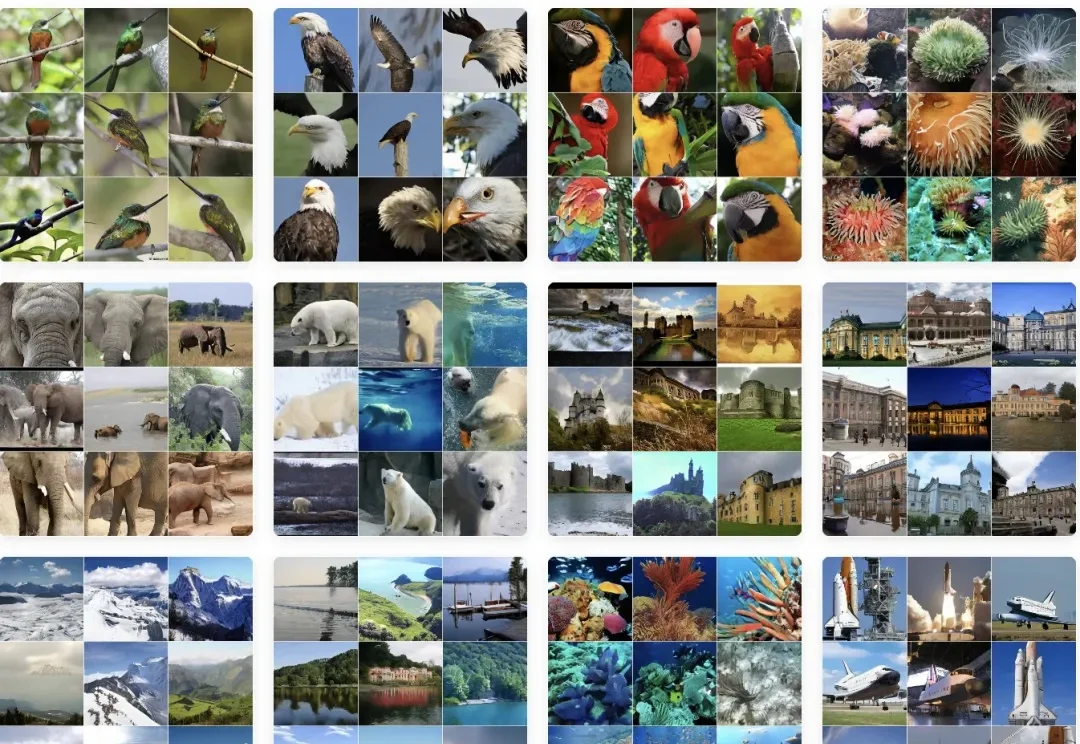

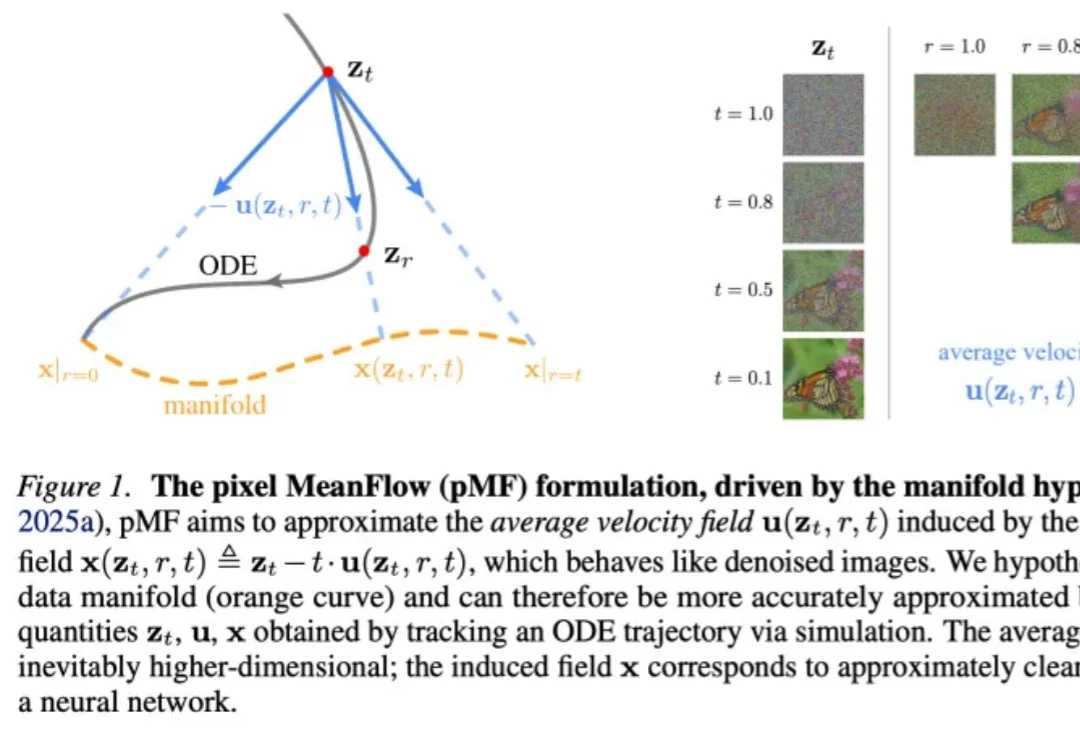

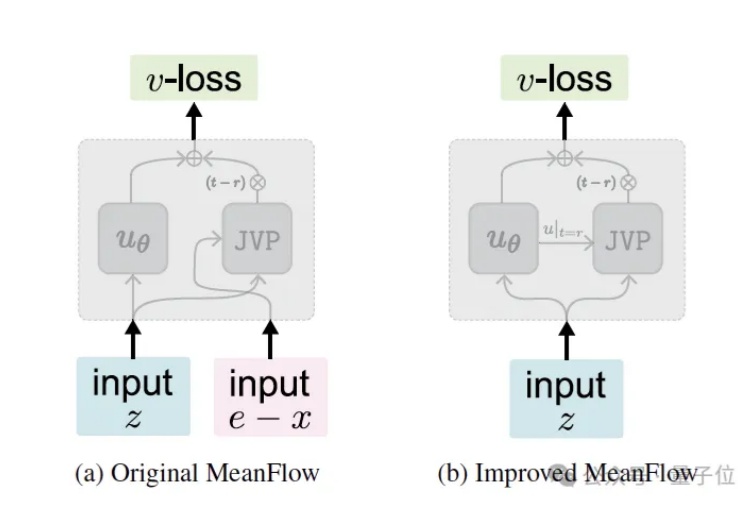

继今年5月提出MeanFlow (MF) 之后,何恺明团队于近日推出了最新的改进版本—— Improved MeanFlow (iMF),iMF成功解决了原始MF在训练稳定性、指导灵活性和架构效率上的三大核心问题。

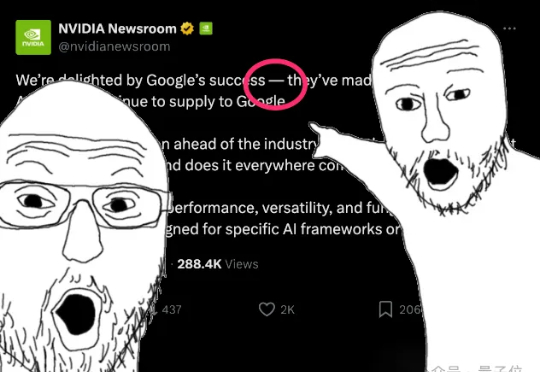

学术界看不下去了,直接戳破:华尔街在尬吹谷歌TPU!起因是Meta被曝要和谷歌签订数十亿美元的TPU订单,消息曝出后英伟达盘中最大跌幅达到了7%,按照现在的市值计算,一举蒸发了超3000亿美元。反观谷歌,在盘中情绪最热烈时涨幅一度达4%,换算成市值相当于增加了约1500亿美元,合人民币超1万亿。

今天,NeurIPS 2025最佳论文出炉!4篇最佳论文,华人占多半,何恺明孙剑等人曾提出的Faster R-CNN获「时间检验奖」,实至名归。

刚刚,NeurIPS 2025最佳论文奖、时间检验奖出炉!