视频生成独角兽Runway宣布拿下3.15亿美元,黄仁勋苏姿丰联手投资

视频生成独角兽Runway宣布拿下3.15亿美元,黄仁勋苏姿丰联手投资这家AI独角兽累计拿下56亿融资。

这家AI独角兽累计拿下56亿融资。

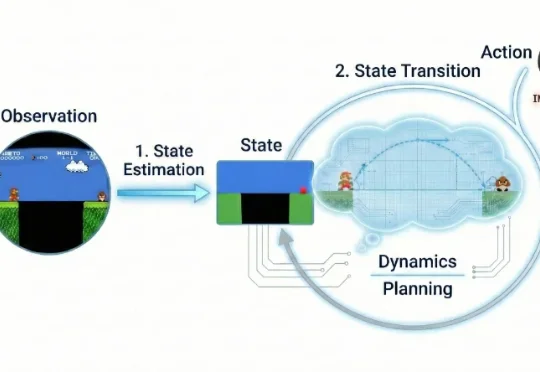

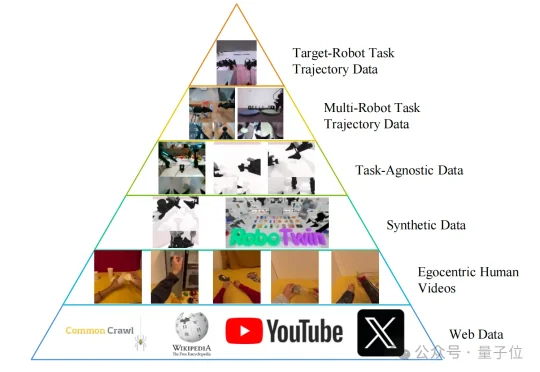

驱动具身智能进入通用领域最大的问题在哪里?

近年来,视频生成(Video Generation)与世界模型(World Models)已跃升为人工智能领域最炙手可热的焦点。从 Sora 到可灵(Kling),视频生成模型在运动连续性、物体交互与部分物理先验上逐渐表现出更强的「世界一致性」,让人们开始认真讨论:能否把视频生成从「逼真短片」推进到可用于推理、规划与控制的「通用世界模拟器」。

刚刚,Alphabet 旗下的自动驾驶汽车公司 Waymo,推出了最新世界模型 Waymo World Model,其基于 DeepMind 的 Genie 3 构建,在大规模、超真实自动驾驶仿真方面树立了全新的行业标杆。

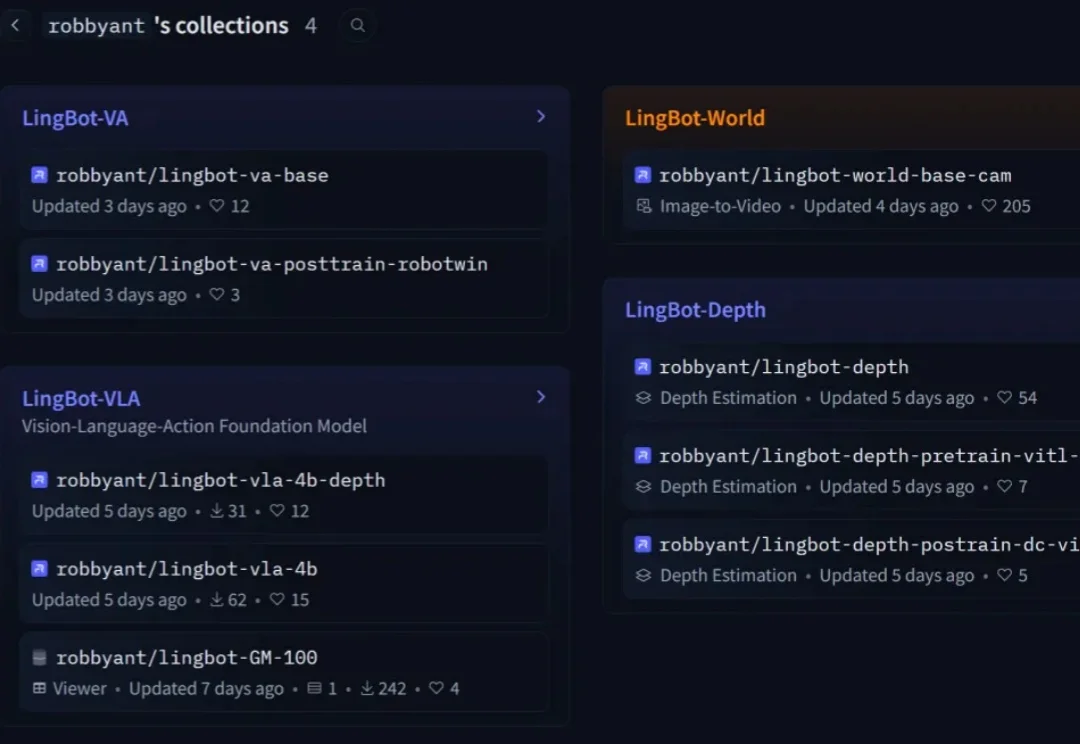

国产开源具身世界模型,直接秒了Pi-0.5,而且还是几位清华硕、博士研究生领衔推出的。这就是由生数科技联合清华大学,正式开源的大一统世界模型——Motus。

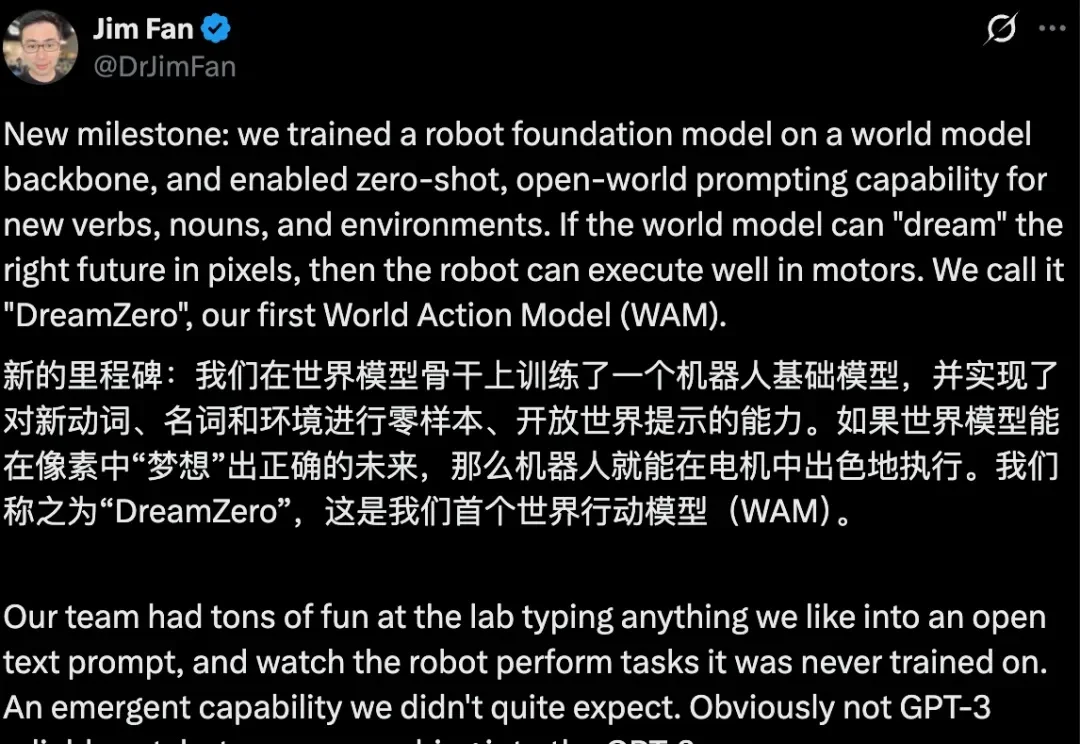

大模型的革命行将结束,即将开启的会是物理 AI 时代?

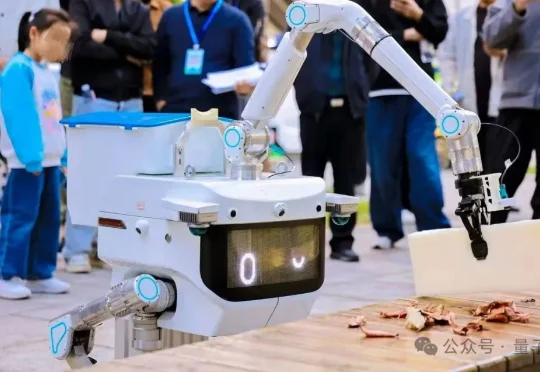

作为具身智能领域的代表性玩家,由上海交大系技术“双子星”——何弢博士与廖文龙博士联手掌舵的酷哇科技(Coowa),近期发布了其核心技术底座——COOWA WAM 2.0世界模型。

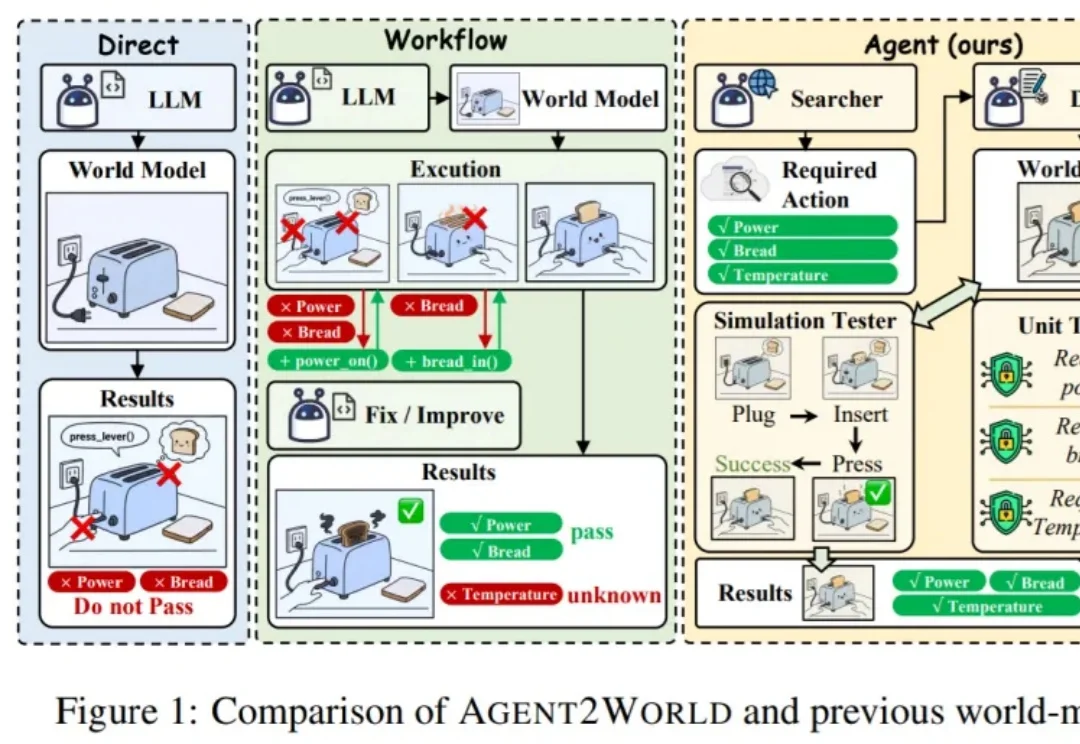

让模型真正 “能行动”,往往需要一个可执行、可验证的符号世界模型(Symbolic World Model):它不是抽象的文字描述,而是能被规划器或执行器直接调用的形式化定义 —— 例如 PDDL 领域 / 问题,或可运行的环境代码 / 模拟器。

世界模型真的变天了!今天,谷歌正式发布重磅世界模型原型产品“Project Genie”,只需一句话或一张图,就能一键生成可玩、可交互的实时虚拟世界。 它的重磅程度,让谷歌“掌舵人”劈柴哥和 Google DeepMind 创始人哈萨比斯亲自为它站台。