小扎“亿元俱乐部”刚组就被拆!千人AI团队面临裁员,高管也得走

小扎“亿元俱乐部”刚组就被拆!千人AI团队面临裁员,高管也得走疯狂扎克伯克,有点太猛了。 6个月内第4次重组AI部门…而且还被曝出疯批一样裁掉一些AI高管和员工……

疯狂扎克伯克,有点太猛了。 6个月内第4次重组AI部门…而且还被曝出疯批一样裁掉一些AI高管和员工……

据《彭博社》报道,Meta 将重组其超级智能实验室(Meta Superintelligence Labs,MSL)。

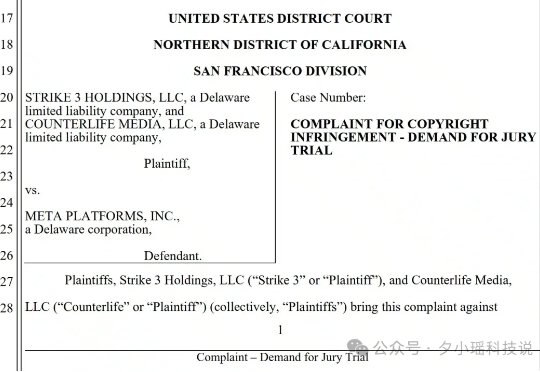

你有没有想过,Meta 训练 AI 用的数据里,有可能不只是维基百科、小说、YouTube 视频……而是你在某个晚上偷偷下载的成人电影? 你没听错。是色情片。而且不是三两个,而是 2396 部!

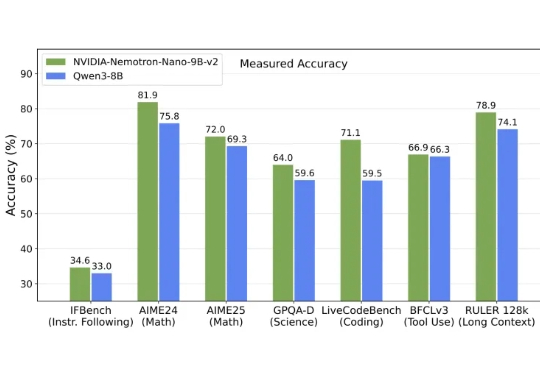

英伟达发布全新架构9B模型,以Mamba-Transformer混合架构实现推理吞吐量最高提升6倍,对标Qwen3-8B并在数学、代码、推理与长上下文任务中表现持平或更优。

最近,这家由前 Meta 和世嘉老兵组建AI游戏公司Studio Atelico,宣布完成500 万美元种子轮融资,由专AI的风投 Air Street Capital 领投,Hugging Face 核心成员 Thomas Wolf 参投,高调宣布要重新定义游戏体验 ,他们的目标,是让每个玩家都能拥有独一无二的动态世界。

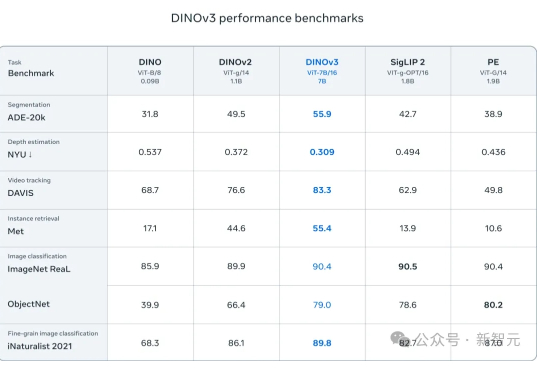

无需人工标注,吞下17亿张图片,Meta用自监督学习炼出「视觉全能王」!NASA已将它送上火星,医疗、卫星、自动驾驶领域集体沸腾。

加拿大AI新贵Cohere获5亿美元融资、估值68亿美元,前Meta FAIR副总裁、PyTorch与Llama重要推手Joelle Pineau加盟出任首席AI官,或将开启企业AI新战局。

给 Sam 的专业建议:直播选人要小心。 大家都是老朋友,在新 Lab 聚首了。

一面是Meta豪掷143亿美元下注Scale AI,一面是OpenAI紧急切断合作——当全球目光聚焦硅谷之时,一家藏身首尔的初创公司悄然撕开了AI安全市场的裂口。

过去一年,Meta 在 AI 上的出手堪称疯狂:斥资百亿收购 Scale AI 49% 股份、砸下上亿美元挖人补强团队,还任命年仅 26 岁的 Alexandr Wang 为 Meta 首任“首席 AI 官”。