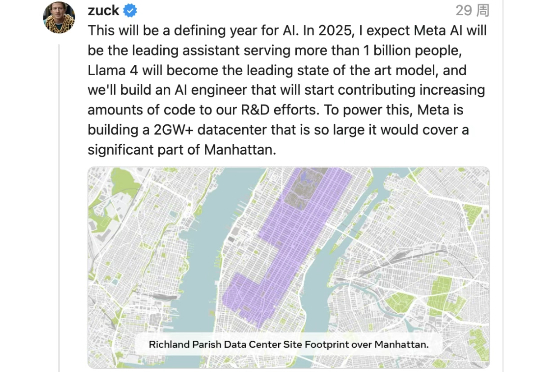

为见AI「女友」,76岁老人命丧途中!Meta聊天机器人酿成惨剧

为见AI「女友」,76岁老人命丧途中!Meta聊天机器人酿成惨剧一次虚拟「约会」,让一位76岁的老人走出了家门,却再也没能回来。屏幕那端的「她」,是Meta AI打造的聊天机器人——会说甜言蜜语,也会撒谎自称是真人。这不仅是一场个人悲剧,也揭开了AI伴侣背后的商业逻辑与安全漏洞。

一次虚拟「约会」,让一位76岁的老人走出了家门,却再也没能回来。屏幕那端的「她」,是Meta AI打造的聊天机器人——会说甜言蜜语,也会撒谎自称是真人。这不仅是一场个人悲剧,也揭开了AI伴侣背后的商业逻辑与安全漏洞。

Meta 首席 AI 负责人 Alexandr Wang 周五在 Threads 上发帖宣布,Meta 将与 Midjourney 合作 ,获得这家初创公司 AI 图像和视频生成技术的使用许可。Wang 表示 Meta 的研究团队将与 Midjourney 协作,将该技术整合到未来的 AI 模型和产品中。

万万没想到,当年为了𝕏扬言要找小扎线下打架的马斯克,如今竟回头拉拢人家合作了。 并且一开口,就是近千亿美金的超级大生意。

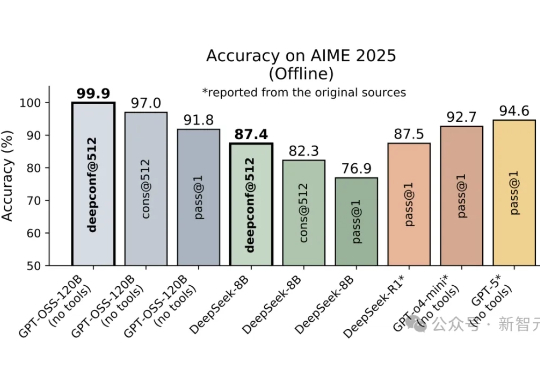

DeepConf由Meta AI与加州大学圣地亚哥分校提出,核心思路是让大模型在推理过程中实时监控置信度,低置信度路径被动态淘汰,高置信度路径则加权投票,从而兼顾准确率与效率。在AIME 2025上,它首次让开源模型无需外部工具便实现99.9%正确率,同时削减85%生成token。

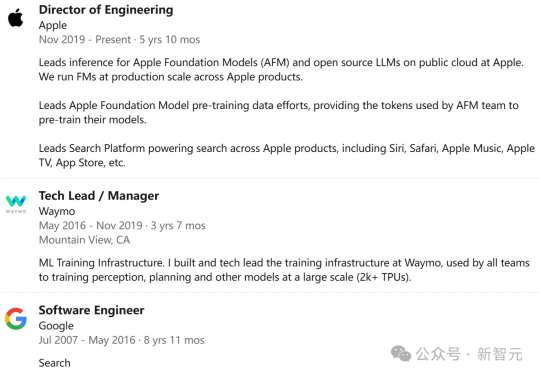

苹果AI再遭重创,核心工程师Frank Chu被曝加入Meta!与此同时,Meta也在豪掷重金招募超50名顶尖人才后,宣布紧急冻结招聘。

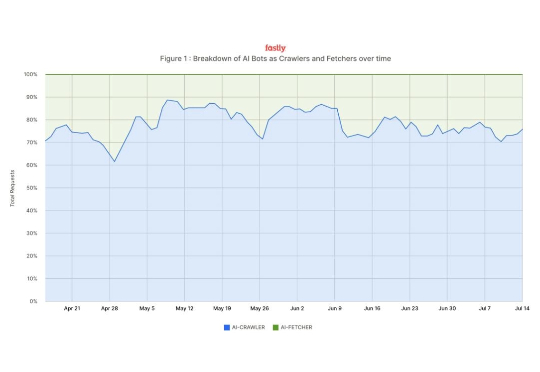

“我的网站被爬崩了,自己要付流量费,人家却用我的内容训练出 AI 模型,还赚足了眼球。” 自从 AI 机器人开始流行,很多网站开发者叫苦不堪。而近日,云服务巨头 Fastly 发布的一份报告让人看完直呼“现实往往我们仅听到的部分更为残酷。”

近日,据外媒消息,Meta 在本周早些时候重组了其人工智能部门后,已冻结招聘。这一举动与 Meta 此前报道的为顶尖人才提供高达 10 亿美元薪酬的计划截然不同,此前数周,该公司已从竞争对手那里挖走了 50 多名人工智能研究人员和工程师,其中包括来自 OpenAI 的 20 名研究人员和工程师,至少 13 名来自谷歌、3 名来自苹果、3 名来自 xAI 以及 2 名来自 Anthropic。

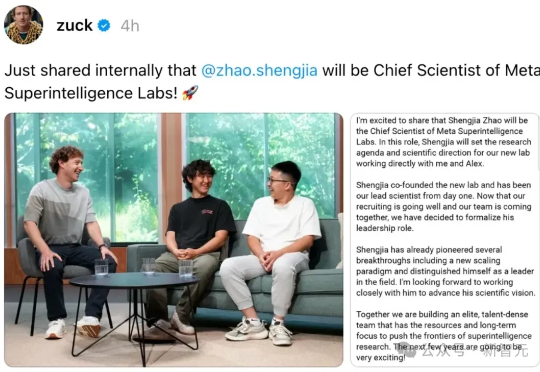

Meta超级智能实验室一拆四以后,首席AI官Alexandr Wang全员信曝光。这位28岁华人获扎克伯格力挺,出任超级智能实验室负责人。内部信强调「超级智能即将到来」,并宣布实验室拆分为四大部门。同时,AGI Foundations团队被解散,成员分流。Yann LeCun地位明显降级,权力重心全面向Wang集中。

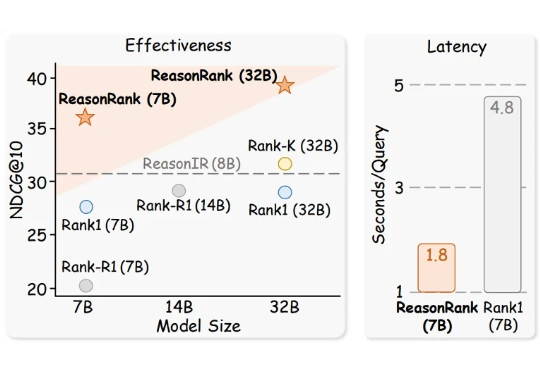

推理大模型(Large Reasoning Model)极大的促进了自然语言处理领域的发展,而信息检索领域的核心问题之一是文档排序,如何利用强大的推理大模型通过主动推理来判断文档的相关性,进而再对文档进行排序是一个值得探索的方向。

Meta在半年内第四次重组AI部门,将超级智能实验室拆分为四个团队,全面押注「超级智能」。新成立的TBD Lab由Alexandr Wang领衔,或放弃Llama 4并转向闭源模型,Meta开源旗帜动摇。Meta内部人心浮动,几家欢喜几家愁。