390亿美元Figure做不到的事,这家中国团队做到了

390亿美元Figure做不到的事,这家中国团队做到了机器人终于迎来自己的「iOS时刻」,全球首个具身Agentic OS来了:不是装个更聪明的大模型,而是给机器人配上一套真正的「操作系统」。

机器人终于迎来自己的「iOS时刻」,全球首个具身Agentic OS来了:不是装个更聪明的大模型,而是给机器人配上一套真正的「操作系统」。

时代变了,就连 Linus Torvalds 现在也氛围编程(Vibe Coding)了。

今天凌晨,喜欢闷声做大事的 DeepSeek 再次发布重大技术成果,在其 GitHub 官方仓库开源了新论文与模块 Engram,论文题为 “Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models”, 梁文锋再次出现在合著者名单中。

一边踩油门冲刺AGI,一边按喇叭预警:小心前面悬崖!Anthropic创始人Dario Amodei曾因预言「未来5年内AI可能消灭近一半初级白领岗位」而被贴上「末日预言家」标签,但他又因打造Claude身家数十亿美元。

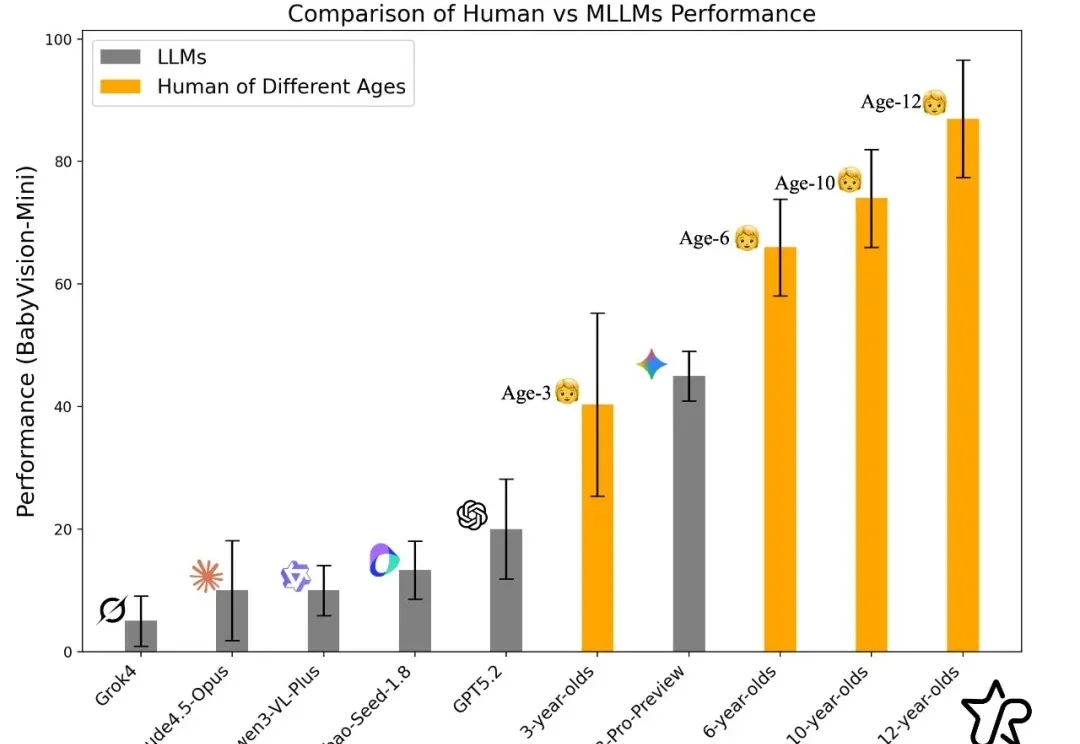

过去一年,大模型在语言与文本推理上突飞猛进:论文能写、难题能解、甚至在顶级学术 / 竞赛类题目上屡屡刷新上限。但一个更关键的问题是:当问题不再能 “用语言说清楚” 时,模型还能不能 “看懂”?

大模型能写代码、解奥数,却连幼儿园小班都考不过?简单的连线找垃圾桶、数积木,人类一眼即知,AI却因为无法用语言「描述」视觉信息而集体翻车。大模型到底「懂不懂」,这个评测基准给出答案。

《Nature Medicine》 的研究报道“A multimodal sleep foundation model for disease prediction”,研究人员开发了一种名为 SleepFM 的基础模型,从超过58万小时的记录中“学会”了睡眠的语言。这不仅是睡眠科学的进步,更是AI在生物医学领域的深层突围。

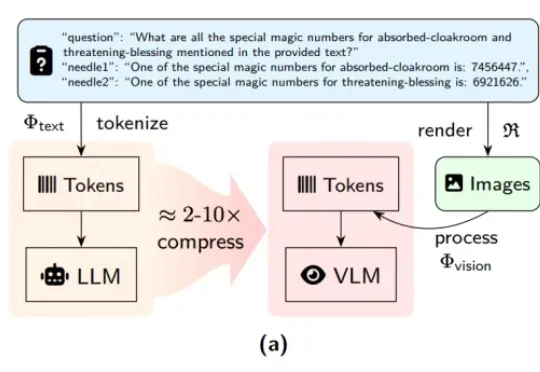

近期,DeepSeek-OCR 凭借其创新的「视觉文本压缩」(Vision-Text Compression, VTC)范式引发了技术圈的高度关注。为了解答这一疑问,来自中科院自动化所、中国科学院香港创新研究院等机构的研究团队推出了首个专门针对视觉 - 文本压缩范式的基准测试 ——VTCBench。

在人类满分都罕见的普特南数赛上,AI直接12题全对拿满分。陶哲轩等大佬预言AI已经取得了重要里程碑,再加上GPT-5.2 Pro在数学上强到「离谱」的表现,那种「奇点将近」的直觉,真的压不住了。

Information爆料称,DeepSeek将计划在2月中旬,也正是春节前后,正式发布下一代V4模型。据称,DeepSeek V4编程实力可以赶超Claude、GPT系列等顶尖闭源模型。