AI漫剧平台卷疯了: 纳米漫剧流水线 vs Zopia vs Flova vs OiiOii 哪家强?

AI漫剧平台卷疯了: 纳米漫剧流水线 vs Zopia vs Flova vs OiiOii 哪家强?大家好,我是刀哥。做过大厂研发、做过出海硬件,现在深耕 AI 视频、AI 漫剧。 深耕了几个月,一分钱没赚到,因为时间有限,上架困难,也没有聚焦。。。

大家好,我是刀哥。做过大厂研发、做过出海硬件,现在深耕 AI 视频、AI 漫剧。 深耕了几个月,一分钱没赚到,因为时间有限,上架困难,也没有聚焦。。。

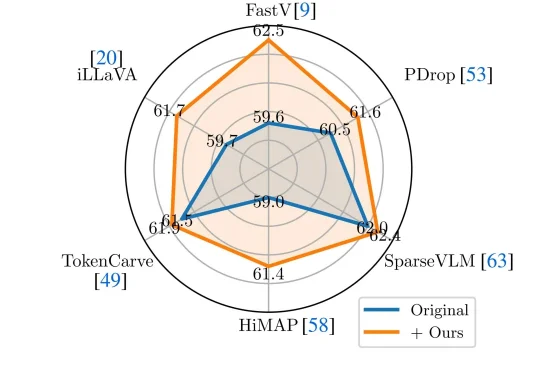

近年来,Vision-Language Models(视觉—语言模型)在多模态理解任务中取得了显著进展,并逐渐成为通用人工智能的重要技术路线。

这个春节,中国 AI 迎来「决战时刻」。据《The Information》援引内部消息人士透露:字节或将祭出全模态三件套;阿里除了或将发布强大的全新旗舰模型 Qwen 3.5 外,也会让千问打通支付与电商,挑战豆包;DeepSeek V4 或将携最强代码能力突袭。这不仅是技术竞赛,更是对 14 亿用户生活入口与未来互联网秩序的终极争夺。

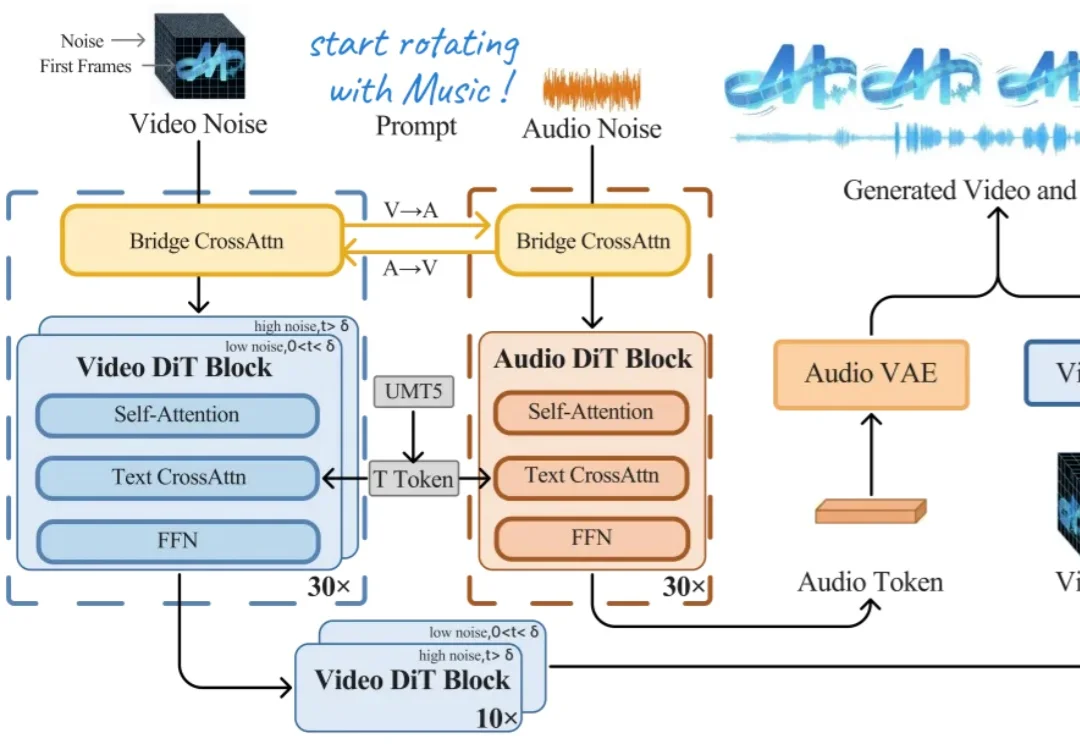

今天上午,上海创智学院 OpenMOSS 团队联合初创公司模思智能(MOSI),正式发布了端到端音视频生成模型 —— MOVA(MOSS-Video-and-Audio)。

果然,离开了OpenAI,大家都有美好的未来。(doge

大模型的出现,给许多行业带来了颠覆性的改变,运维这个向来被视为稳定、保守的领域也不例外。虽然“AIOps”这个概念早在 2016 年由 Gartner 提出,但早期的智能运维更多是利用大数据和机器学习对传统运维流程进行效率上的提升。

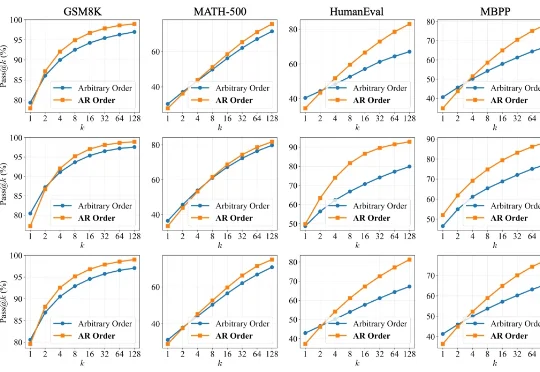

扩散语言模型(Diffusion LLMs, dLLMs)因支持「任意顺序生成」和并行解码而备受瞩目。直觉上,打破传统自回归(AR)「从左到右」的束缚,理应赋予模型更广阔的解空间,从而在数学、代码等复杂任务上解锁更强的推理潜力。

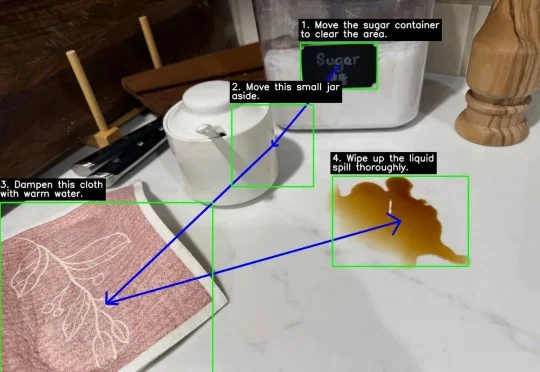

没想到吧,Google DeepMind刚刚为Gemini 3 Flash推出了一个重量级新能力:Agentic Vision(智能体视觉)。(难道是被DeepSeek-OCR2给刺激到了?)

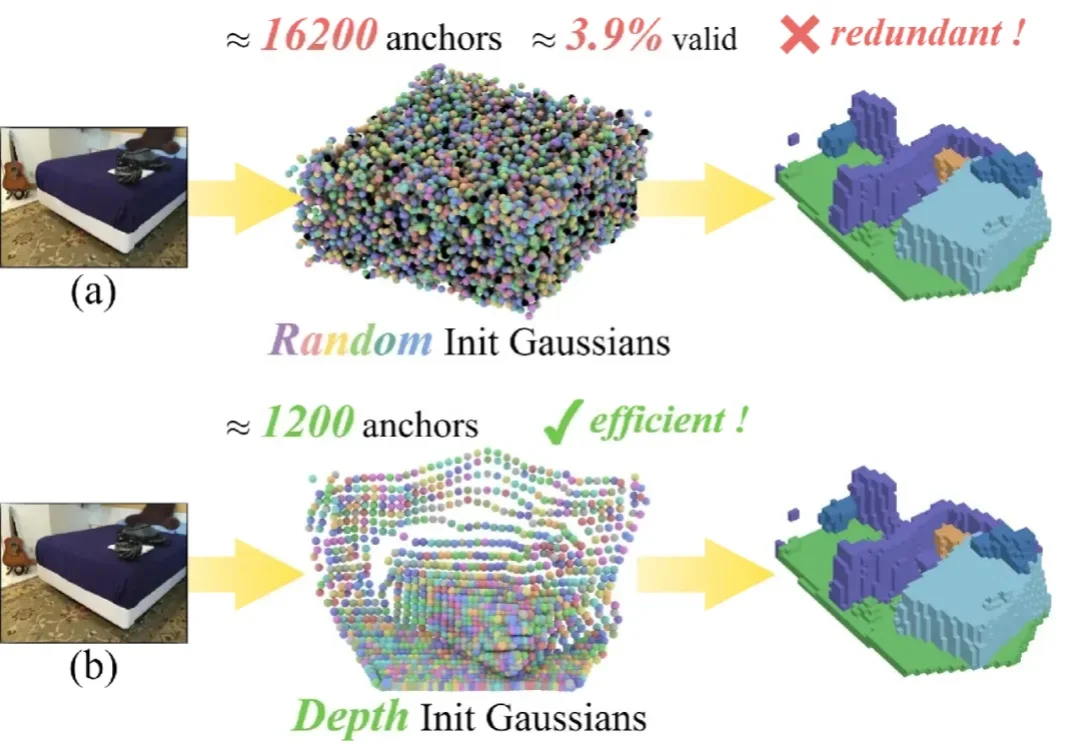

单目 3D 语义场景补全 (Semantic Scene Completion, SSC) 是具身智能与自动驾驶领域的一项核心技术,其目标是仅通过单幅图像预测出场景的密集几何结构与语义标签。

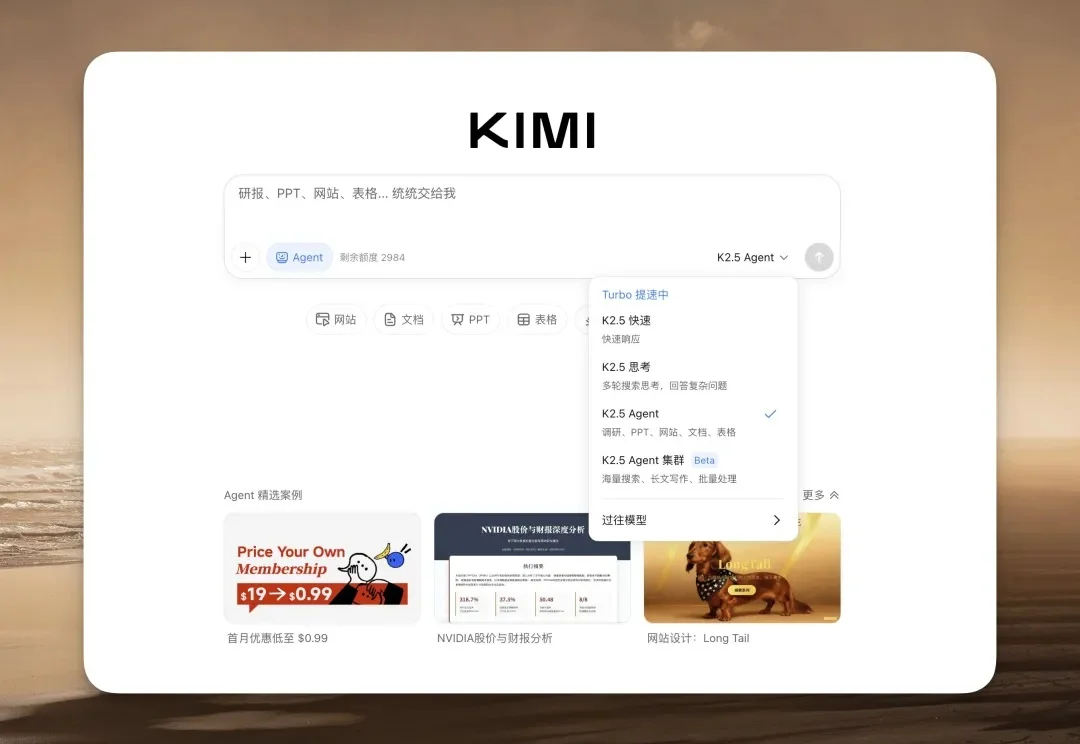

Kimi 上线了他们的 K2.5 模型,前端审美非常好,几乎要赶上 Gemini 3 了。