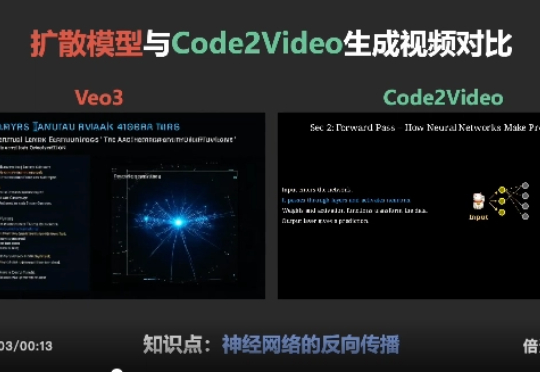

攻克长文档与多模态挑战,Paper2Video实现学术视频的自动化生产

攻克长文档与多模态挑战,Paper2Video实现学术视频的自动化生产学术展示视频作为科研交流的重要媒介,制作过程仍高度依赖人工,需要反复进行幻灯片设计、逐页录制和后期剪辑,往往需要数小时才能产出几分钟的视频,效率低下且成本高昂,这凸显了推动学术展示视频自动化生成的必要性。

学术展示视频作为科研交流的重要媒介,制作过程仍高度依赖人工,需要反复进行幻灯片设计、逐页录制和后期剪辑,往往需要数小时才能产出几分钟的视频,效率低下且成本高昂,这凸显了推动学术展示视频自动化生成的必要性。

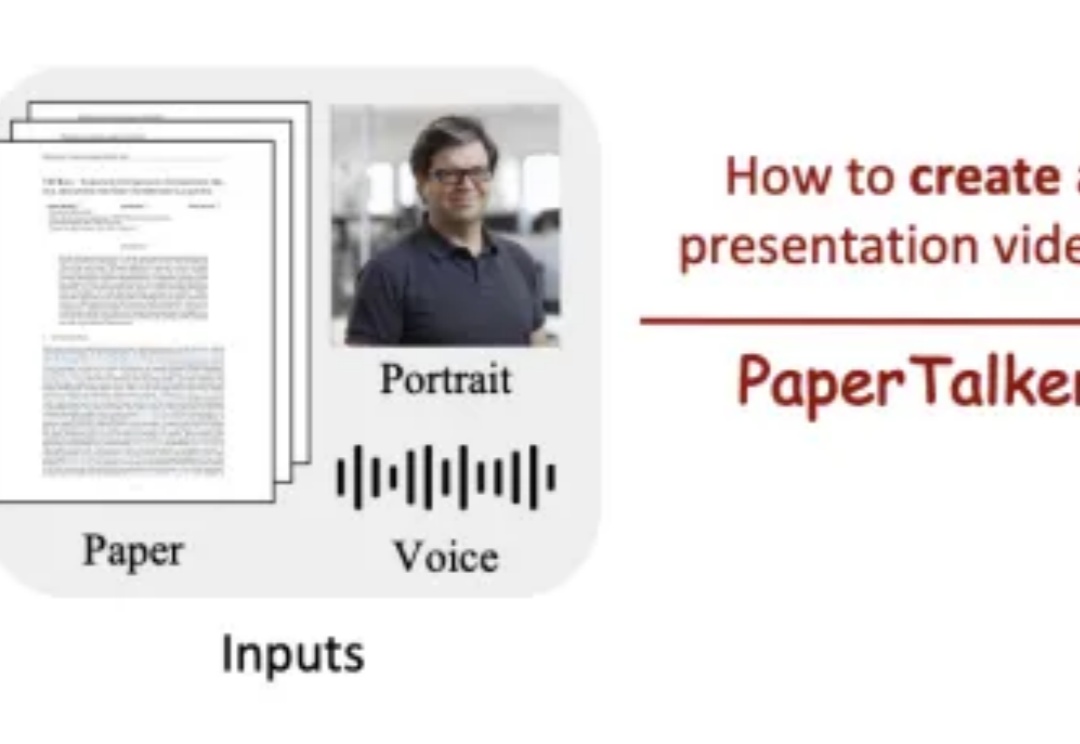

尽管视觉语言模型(LVLMs)在图像与短视频理解中已取得显著进展,但在处理长时序、复杂语义的视频内容时仍面临巨大挑战 —— 上下文长度限制、跨模态对齐困难、计算成本高昂等问题制约着其实际应用。针对这一难题,厦门大学、罗切斯特大学与南京大学联合提出了一种轻量高效、无需微调的创新框架 ——Video-RAG。

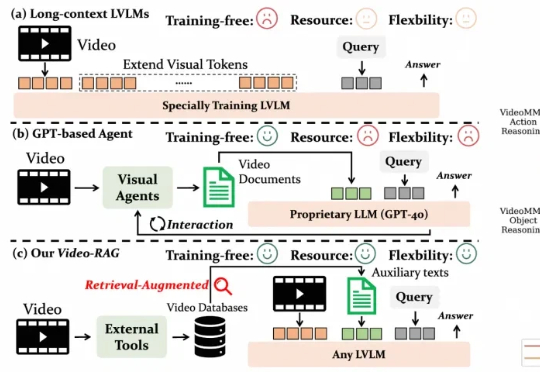

多模态大模型在根据静态截图生成网页代码(Image-to-Code)方面已展现出不俗能力,这让许多人对AI自动化前端开发充满期待。

本研究由新加坡国立大学 ShowLab 团队主导完成。 共一作者 Yanzhe Chen 陈彦哲(博士生)与 Kevin Qinghong Lin 林庆泓(博士生)均来自 ShowLab@NUS,分别聚焦于多模态理解以及智能体(Agent)研究。 项目负责人为新加坡国立大学校长青年助理教授 Mike Zheng Shou 寿政。

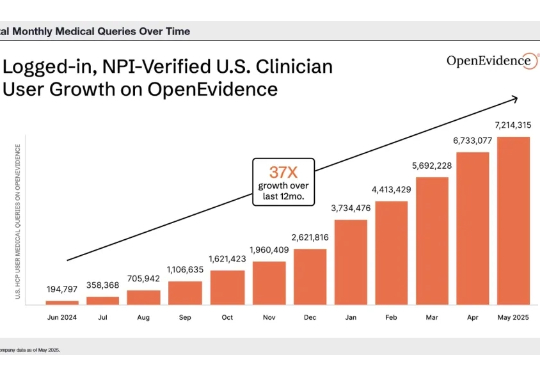

最近,美国多家 AI+医疗明星公司接连传来进展:OpenEvidence(医学知识搜索) 的 ARR 已突破 1000 万美元,每天有上万名医生付费使用;Abridge(临床文档转写) 完成 2.5 亿美元融资;Tempus AI(肿瘤学与精准医疗) 已在纳斯达克上市,市值一度超过 60 亿美元;Hippocratic AI(医疗专属大模型) 估值也已达数十亿美元。

Sora 2,用OpenAI的原话描述就是:“With Sora 2, we are jumping straight to what we think may be the GPT‑3.5 moment for video。”AI视频的ChatGPT时刻,正式来了。

全新一代 video-SALMONN 2/2+、首个开源推理增强型音视频理解大模型 video-SALMONN-o1(ICML 2025)、首个高帧率视频理解大模型 F-16(ICML 2025),以及无文本泄漏基准测试 AVUT(EMNLP 2025) 正式发布。新阵容在视频理解能力与评测体系全线突破,全面巩固 SALMONN 家族在开源音视频理解大模型赛道的领先地位。

近日,AI医疗上市公司Doximity,起诉另一家AI医疗独角兽OpenEvidence,指控其损害声誉并挖走员工。两家公司都在打造医生版“ChatGPT",但因为行业竞争而不断升级法律战。

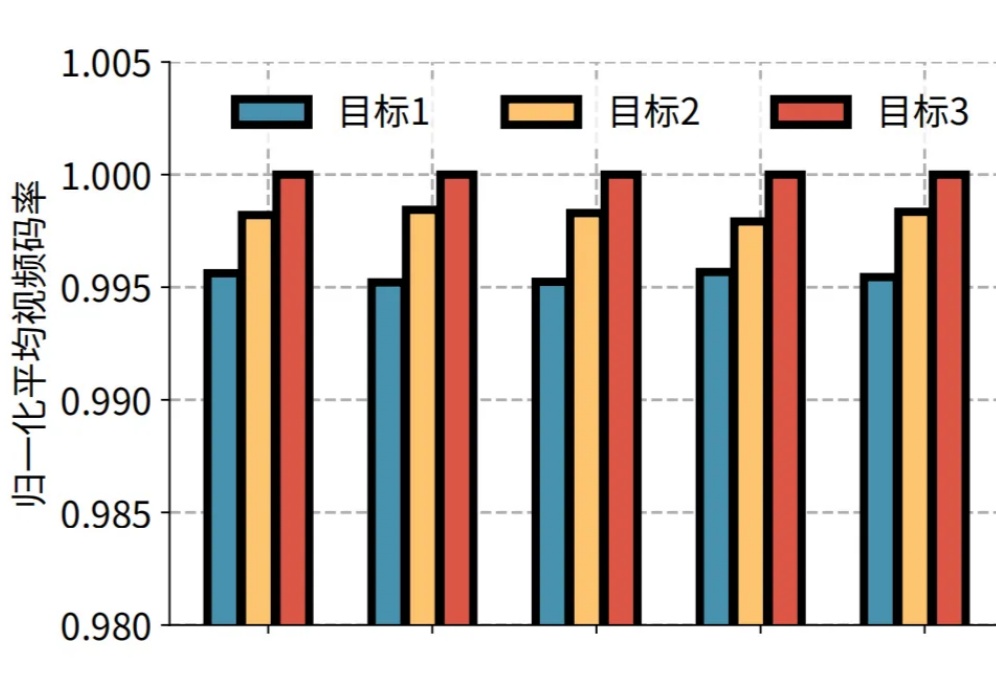

近日,快手与清华大学孙立峰团队联合发表论文《Towards User-level QoE: Large-scale Practice in Personalized Optimization of Adaptive Video Streaming》,被计算机网络领域的国际顶尖学术会议 ACM SIGCOMM 2025 录用。

AI医疗领域,冲出一匹年度黑马! 据外媒报道,美国AI医疗初创公司OpenEvidence正在寻求新一轮融资,估值约60亿美元(约合人民币427亿元)。