AI问答,直接「拍」给你看!来自快手可灵&香港城市大学

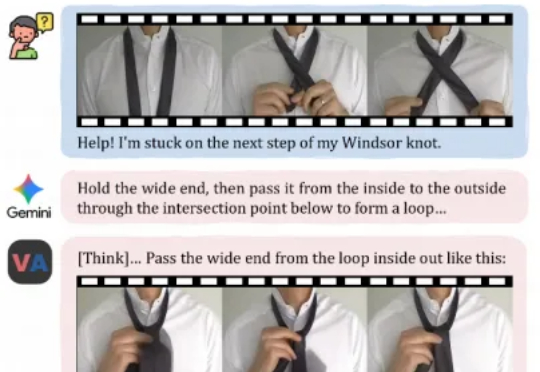

AI问答,直接「拍」给你看!来自快手可灵&香港城市大学今天,来自快手可灵团队和香港城市大学的研究者们,正在尝试打破这一界限。他们提出了一个全新的任务范式——「视频作为答案」,并发布了相应模型VANS。而这项工作则开创性地提出了Video-Next Event Prediction任务,要求模型直接生成一段动态视频作为回答。

今天,来自快手可灵团队和香港城市大学的研究者们,正在尝试打破这一界限。他们提出了一个全新的任务范式——「视频作为答案」,并发布了相应模型VANS。而这项工作则开创性地提出了Video-Next Event Prediction任务,要求模型直接生成一段动态视频作为回答。

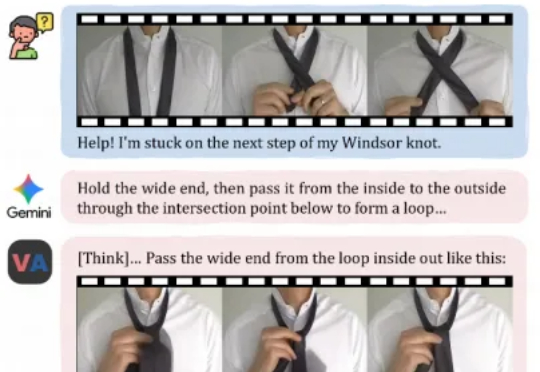

视频创作中,你是否曾希望复刻变成 Labubu 的特效,重现吉卜力风格化,跳出短视频平台爆火的同款舞蹈,或模仿复杂有趣的希区柯克运镜?

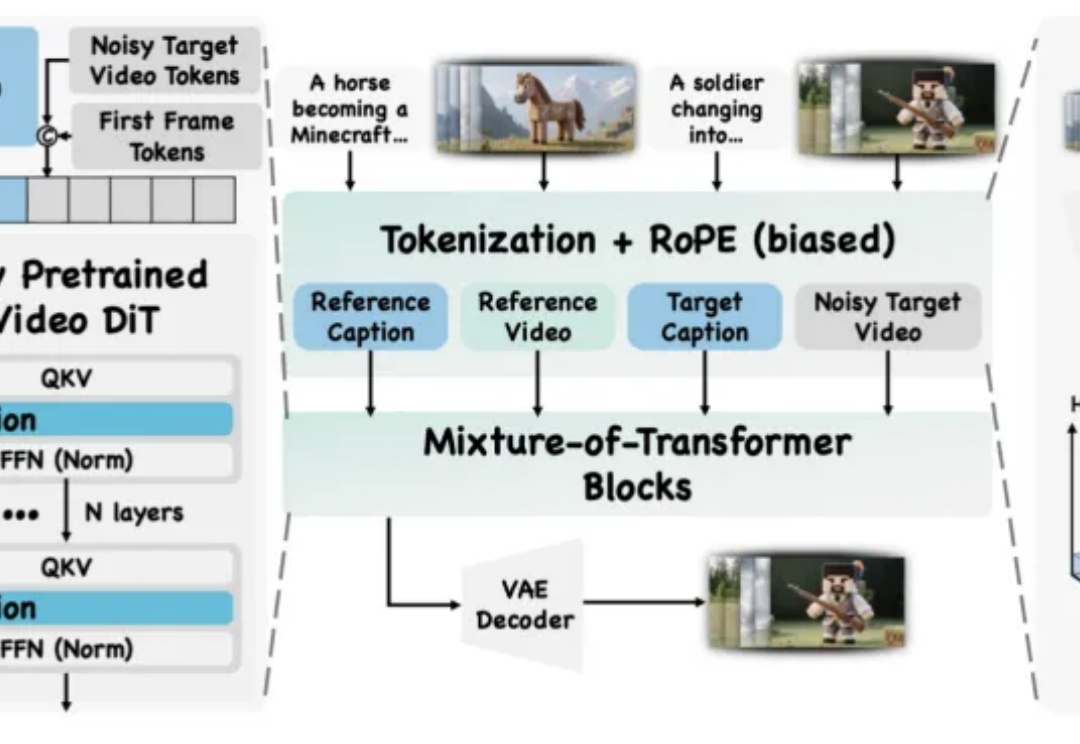

近年来,Stable Diffusion、CogVideoX 等视频生成模型在自然场景中表现惊艳,但面对科学现象 —— 如流体模拟或气象过程 —— 却常常 “乱画”:如下视频所示,生成的流体很容易产生违背物理直觉的现象,比如气旋逆向旋转或整体平移等等。

硅谷华人大三学生创立的教育类 AI 产品 VideoTutor,近日宣布完成 1100 万美元种子轮融资,成为硅谷学生创业中融资规模最高的项目。

AI 视频初创公司 Video Rebirth 今日宣布完成 5000 万美元的融资。本轮融资参与方阵容强大,包括全球及新加坡的头部美元基金、互联网巨头、中国及韩国老牌游戏上市公司、全球领先的芯片企业及知名家族办公室,募集资金将主要用于视频模型的持续迭代、顶尖人才招募及全球市场拓展。

每周我们都会和不少AI公司创业者交流,体验和评测新的AI产品,以各种方式去研究这些项目。

在多模态生成领域,由视频生成音频(Video-to-Audio,V2A)的任务要求模型理解视频语义,还要在时间维度上精准对齐声音与动态。早期的 V2A 方法采用自回归(Auto-Regressive)的方式将视频特征作为前缀来逐个生成音频 token,或者以掩码预测(Mask-Prediction)的方式并行地预测音频 token,逐步生成完整音频。

华人大三学生,1100 万美元种子轮,硅谷学生创业目前融资最高产品。

AI医学生产力工具开发公司「零假设」近日获近亿元A轮融资,由荷塘创投、国方创新、上海喆驭投资,老股东元禾原点超额认购。本轮融资主要用于打磨、落地场景化AI医学智能体,构建连通药企和医生的学术沟通桥梁。唯快资本长期担任独家融资顾问。

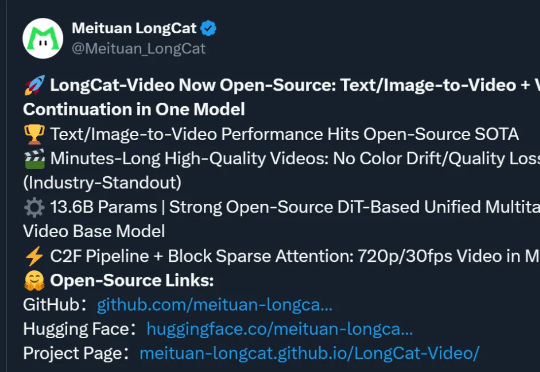

美团,你是跨界上瘾了是吧!(doge)没错,最新开源SOTA视频模型,又是来自这家“送外卖”的公司。模型名为LongCat-Video,参数13.6B,支持文生/图生视频,视频时长可达数分钟。