4.98万就能买机器人通用基座?!一机三态,多场景验证,标配VLA大脑

4.98万就能买机器人通用基座?!一机三态,多场景验证,标配VLA大脑坏事儿了,中国Kung fu,好像真被机器人学走了!摊手、膀手、伏手、挥拳,一套咏春拳下来,我当场愣住,妥妥机器人届的叶问啊:这个手脚灵活到有点过分的小小机器人,正是逐际动力推出的多形态具身机器人TRON 2,起售价4.98万元,即日起正式开启预售。

坏事儿了,中国Kung fu,好像真被机器人学走了!摊手、膀手、伏手、挥拳,一套咏春拳下来,我当场愣住,妥妥机器人届的叶问啊:这个手脚灵活到有点过分的小小机器人,正是逐际动力推出的多形态具身机器人TRON 2,起售价4.98万元,即日起正式开启预售。

视觉–语言–动作(VLA)模型在机器人场景理解与操作上展现出较强的通用性,但在需要明确目标终态的长时序任务(如乐高搭建、物体重排)中,仍难以兼顾高层规划与精细操控。

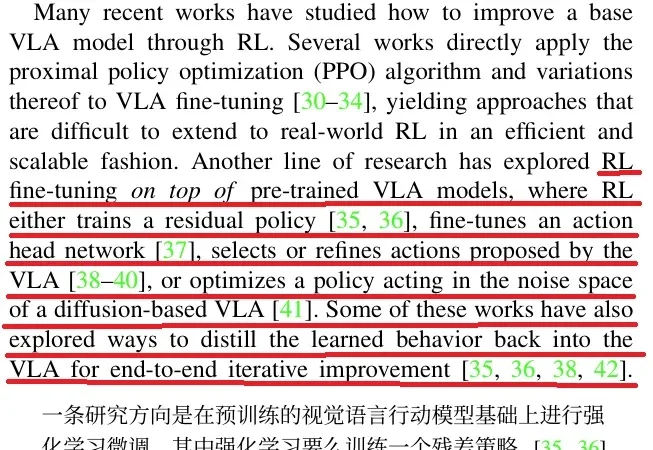

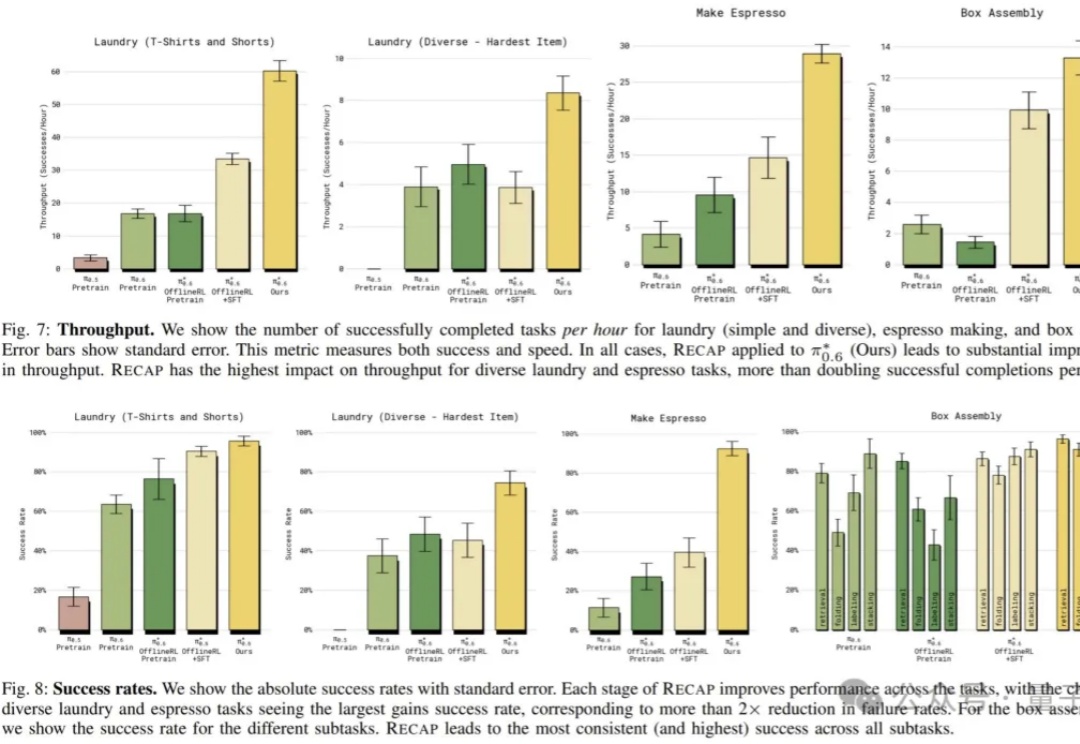

在 Physical Intelligence 最新的成果 π0.6 论文里,他们介绍了 π0.6 迭代式强化学习的思路来源:

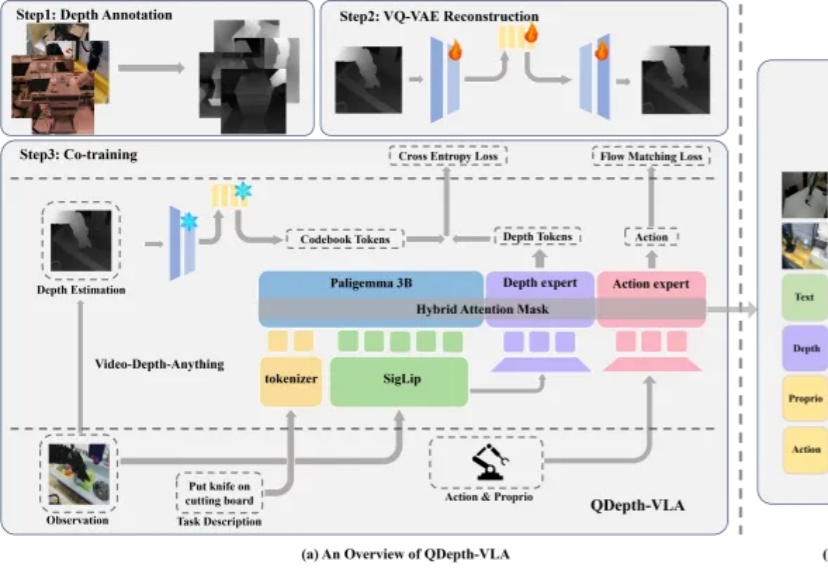

实现通用机器人的类人灵巧操作能力,是机器人学领域长期以来的核心挑战之一。近年来,视觉 - 语言 - 动作 (Vision-Language-Action,VLA) 模型在机器人技能学习方面展现出显著潜力,但其发展受制于一个根本性瓶颈:高质量操作数据的获取。

Vision–Language–Action(VLA)策略正逐渐成为机器人迈向通用操作智能的重要技术路径:这类策略能够在统一模型内同时处理视觉感知、语言指令并生成连续控制信号。

VLA模型性能暴涨300%,背后训练数据还首次实现90%由世界模型生成。

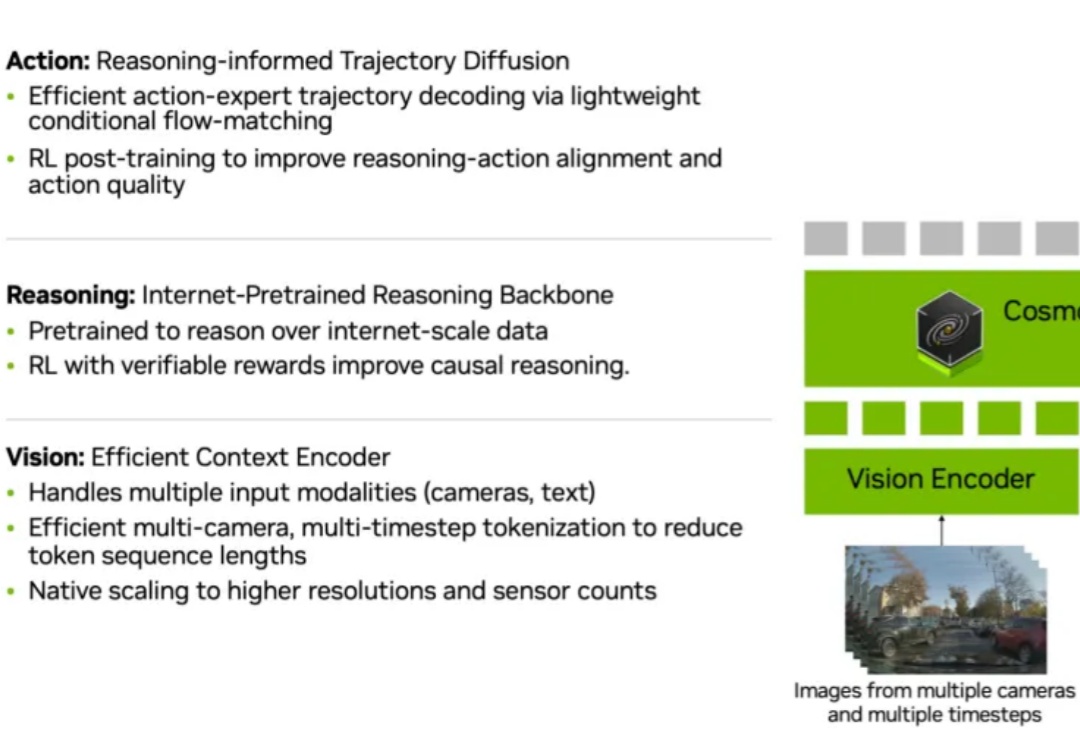

当今自动驾驶模型越来越强大,摄像头、雷达、Transformer 网络一齐上阵,似乎什么都「看得见」。但真正的挑战在于:模型能否像人一样「想明白」为什么要这么开?

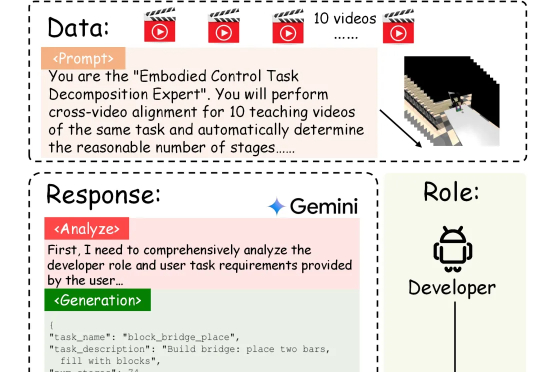

具身智能的「ChatGPT时刻」还没到,机器人的「幻觉」却先来了?在需要几十步操作的长序列任务中,现有的VLA模型经常「假装在干活」,误以为任务完成。针对这一痛点,北京大学团队提出自进化VLA框架EvoVLA。该模型利用Gemini生成「硬负样本」进行对比学习,配合几何探索与长程记忆,在复杂任务基准Discoverse-L上将成功率提升了10.2%,并将幻觉率从38.5%大幅降至14.8%。

视觉-语言-动作模型(VLA)在机器人操控领域展现出巨大潜力。通过赋予预训练视觉-语言模型(VLM)动作生成能力,机器人能够理解自然语言指令并在多样化场景中展现出强大的泛化能力。然而,这类模型在应对长时序或精细操作任务时,仍然存在性能下降的现象。

看似轻描淡写,实则力透纸背。