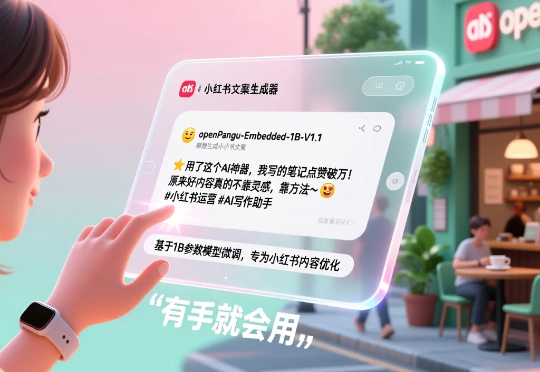

普通人也能「炼丹」了?我拿小红书文案喂给openPangu-Embedded-1B的模型,几步就把它变成了专属文案大师!

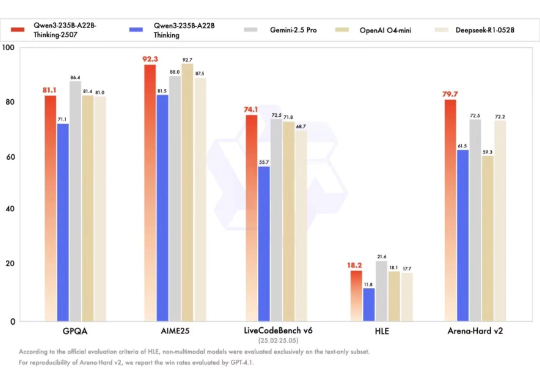

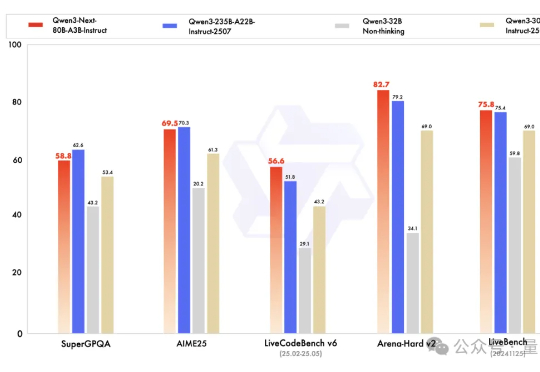

普通人也能「炼丹」了?我拿小红书文案喂给openPangu-Embedded-1B的模型,几步就把它变成了专属文案大师!我想聊个反向操作:咱们普通人,如何用有限的资源,轻松驯服一个 AI 模型,让它变成我们专属的垂直领域小能手?主角,就是最近华为刚刚开源的一个大小仅为 1B 的模型 openPangu-Embedded-1B,它不仅全面领先同规格模型,甚至与更大规模的 Qwen3-1.7B 也难分伯仲。