小参数模型也进入了 R1 时代,这次开源出新技术的是 Meta。

本周五,Meta AI 团队正式发布了 MobileLLM-R1。

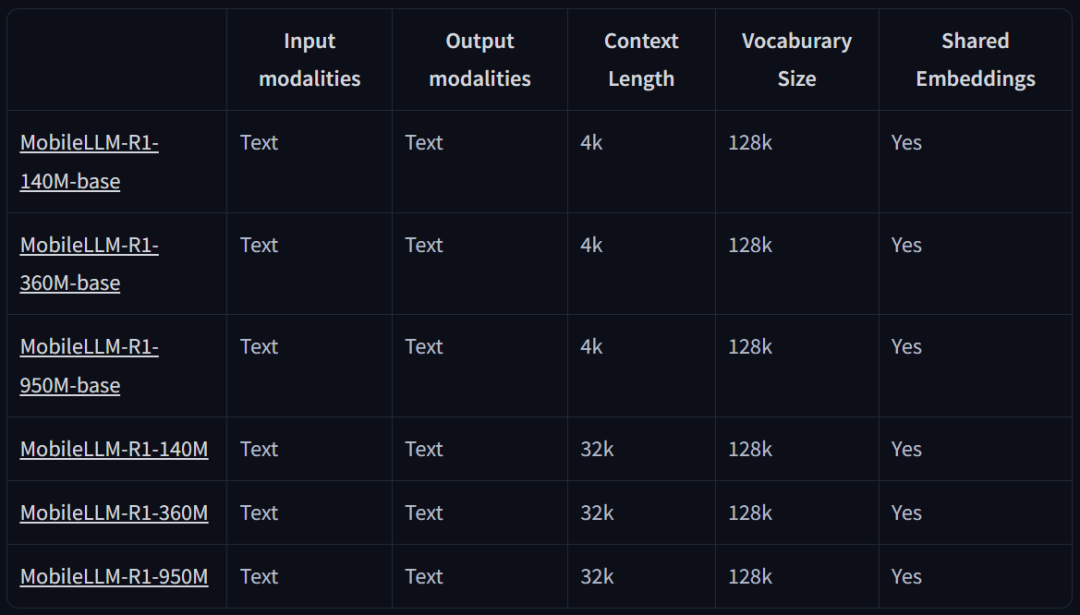

这是 MobileLLM 的全新高效推理模型系列,包含两类模型:基础模型 MobileLLM-R1-140M-base、MobileLLM-R1-360M-base、MobileLLM-R1-950M-base 和它们相应的最终模型版。

它们不是通用的聊天模型,而是监督微调 (SFT) 模型,专门针对数学、编程(Python、C++)和科学问题进行训练。

除了模型本身之外,Meta 还发布了完整的训练方案和数据源,以确保可重复性并支持进一步的研究。

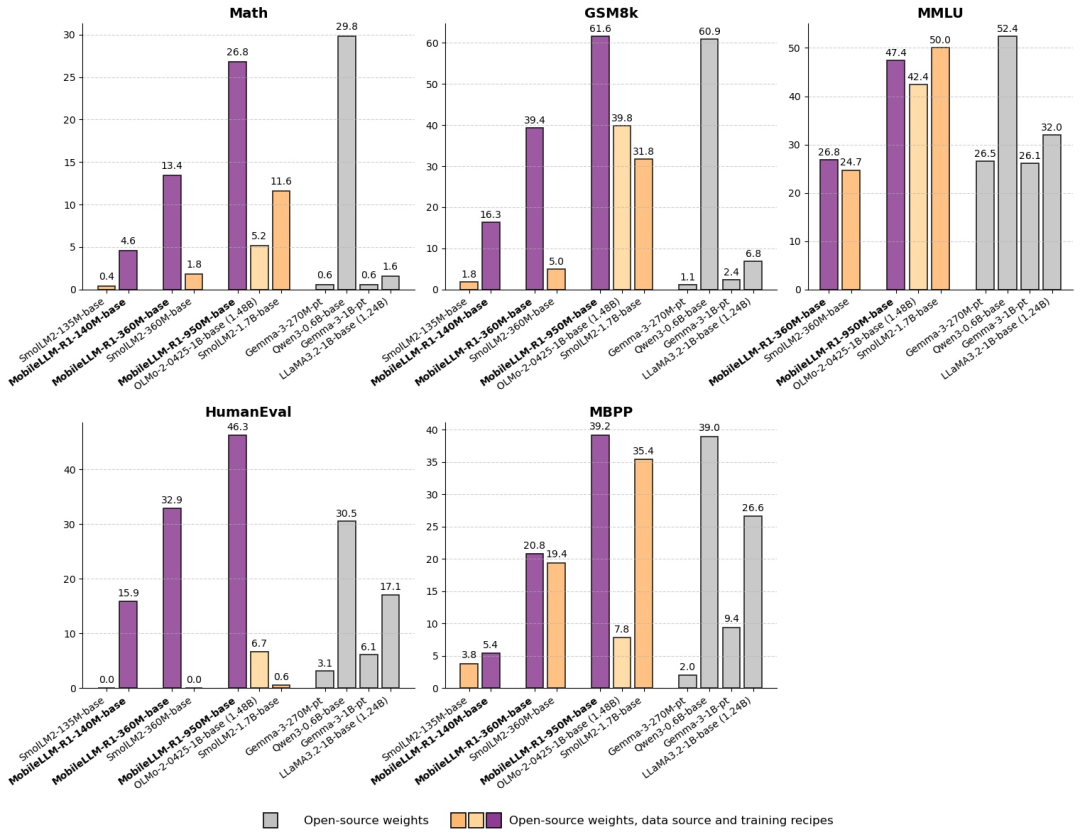

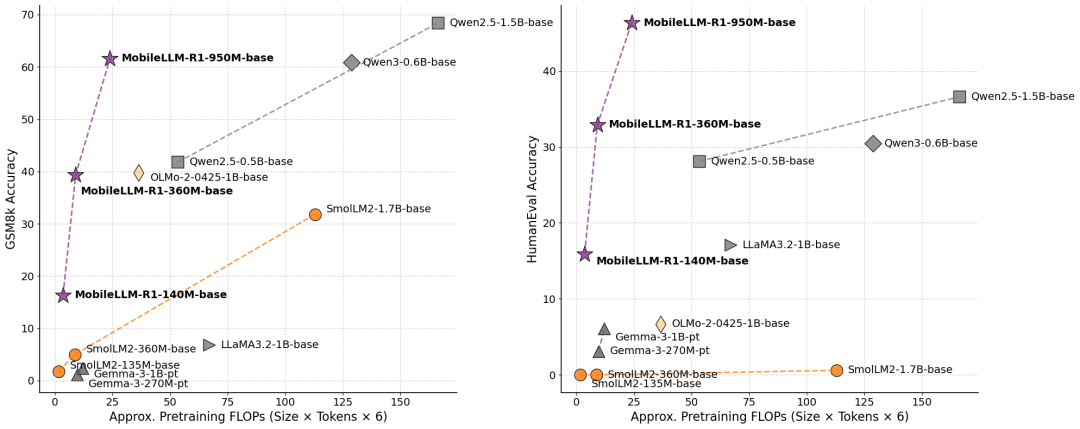

值得注意的是,该系列参数最大的 MobileLLM-R1 950M 模型仅使用约 2T 高质量 token 进行预训练,总训练 token 量少于 5T,但在 MATH、GSM8K、MMLU 和 LiveCodeBench 基准测试中,其性能与使用 36T token 进行训练的 Qwen3 0.6B 相当或更佳。

与现有的完全开源模型相比,尽管参数规模明显更小,MobileLLM-R1 950M 模型在 MATH 基准上的准确率也比 Olmo 1.24B 模型高出约五倍,比 SmolLM2 1.7B 模型高出约两倍。此外,MobileLLM-R1 950M 在编码基准测试中的表现远超 Olmo 1.24B 和 SmolLM2 1.7B ,在完全开源模型中创下了新的最高水平。

Token 效率的比较如下:

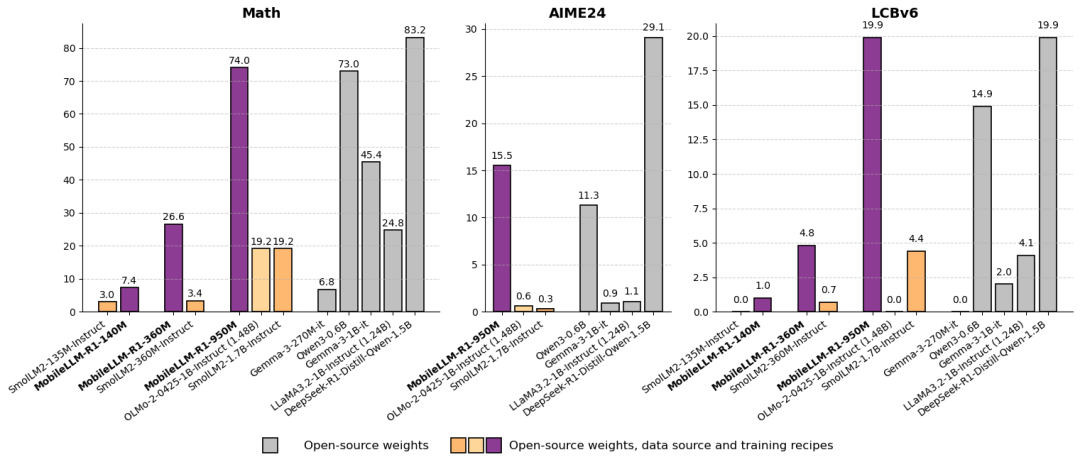

后训练比较:

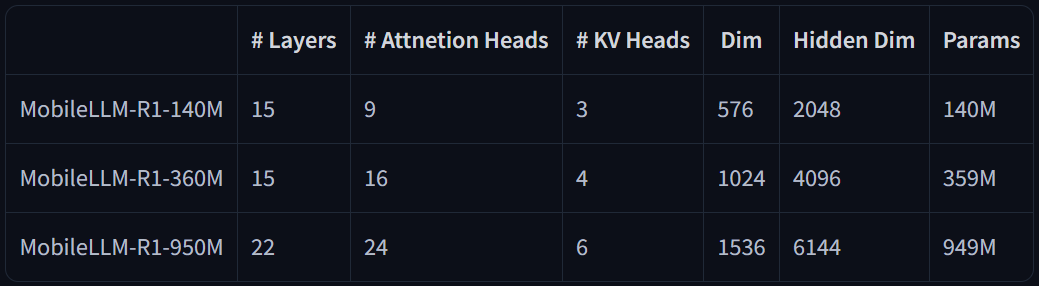

模型架构:

MobileLLM-R1 的发布引起了机器学习社区的讨论。人们欢迎通义、Meta 等顶尖大模型团队基于小体量模型的探索。这一方向的训练成本较为低廉,可以更加方便尝试各类最新论文提出的技术,更重要的是,模型体量的下降也意味着它可以覆盖更多端侧设备,实现更大面积的落地。

随着训练成本普遍下降,我们将会得到更好的模型。

在 MobileLLM-R1 系列发布的同时,背后的作者们也正式亮相,他们表示,该工作的研发时间有一年之久。该项目由华人领衔。

Zechun Liu

Zechun Liu 是 Meta AI 的研究科学家,专注于大模型和基础模型的高效部署与优化。

她的研究涉及大语言模型的预训练与后训练,神经网络架构设计与搜索,量化、剪枝与稀疏性,知识蒸馏以及高效的视觉 - 语言模型等,目标是在计算资源有限的环境中实现高性能模型的推理和部署。

2016 年,她在复旦大学获得本科学位,2019 年至 2021 年在卡内基梅隆大学担任访问学者,导师为 Marios Savvides 教授和 Eric Xing(邢波)教授。2021 年 6 月获得香港科技大学的博士学位,师从 Kwang-Ting Tim CHENG 教授。

Zechun Liu 在顶级会议和期刊上发表了 20 多篇论文,其论文引用量达到了数千次。

Ernie Chang

Ernie Chang 是 Meta AI 的研究科学家,专注于自然语言处理、多模态学习和高效模型部署等领域。

他于 2023 年 2 月加入 Meta,参与了多个前沿项目的研究和开发。

在他的研究中,Ernie Chang 参与了多个重要的项目和论文。例如,他是《Agent-as-a-Judge: Evaluate Agents with Agents》一文的共同作者,该论文提出了一种新的评估方法,通过代理模型对其他代理模型进行评估,从而提高评估效率和准确性。

此外,他还参与了《MobileLLM: Optimizing Sub-billion Parameter Language Models for On-Device Use Cases》的研究,该研究致力于优化小语言模型,以适应移动设备上的应用需求。

Ernie Chang 的研究兴趣包括多语言处理、多模态系统等。

Changsheng Zhao(赵常盛)

Changsheng Zhao 是 Meta AI 的研究科学家,专注于自然语言处理、深度学习和大语言模型的高效部署与优化。

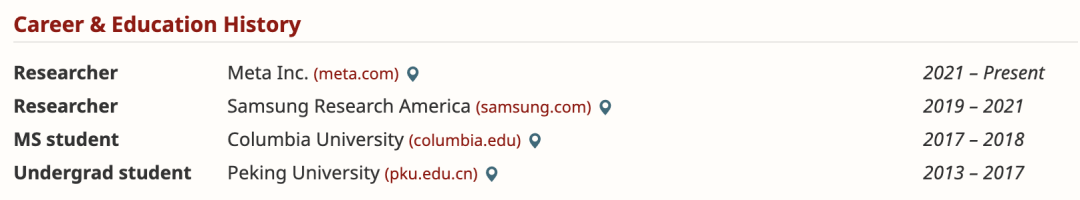

他本科毕业于北京大学,后在哥伦比亚大学攻读硕士学位,毕业后去了三星美国研究员担任研究员,2021 年加入 Meta。

在 Meta,Changsheng Zhao 参与了多个前沿研究项目,主要集中在模型量化、神经网络架构和多模态系统等领域。 部分代表性工作包括:

文章来自于微信公众号 “机器之心”,作者 “机器之心”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner