「完美的搜索引擎」是否存在?这家公司向谷歌发起挑战

「完美的搜索引擎」是否存在?这家公司向谷歌发起挑战大型语言模型(LLMs)能够解决研究生水平的数学问题,但今天的搜索引擎却无法准确理解一个简单的三词短语。

大型语言模型(LLMs)能够解决研究生水平的数学问题,但今天的搜索引擎却无法准确理解一个简单的三词短语。

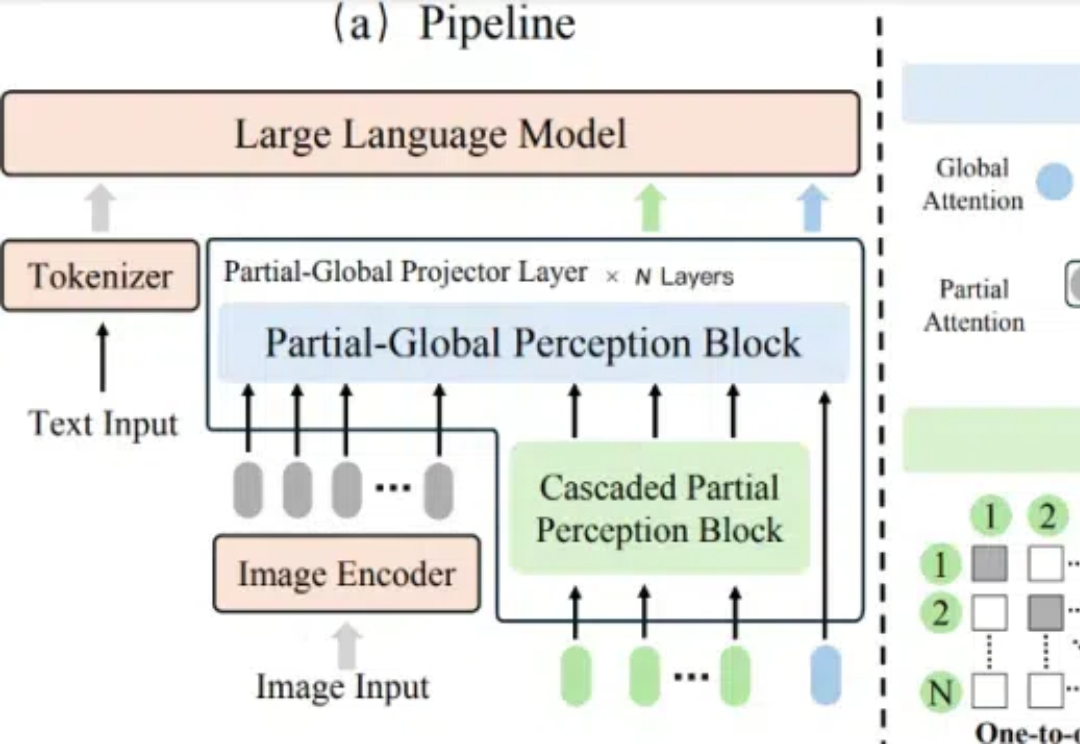

在多模态大语言模型(MLLMs)的发展中,视觉 - 语言连接器作为将视觉特征映射到 LLM 语言空间的关键组件,起到了桥梁作用。

检索-增强生成 (RAG) 是一个永不过时的话题,并在不断扩展以增强LLMs 的功能。对于那些不太熟悉RAG 的人来说:这种方法利用外部知识来增强模型的能力,从外部资源中检索您实际需要的信息。

在人工智能领域,大语言模型(LLMs)展现出了令人惊叹的能力,但在因果推理这一人类智能的核心能力上仍面临重大挑战。特别是在从相关性信息推断因果关系这一任务上,现有的大语言模型表现出明显的不足。

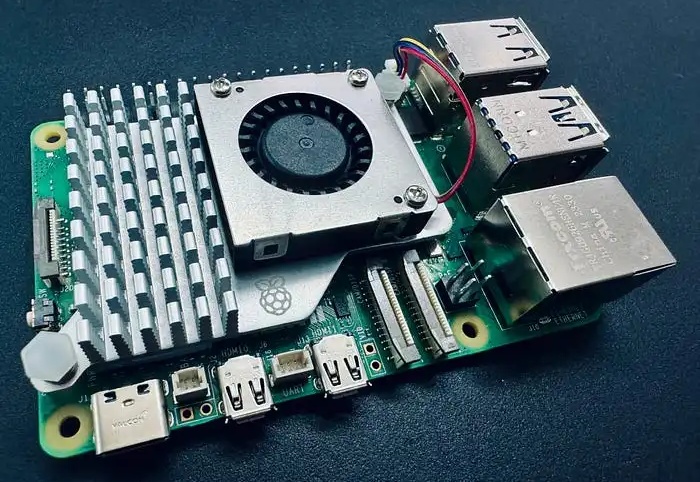

你是否想过在自己的设备上运行自己的大型语言模型(LLMs)或视觉语言模型(VLMs)?你可能有过这样的想法,但是一想到要从头开始设置、管理环境、下载正确的模型权重,以及你的设备是否能处理这些模型的不确定性,你可能就犹豫了。

大模型的的发布固然令人欣喜,但是各类测评也是忙坏了众多 AI 工作者。大模型推理的幻觉问题向来是 AI 测评的重灾区,诸如 9.9>9.11 的经典幻觉问题,各大厂家恨不得直接把问题用 if-else 写进来。

在当今迅速发展的人工智能时代,大语言模型(LLMs)在各种应用中发挥着至关重要的作用。然而,随着其应用的广泛化,模型的安全性问题也引起了广泛关注。

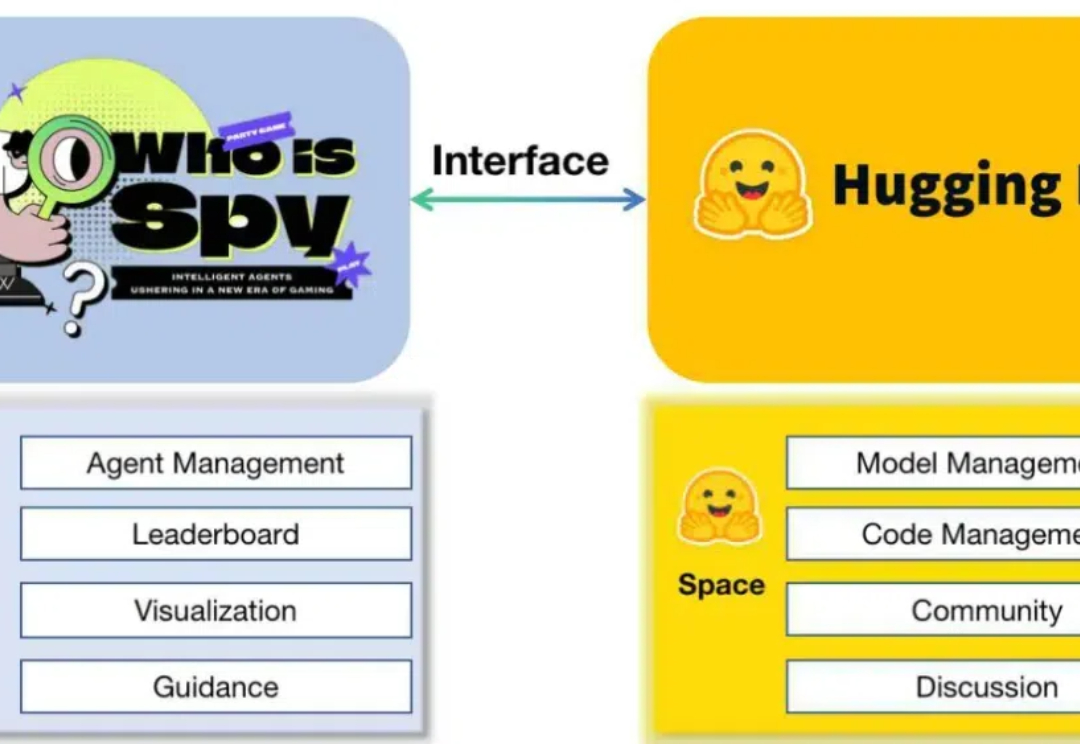

2024年,AI Agent称得上最火热的概念。一方面,大模型赛道降温,并呈现出赢家通吃的局面;另一方面,AI Agent则是大模型应用落地的最佳形式,其能够解决LLMs在具体应用场景中的局限性。

近年来,基于大型语言模型(LLMs)的多智能体系统(MAS)已成为人工智能领域的研究热点。

大语言模型(LLMs)通过更多的推理展现出了更强的能力和可靠性,从思维链提示发展到了 OpenAI-o1 这样具有较强推理能力的模型。