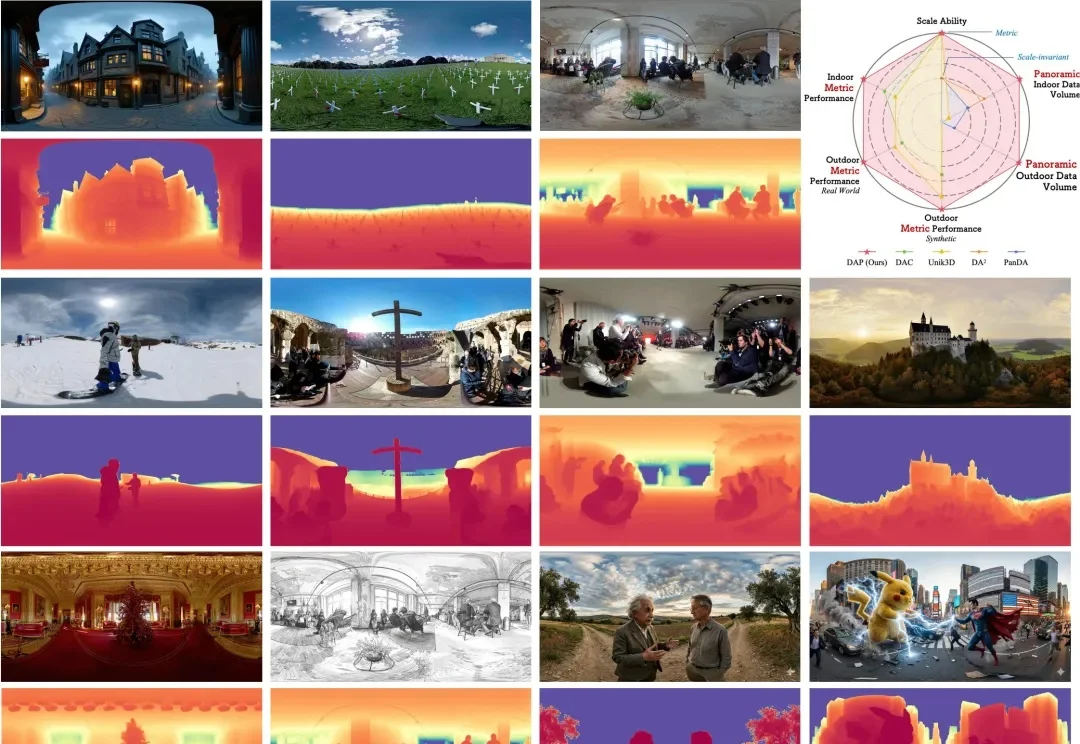

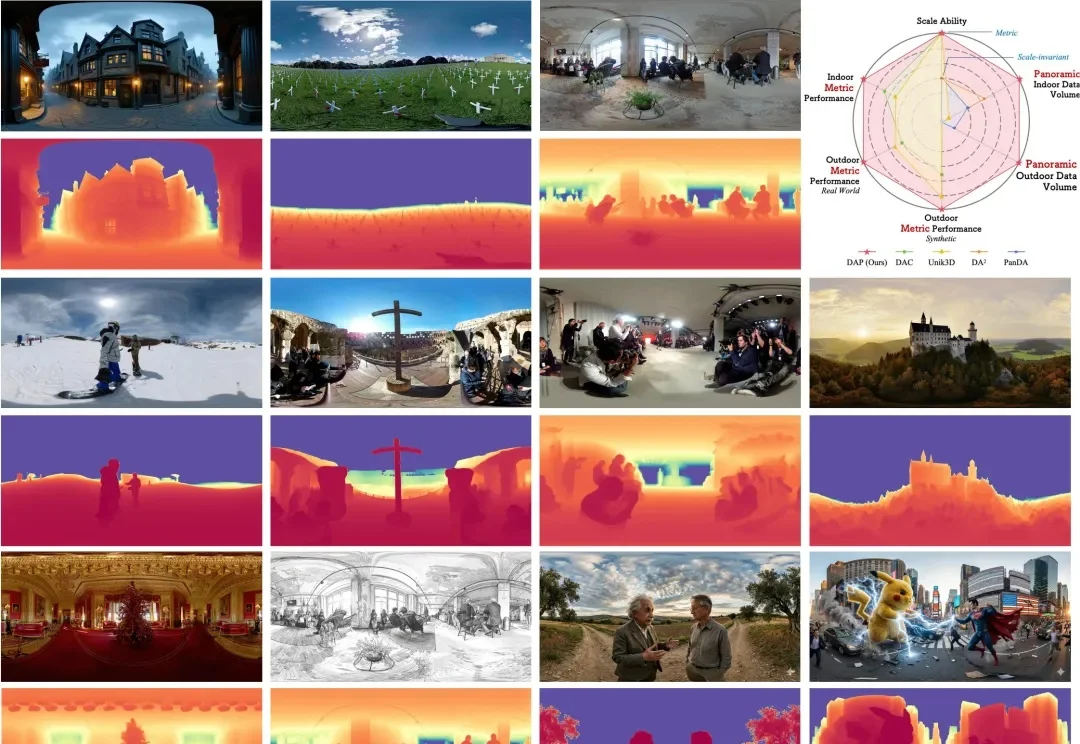

全景视觉的Depth Anything来了!Insta360推出DAP,200万数据打造全场景360°空间智能新高度

全景视觉的Depth Anything来了!Insta360推出DAP,200万数据打造全场景360°空间智能新高度在空间智能(Spatial Intelligence)飞速发展的今天,全景视角因其 360° 的环绕覆盖能力,成为了机器人导航、自动驾驶及虚拟现实的核心基石。然而,全景深度估计长期面临 “数据荒” 与 “模型泛化差” 的瓶颈。

在空间智能(Spatial Intelligence)飞速发展的今天,全景视角因其 360° 的环绕覆盖能力,成为了机器人导航、自动驾驶及虚拟现实的核心基石。然而,全景深度估计长期面临 “数据荒” 与 “模型泛化差” 的瓶颈。

继 SAM(Segment Anything Model)、SAM 3D 后,Meta 又有了新动作。

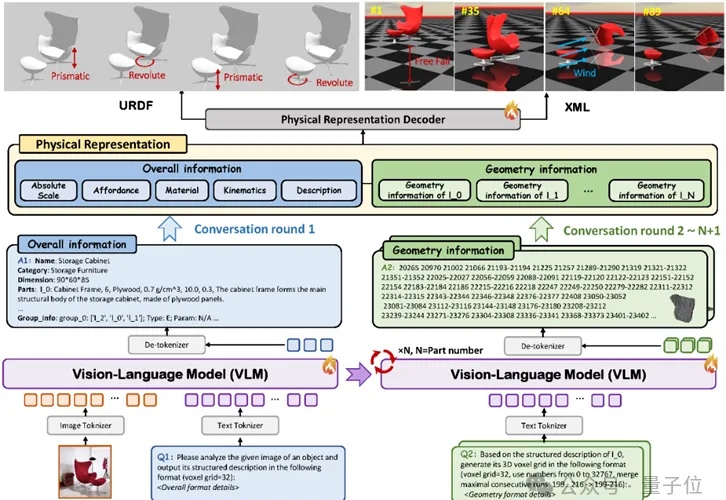

一张照片,就能生成可直接用于仿真的3D资产。

单Transformer搞定任意视图3D重建!

机器之心报道 编辑:泽南、杨文 现在,只需要一个简单的、用深度光线表示训练的 Transformer 就行了。 这项研究证明了,如今大多数 3D 视觉研究都存在过度设计的问题。 本周五,AI 社区最热

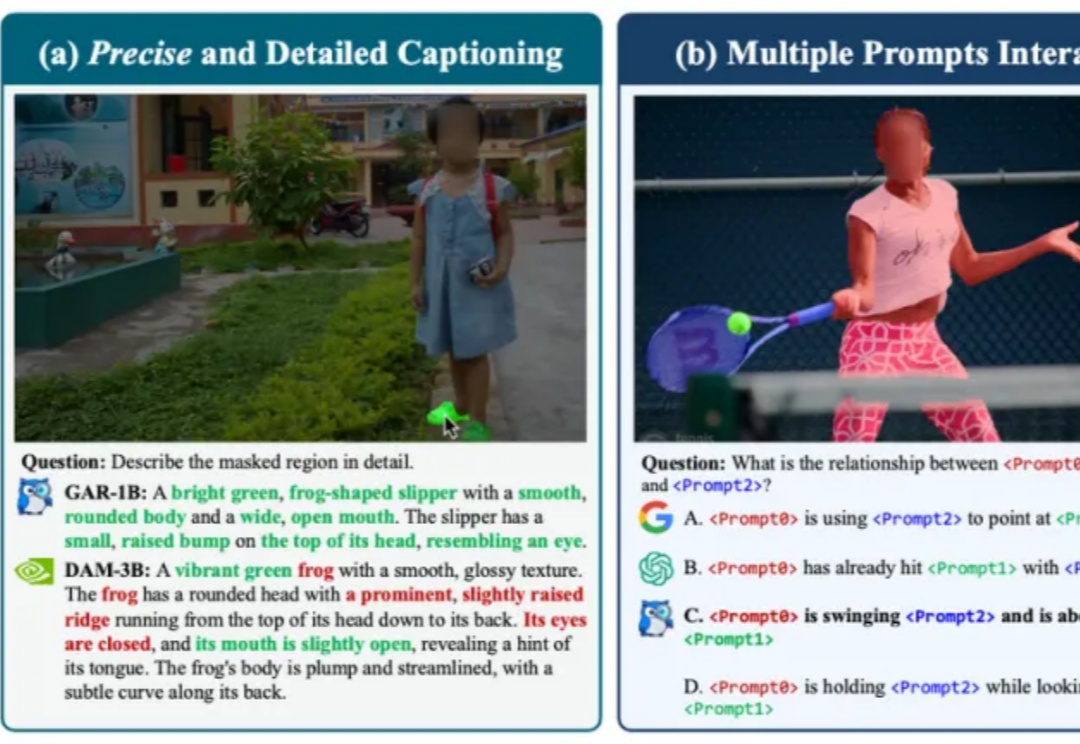

近期,DeepSeek-OCR提出了“Vision as Context Compression”的新思路,然而它主要研究的是通过模型的OCR能力,用图片压缩文档。

每隔一阵子,总有人宣告“RAG已死”:上下文越来越长、端到端多模态模型越来越强,好像不再需要检索与证据拼装。但真正落地到复杂文档与可溯源场景,你会发现死掉的只是“只切文本的旧RAG”。

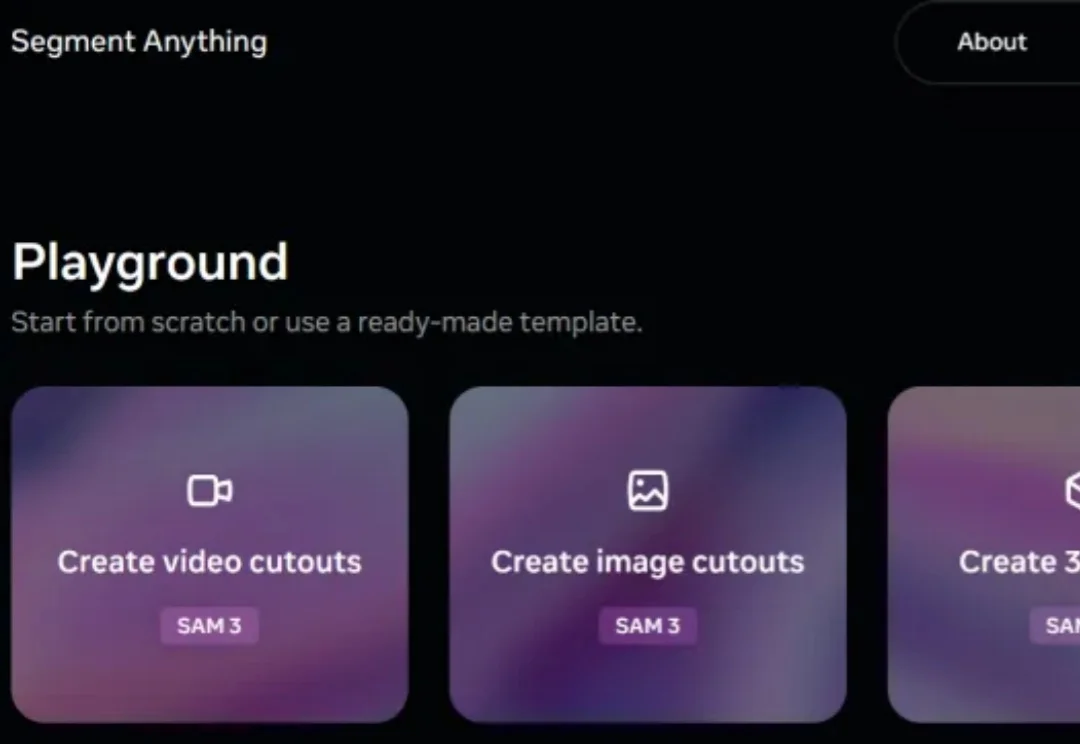

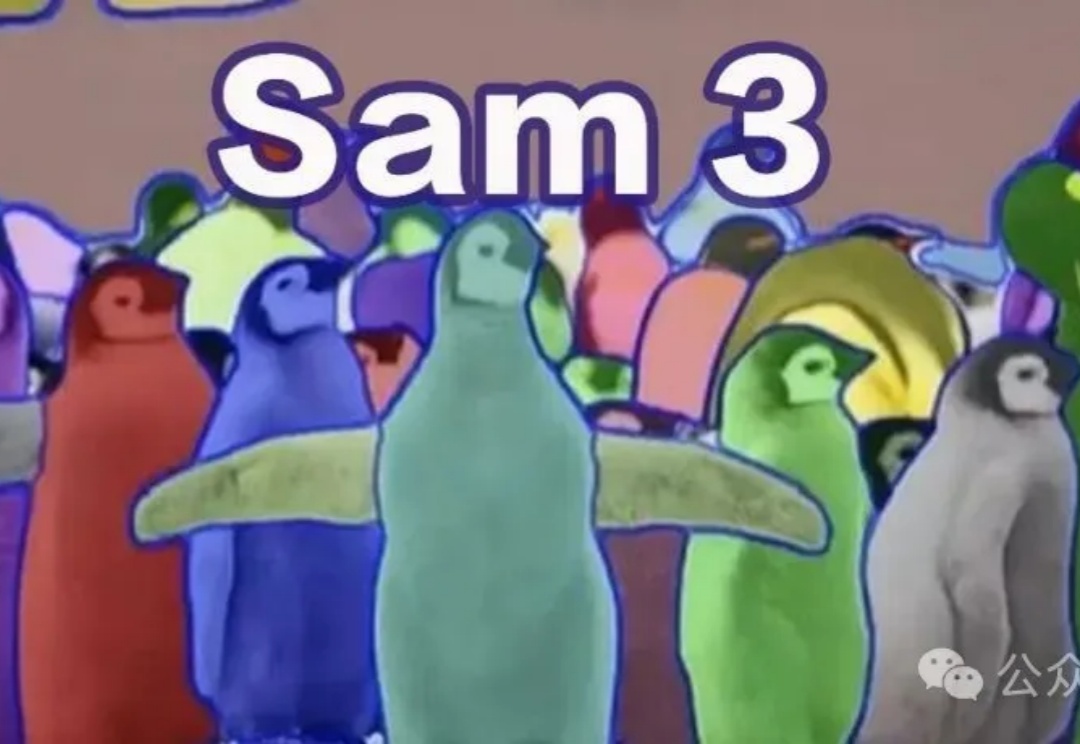

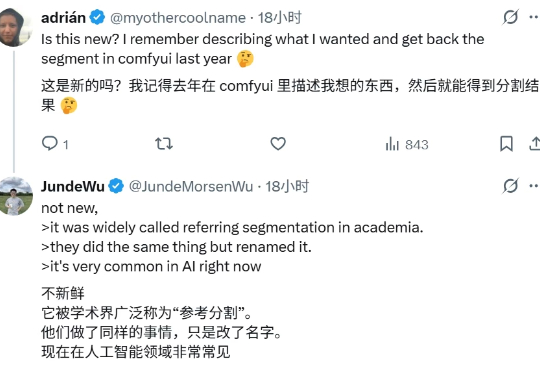

2023年Meta推出SAM,随后SAM 2扩展到视频分割,性能再度突破。近日,SAM 3悄悄现身ICLR 2026盲审论文,带来全新范式——「基于概念的分割」(Segment Anything with Concepts),这预示着视觉AI正从「看见」迈向真正的「理解」。

说出概念,SAM 3 就明白你在说什么,并在所有出现的位置精确描绘出边界。 Meta 的「分割一切」再上新? 9 月 12 日,一篇匿名论文「SAM 3: SEGMENT ANYTHING WITH CONCEPTS」登陆 ICLR 2026,引发网友广泛关注。

这不是科幻,这是 Anything 正在发生的真实故事。这家刚刚完成 1100 万美元融资、估值达到 1 亿美元的创业公司,在上线两周内就实现了 200 万美元的年度经常性收入。更让人震惊的是,他们的用户已经开始用这个平台做出真正赚钱的生意。我深入研究了这家公司后,发现他们不只是又一个 AI 编程工具,而是在彻底改变软件开发的游戏规则。