速递|Reddit创始人押注840万!Palabra攻克AI语音翻译“拟真实时”难题

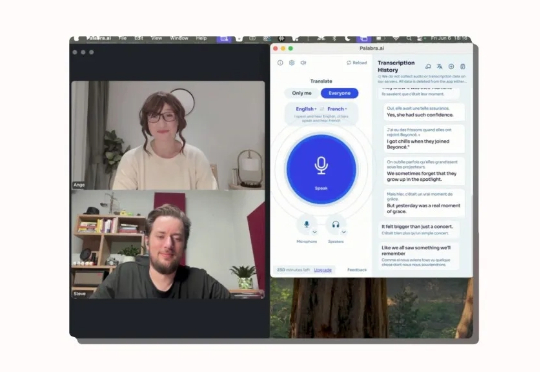

速递|Reddit创始人押注840万!Palabra攻克AI语音翻译“拟真实时”难题一家名为Palabra AI 的初创公司正在开发 AI 语音翻译引擎,致力于解决教学大型语言模型(LLMs)理解多种语言这一颇具挑战性的难题。

一家名为Palabra AI 的初创公司正在开发 AI 语音翻译引擎,致力于解决教学大型语言模型(LLMs)理解多种语言这一颇具挑战性的难题。

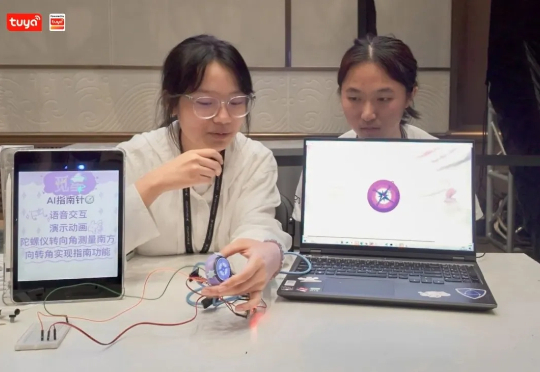

当大模型在代码世界封神时,一场硬件领域的新战役也在打响——如何让 AI 在物理世界「动手」。这场攻坚战的突破速度比预想快一些,Physical AI 的可行性轮廓已然变得更为清晰。

在生成式 AI 时代,全球数据总量正以惊人速度增长,据 IDC 预测,2025 年将突破 180ZB,其中 80% 为非结构化内容,传统数据分析在应对多模态信息和打破结构化数据技术壁垒方面尽显乏力,“人工找数 + 手动分析” 的模式严重抑制甚至沉没了数据价值。

网友在推特上爆料,一位Mistral离职女员工群发邮件,直指公司多项黑幕。其中最劲爆的就是:Mistral最新模型疑似直接蒸馏自DeepSeek,却对外包装成RL成功案例,并刻意歪曲基准测试结果。

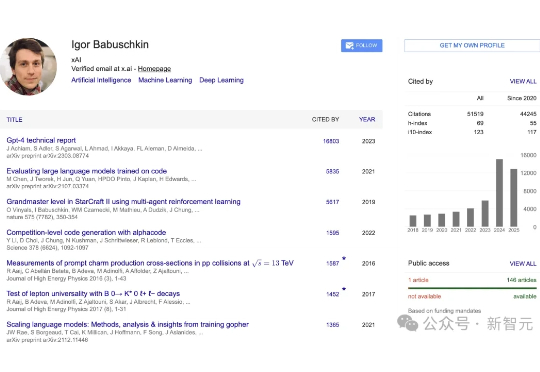

xAI又一位联创官宣离职了!AlphaStar之父Igor Babuschkin发长文告别,回忆曾带队爆肝120天造出全球最强超算,老马亲自下场致谢:没有你就没有xAI的今天。

以前创投圈有句名言,叫VC/PE的尽头是放贷。这背后的逻辑非常朴素:无论任何产业都需要金融支持,而贷款是最直接、最明码标价的金融工具;与此同时,贷款又是金融服务中最依赖人力、最陈旧、最碎片化的领域之一,目前大多数提供贷款的金融机构仍然依赖孤立的系统、耗费大量人力的流程以及被动的合规方法。

一面是Meta豪掷143亿美元下注Scale AI,一面是OpenAI紧急切断合作——当全球目光聚焦硅谷之时,一家藏身首尔的初创公司悄然撕开了AI安全市场的裂口。

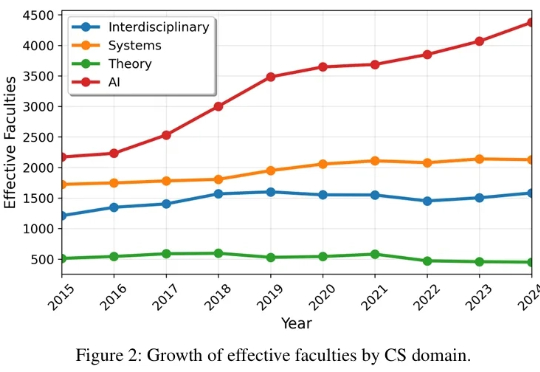

相信我们的读者都对 AI 顶会有非常大的关注和热情,有的读者最近可能刚从 NeurIPS rebuttal 脱身,又开始为下一篇做准备了。 作为推动技术革新与思想碰撞的核心引擎,顶级学术会议不仅是整个学界的生命线,更是我们洞察未来的前沿阵地。

战火升级!马斯克还在X上和奥特曼口水战,奥特曼反手就密谋支持一家脑机接口公司,与马斯克的Neuralink正面对决。这场关乎人类未来的科技战争,已经从AI蔓延到了你的大脑!

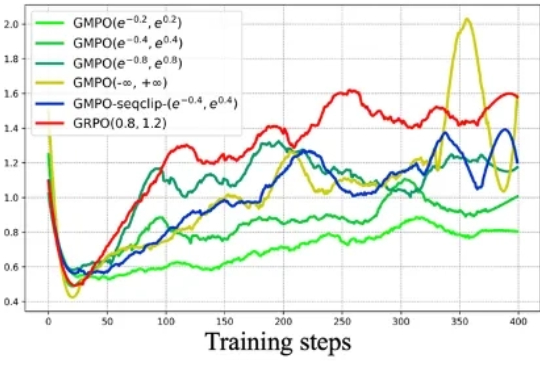

近年来,强化学习(RL)在大型语言模型(LLM)的微调过程中,尤其是在推理能力提升方面,取得了显著的成效。传统的强化学习方法,如近端策略优化(Proximal Policy Optimization,PPO)及其变种,包括组相对策略优化(Group Relative Policy Optimization,GRPO),在处理复杂推理任务时表现出了强大的潜力。