纽约时报:OpenAI或将在18个月内现金流枯竭

纽约时报:OpenAI或将在18个月内现金流枯竭2026 年危机逼近,OpenAI 虽创下 400 亿美元融资纪录,但内部预测 2028 年亏损将扩大至 450 亿美元。不同于有传统业务「输血」的科技巨头,独立 AI 公司受困于 Scaling Laws 带来的指数级成本爆炸。奥特曼的万亿豪赌或难以为继,OpenAI 恐面临被吞并结局,AI 泡沫时代即将硬着陆。

2026 年危机逼近,OpenAI 虽创下 400 亿美元融资纪录,但内部预测 2028 年亏损将扩大至 450 亿美元。不同于有传统业务「输血」的科技巨头,独立 AI 公司受困于 Scaling Laws 带来的指数级成本爆炸。奥特曼的万亿豪赌或难以为继,OpenAI 恐面临被吞并结局,AI 泡沫时代即将硬着陆。

OpenAI转身牵手AWS,苹果低头找谷歌续命,Meta开源翻车还内斗,马斯克直接把Macrohard挂上数据中心屋顶。2025年AI巨头们那些剪不断的纠葛。

在代码大模型(Code LLMs)的预训练中,行业内长期存在一种惯性思维,即把所有编程语言的代码都视为同质化的文本数据,主要关注数据总量的堆叠。然而,现代软件开发本质上是多语言混合的,不同语言的语法特性、语料规模和应用场景差异巨大。

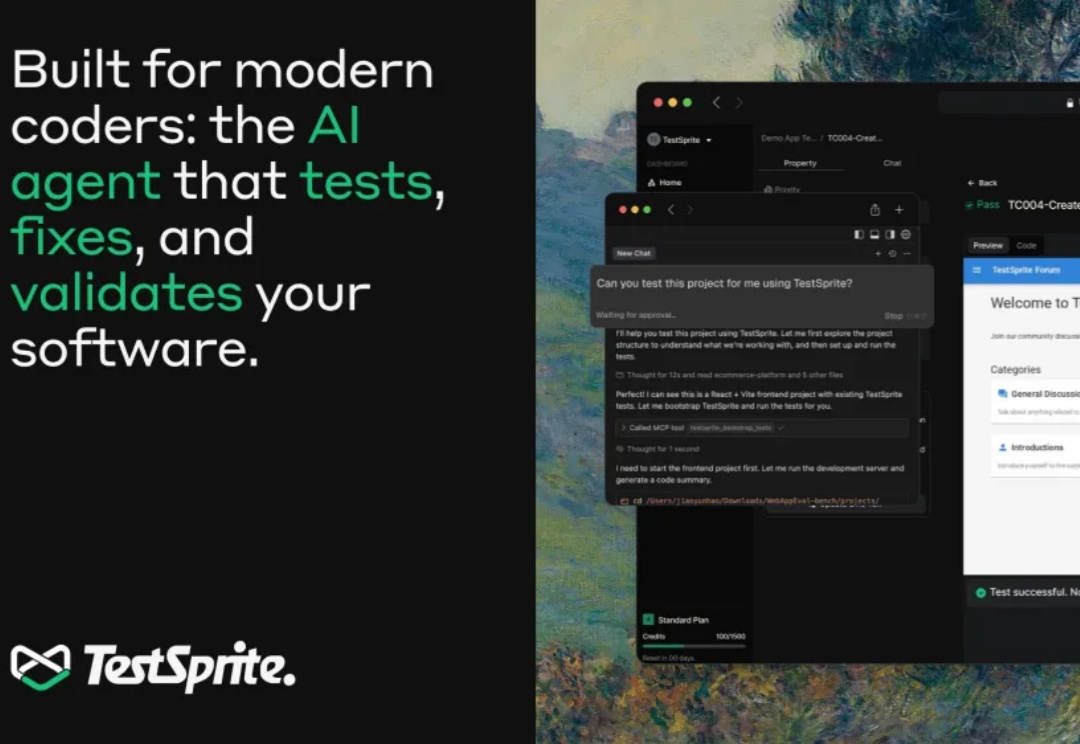

破天荒!这一次,硅谷难得没有在吵着“让AI取代程序员”。

在刚刚结束的“美国 AI 春晚” AWS re:Invent 2025 大会上,AI Agent(智能代理)的重要性被反复提及。

Perplexity 的首席执行官 Aravind Srinivas 曾直言不讳:“世上万物皆是套壳(Everything is a wrapper)。OpenAI 套的是英伟达的算力和 Azure 的云服务;Netflix 套的是 AWS 的基础设施;就连市值高达 3200 亿美元的 Salesforce,归根结底也不过是 Oracle 数据库的一个高级外壳。”你

这两年,写代码这件事变了。GitHub Copilot、Cursor、Devin 一路登场,工程师开始习惯“打一段话,几千行代码自己长出来”。写得出东西,变得前所未有地容易。但很快大家发现,真正拖住上线节奏的,不再是「能不能写出来」,而是「敢不敢放上生产环境」——代码量指数级增长,验证、回归、极端场景覆盖反而被彻底压缩,测试成了 AI 时代新的“硬瓶颈”。

就在今天,OpenAI 与 AWS 官宣建立多年的战略合作伙伴关系。OpenAI 将立即并持续获得 AWS 世界级的基础设施支持,以运行其先进的 AI 工作负载。 AWS 将向 OpenAI 提供配备数十万颗芯片的 Amazon EC2 UltraServers(计算服务器),并具备将计算规模扩展至数千万个 CPU 的能力,以支持其先进的生成式 AI 任务

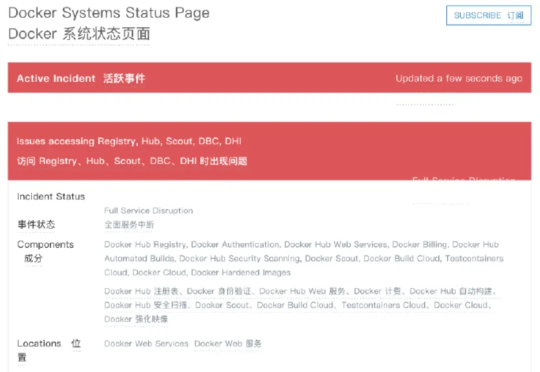

亚马逊一声咳嗽,半个互联网都地震了。 由于亚马逊AWS服务器宕机,大量互联网服务被迫中断,ChatGPT也被殃及。

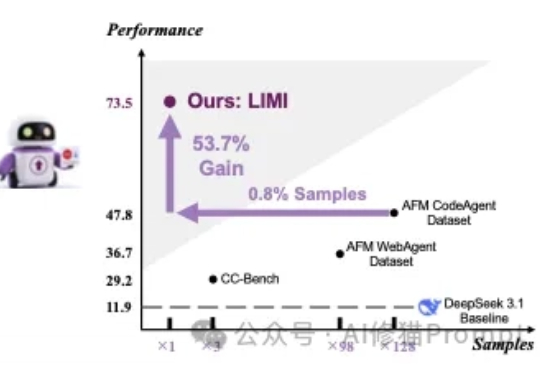

对于提升AI能主动发现问题、提出假设、调用工具并执行解决方案,在真实环境里闭环工作,而不只是在对话里“想”的智能体能力(Agency)。在这篇论文之前的传统方法认为,需要遵循传统语言模型的“规模法则”(Scaling Laws)才能实现,即投入更多的数据就能获得更好的性能。