168小时AI狂写300万行代码造出浏览器!Cursor公开数百个智能体自主协作方案

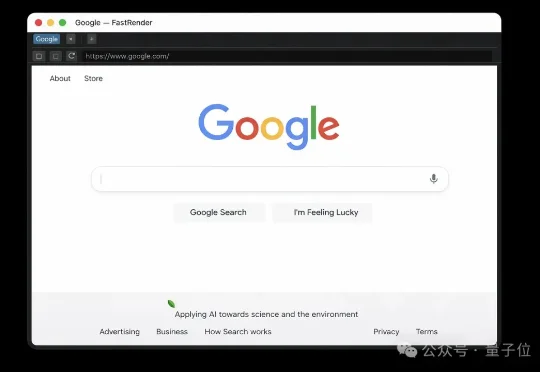

168小时AI狂写300万行代码造出浏览器!Cursor公开数百个智能体自主协作方案AI写代码,这次玩大了。 Cursor创始人宣布一项疯狂实验的结果:让数百个AI智能体连续跑了整整一周,从零开始,硬生生造出了一个可用的Web浏览器。项目代号FastRender,产出超过300万行代码,核心是一个用Rust从头写的渲染引擎,甚至还自带一个定制的JavaScript虚拟机。

AI写代码,这次玩大了。 Cursor创始人宣布一项疯狂实验的结果:让数百个AI智能体连续跑了整整一周,从零开始,硬生生造出了一个可用的Web浏览器。项目代号FastRender,产出超过300万行代码,核心是一个用Rust从头写的渲染引擎,甚至还自带一个定制的JavaScript虚拟机。

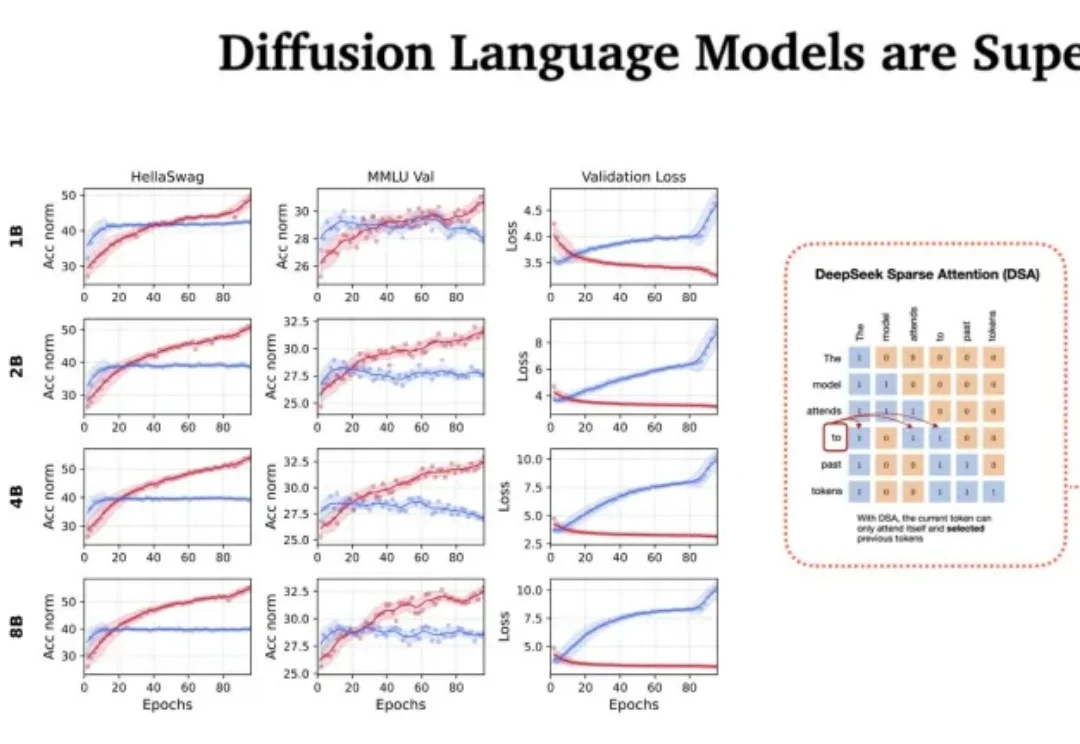

站在 2026 年的开端回望,LLM 的架构之争似乎进入了一个新的微妙阶段。过去几年,Transformer 架构以绝对的统治力横扫了人工智能领域,但随着算力成本的博弈和对推理效率的极致追求,挑战者们从未停止过脚步。

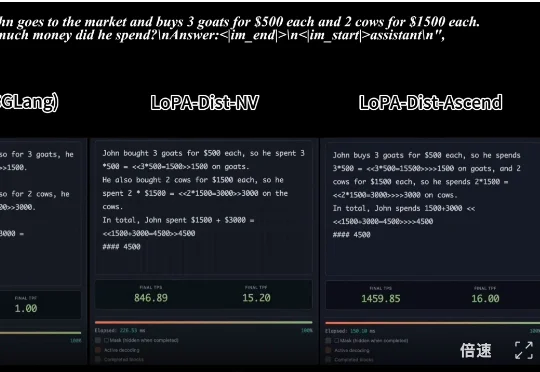

,时长 00:20 视频 1:单样例推理速度对比:SGLang 部署的 Qwen3-8B (NVIDIA) vs. LoPA-Dist 部署 (NVIDIA & Ascend)(注:NVIDIA 平台

近日,来自 Meta、香港科技大学、索邦大学、纽约大学的一个联合团队基于 JEPA 打造了一个视觉-语言模型:VL-JEPA。据作者 Pascale Fung 介绍,VL-JEPA 是第一个基于联合嵌入预测架构,能够实时执行通用领域视觉-语言任务的非生成模型。

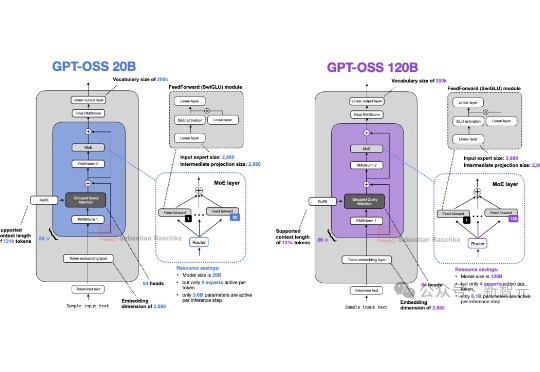

12 月 1 日,DeepSeek 一口气发布了两款新模型:DeepSeek-V3.2 和 DeepSeek-V3.2-Speciale。几天过去,热度依旧不减,解读其技术报告的博客也正在不断涌现。知名 AI 研究者和博主 Sebastian Raschka 发布这篇深度博客尤其值得一读,其详细梳理了 DeepSeek V3 到 V3.2 的进化历程。

甲骨文于上周发布全球最大云端AI超级计算机「OCI Zettascale10」,由80万块NVIDIA GPU组成,峰值算力高达16 ZettaFLOPS,成为OpenAI「星际之门」集群的算力核心。其独创Acceleron RoCE网络实现GPU间高效互联,显著提升性能与能效。该系统象征甲骨文在AI基础设施竞争中的强势布局。

他曾是Ilya的亲信,因揭露OpenAI安全隐患被解雇,却在短短6个月内以47%回报打造出管理规模15亿美元的基金。作为AI安全激进派,他在165页论文《Situational Awareness》中预测2027年将迎来AGI,并呼吁建立「AI版曼哈顿计划」。

你有没有想过,一家小企业想要贷款时,为什么总是被迫在两个极端选择之间挣扎?要么选择社区银行的低利率,但要忍受漫长的审批流程和落后的数字化体验;要么转向在线放贷平台的快速审批,却要承受高达60%的年化利率。这种看似无解的困境,正在被一家名为Casca的创业公司彻底颠覆。

自GPT-2以来,大模型的整体架构虽然未有大的变化,但从未停止演化的脚步。借OpenAI开源gpt-oss(120B/20B),Sebastian Raschka博士将我们带回硬核拆机现场,回溯了从GPT-2到gpt-oss的大模型演进之路,并将gpt-oss与Qwen3进行了详细对比。

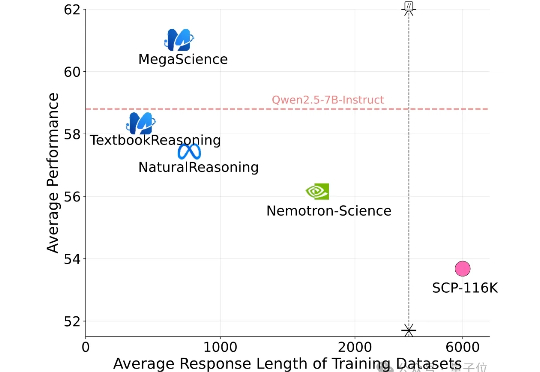

有史规模最大的开源科学推理后训练数据集来了! 上海创智学院、上海交通大学(GAIR Lab)发布MegaScience。该数据集包含约125万条问答对及其参考答案,广泛覆盖生物学、化学、计算机科学、经济学、数学、医学、物理学等多个学科领域,旨在为通用人工智能系统的科学推理能力训练与评估提供坚实的数据。