谷歌「香蕉」手写满分卷,Karpathy玩上瘾!ChatGPT跪验沉默

谷歌「香蕉」手写满分卷,Karpathy玩上瘾!ChatGPT跪验沉默谷歌Nano Banana Pro出世,又成为一个现象级爆款。这届网友彻底玩疯:手写试卷全对、秒出神级信息图、电影级分镜、跨世纪变装.....

谷歌Nano Banana Pro出世,又成为一个现象级爆款。这届网友彻底玩疯:手写试卷全对、秒出神级信息图、电影级分镜、跨世纪变装.....

“这个世界上或许不需要再多一个能帮你生成报告和PPT的工具,但需要一个真正关心你生活的存在”。Macaron AI创始人&CEO陈锴杰说道。

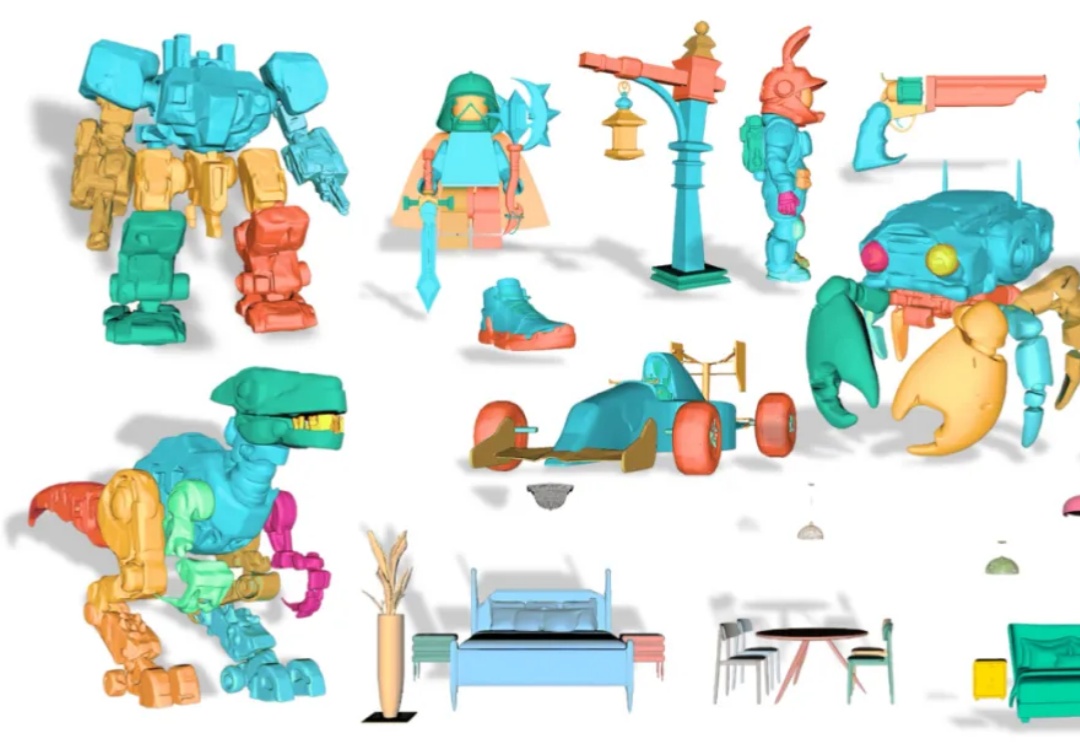

从单张图像创建可编辑的 3D 模型是计算机图形学领域的一大挑战。传统的 3D 生成模型多产出整体式的「黑箱」资产,使得对个别部件进行精细调整几乎成为不可能。

对于硬件,对于AR,应该都不甚了解的某知名投资人朱啸虎,对自己出手的第一个AI硬件也是AI眼镜项目是如此评价:“Gyges Labs的DigiWindow技术相比其他等方案,有着一个非常重要的优势:它的显示模组隐形,能把内容投到眼睛,

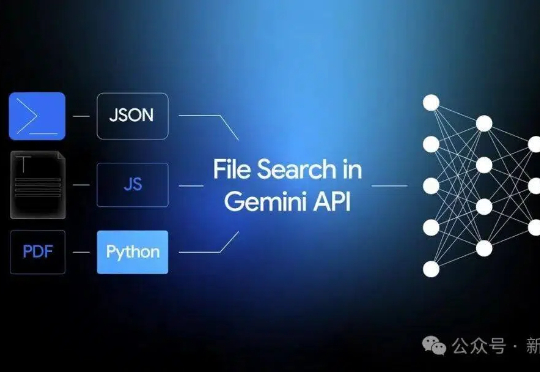

Google宣判RAG死刑!那条曾让无数工程师自豪的技术链,如今只剩下一行API调用。Gemini的File Search,把检索、分块、索引、引用,全都封进了模型内部。开发者不再需要理解流程,只需要上传文件。当智能被自动化吞并,工程师第一次发现,自己也成了被自动化的一部分。

美国加州大学圣地亚哥分校(UCSD)徐升教授对 DeepTech 表示:“很荣幸我们的工作成为 Nature Sensors 期刊的首篇论文,我们第一次通过 AI 的方法实现了在动态下抗运动伪影的人机交互,应用场景包括可穿戴和移动设备的手势控制、机器人遥操作、AR/VR 动作追踪、游戏、康复与辅助设备、工业与军事训练、健康与运动监测、

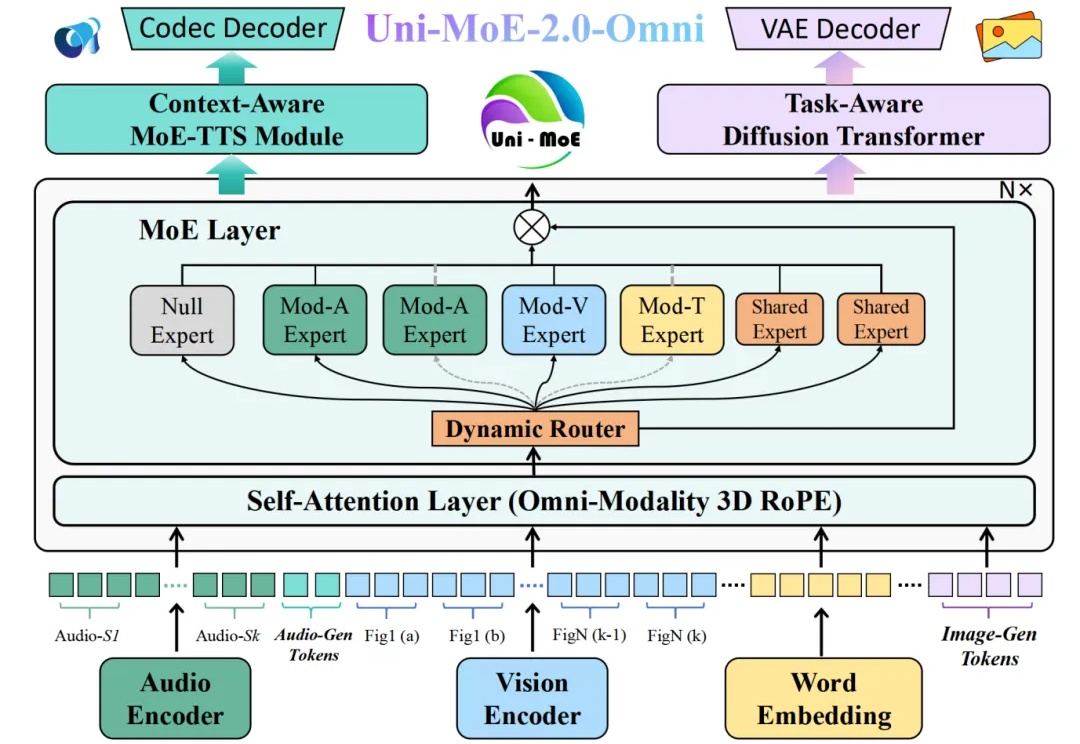

全模态大模型(Omnimodal Large Models, OLMs)能够理解、生成、处理并关联真实世界多种数据类型,从而实现更丰富的理解以及与复杂世界的深度交互。人工智能向全模态大模型的演进,标志着其从「专才」走向「通才」,从「工具」走向「伙伴」的关键点。

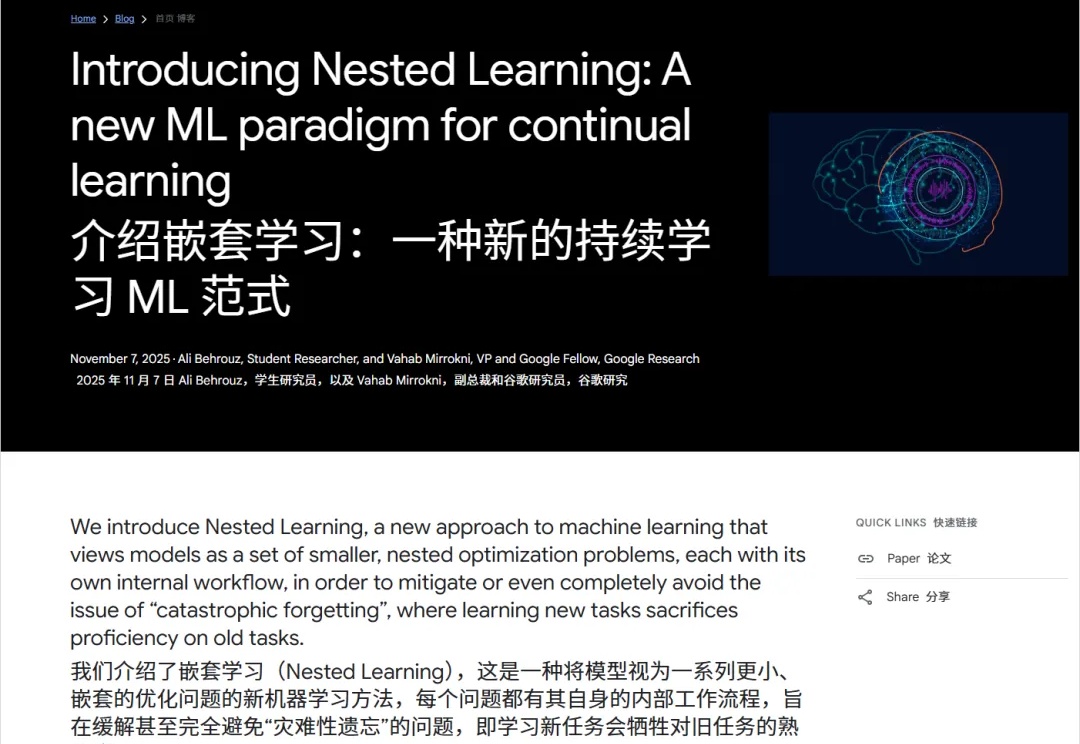

前两天,Google发了一个非常有趣的论文: 《Nested Learning: The Illusion of Deep Learning Architectures》

两个AI顶流终于是碰到了一起,这回设计师们真要慌了但也可能是大意过望了—— 因为Lovart,这个顶流设计师Agent,现在已经正式接入Nano Banana Pro了!

前天晚上谷歌推出了基于 Gemini 3 优化后的 Nano Banana Pro 模型,能力大幅提升,而且解决了多语言问题。