清华紧逼谷歌,AI顶会NeurIPS论文数第二!中国占半壁江山

清华紧逼谷歌,AI顶会NeurIPS论文数第二!中国占半壁江山NeurIPS 2025见证了历史性的分流:清华大学以微弱差距逼近谷歌,中国AI完成了从数量堆叠向底层架构创新的「质变」突围。在圣地亚哥与墨西哥城的双会场之间,签证壁垒切割了物理空间。这是一场关于算力、人才与技术定义权的「双城记」。

NeurIPS 2025见证了历史性的分流:清华大学以微弱差距逼近谷歌,中国AI完成了从数量堆叠向底层架构创新的「质变」突围。在圣地亚哥与墨西哥城的双会场之间,签证壁垒切割了物理空间。这是一场关于算力、人才与技术定义权的「双城记」。

这届 ICLR 的烦心事还没有结束。

ICLR 2026,居然有21%的评审是纯纯由AI生成的?!

而今天,来自 UIUC、华盛顿大学等机构的一群研究人员,通过一篇重磅论文《推理的认知基础及其在大型语言模型中的体现》,为这个“认知鸿沟”画出了一张精确的微观解剖图。

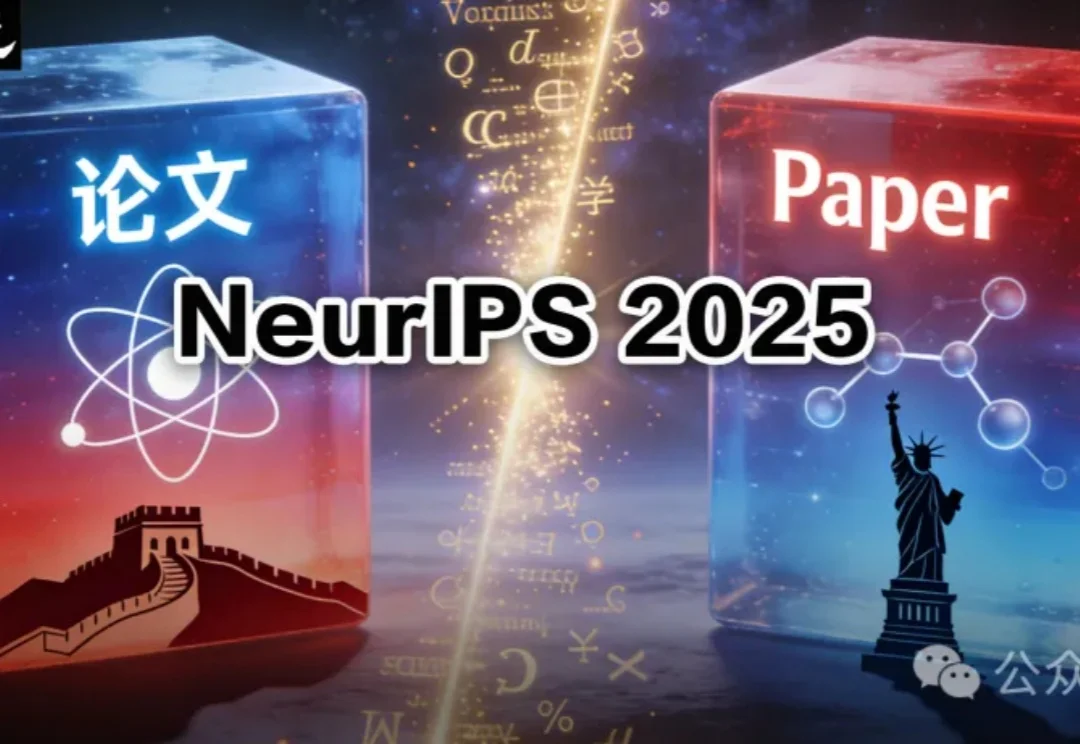

大无语事件天天有,今天特别多——AI大模型公司阶跃星辰的研究员,自曝被苹果挂在arXiv上的论文,狠狠坑了一把。自己去反馈问题,对方简单回了两句就把issue关了;直到自己留下公开评论,对方才撤稿下架代码了。

今天,NeurIPS 2025最佳论文出炉!4篇最佳论文,华人占多半,何恺明孙剑等人曾提出的Faster R-CNN获「时间检验奖」,实至名归。

刚刚,NeurIPS 2025最佳论文奖、时间检验奖出炉!

AMiner 团队依托十余年学术数据挖掘经验,推出的“AMiner 亮点”功能,以其底层创新的作者消歧技术和全方位的学术服务能力,为学者提供了高效解决方案。 本文将从技术原理与产品实践双维度,深度解析“AMiner 亮点”在传统学术成果整理上的突破。

科研人不容易。3年投稿6次全被拒,每次等反馈要半年??机器学习大佬吴恩达听说这位学生的“水逆”遭遇后,亲手搓了个免费的AI论文评审智能体出来。通过在ICLR 2025审稿数据上训练系统,并在测试集中对比发现,该AI审稿系统与人类审稿的相关系数达0.42,和人与人审稿间的0.41相近甚至还高一点。

他是站在诺奖得主身侧的MIT天之骄子,用一篇完美契合时代痛点的AI论文愚弄了国会与顶级期刊,却最终败给了跨学科的常识。这不仅是一场关于数据造假的惊天丑闻,更是一次对学术圈盲目追逐风口、迷信权威与跨界盲区的残酷祛魅。当才华被野心吞噬,他编织的谎言虽然构建了一个严丝合缝的「完美世界」,却在现实的审视下瞬间化为泡影。