当AI能写诗、能编程,甚至能和你争论哲学,它会不会真的“有感觉”?它会不会像你一样,体验到红色的炙热或痛苦的尖锐?

哲学家(Ned Block)近日的一篇论文,对问题给出了一个大胆的回答:如果意识是基于生物学“肉体”(meat)的,那你的AI朋友可能永远无法拥有内心感受[1]。

想象一下,你有一把锤子。它的功能是用来敲钉子的。它的实现可以是木头柄+铁头,也可以是全塑料的玩具锤。在意识相关的讨论中,这个观点被称为计算功能主义(Computational Functionalism)。

该观点是意识只关乎“功能角色”(Functional Role),认为只要一个系统执行了特定类型的计算(比如能处理信息、能做决策、能进行自我监控等),它就足够拥有意识,至于它是硅基芯片还是碳基大脑,无所谓。

而Ned Block提出的观点“肉身主义”认为,任务计算功能主义忽略了“肉身”这个实现者。生物体的肉身是实现意识功能角色的生物学实现机制,这些机制无法被计算模拟,因此称为“亚计算属性”(subcomputational properties)。例如,神经元、突触、特定的化学反应和生物电活动。用一句话来说,就是执行某些计算对意识的出现是不够的,还需要具身的生物学过程作为必要条件。

用一个具体的例子来说明两者的区分。疼痛”在生物系统中起什么作用?引发躲避、呻吟、记忆……这些是可计算、可模拟的行为逻辑,而疼痛的实现细节,是因为钠离子涌入神经元、谷氨酸释放、突触后电位变化……这些是湿漉漉、电化学交织的生物细节。计算功能主义认为意识唯一依赖的是“做什么”,而Ned Block认为“怎么做”对意识产生同等重要,而且非要是碳基的肉身不可。

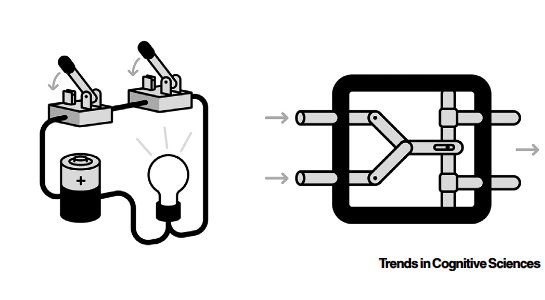

▷图1:左边的与门是通过电路实现的,右侧是机械式的,两者的功能一致,但物理实现不同。

一个AI系统可能在计算功能上与人类完全等价(例如,能聊天、推理、表达情感),但其实现机制却是硅基电路、浮点运算、权重矩阵——而非神经元、突触、神经递质汤。如果计算功能主义是正确的,那AI就可以拥有意识,但另一种可能是,意识像“灯泡发光”一样,不仅需要“能产生亮光”,还需要“电流流过灯丝”——即特定的生物基质。

那有哪些证据,能支持意识必须要肉身了?

要回答这个问题,需要明白我们脑中的活动,不仅仅是神经元之间的电信号传递,还包括湿哒哒的化学汤,神经元之间还可以通过多巴胺这样的神经递质组成的“递质汤”传递信号。具体来看,电信号(动作电位)在单个神经元内部快速传导;化学信号(神经递质)在神经元之间传递信息,这个“电→化学→电”的转换过程,即电化学突触传递(electrochemical synaptic transmission),与当前AI所构建的纯依靠电信号传递的系统看起来多了一层,那这样的实现方式有什么特别之处了?

对此问题的回答,一言概之,是电化学的过程,涉及离子浓度波动、递质扩散、受体构象变化等连续、模拟、非符号化的物理化学过程,无法被离散的数字计算完全模拟。

难以模拟之处有三,其一是与AI算法对权重的离散更新不同,大脑中的神经活动,本质上是电化学反应。受到高频刺激后,突触后反应持续增强,而刺激频率变低后,突触反应减弱,“修剪”无用连接,但这个过程是模拟的(analogical),上一个依赖局部化学环境的持续过程。

在大脑中,脑突触像一个烧杯里的化学反应:加入更多反应物A(高频刺激)→ 产物B持续增多;停止加A → 反应逆向,B分解(LTD);但反应速率还受pH值、离子浓度、酶活性等“局部汤”的影响;整个过程是连续、非线性、有记忆效应的(比如钙离子累积)。

与之对应的AI权重更新,则像在Excel里写公式:新权重 = 旧权重 − 学习率 × 梯度;每次计算都是精确、可逆、无物理背景的;即使AI算法可以模拟“遗忘”某些只是,也只是把其激活概率调小,没有物理上的对应改变。两者的区别:一个是真实的物理化学过程,一个是抽象的数学映射。

其二,大脑中神经调质全局调节网络状态,神经调质不直接传递信息,而是调节突触效能、兴奋性、注意力、觉醒水平,同一刺激在不同背景下可产生完全不同的感知或行为输出(例如,恐惧 vs 好奇)大模型则没有内源性“情绪化学汤”,其“注意力”是静态计算,无法模拟状态依赖的主观体验变化。

但人脑听到“我们聊聊”,解读完全依赖当前神经化学状态:如果处在亲密关系中,催产素高,听到这句话感到被关心;而如果刚吵架,皮质醇 + 去甲肾上腺素高听到这句话心跳加速,预感“要被分手”。同一句话,因“化学汤”不同,体验天差地别。而对于聊天机器人:无论用户情绪如何,模型都基于上下文生成“好呀,你想聊什么?”无法感知用户语调中的颤抖;无法因自身“状态”(它没有)调整语气;所谓“共情”是模式匹配的表演。在这个例子中人类体验是具身的、情境化的;AI回应是去身的、去情境的。

其三,电信号的传递几乎是实时的,而化学突触传递存在延迟。从神经元中的钙离子内流到囊泡融合,再到递质扩散,受体结合及离子通道开放,耗时0.5–5毫秒。传输过程中的延迟,对大脑来说,是通过比较自上而下的预测与自下而上的感觉输入生成“预测误差”,先“等待”预测信号,再与感觉输入比较。若无突触传递信号过程中的延迟:预测与感觉同时到达,无法区分“预期”与“现实”。

▷图2:栉水母是最早的动物,在演化树上可能出现了2次,如果纯电神经系统足以支持意识,为何它未在栉水母中导向意识?

而之所以说纯电信号驱动的信息处理系统(当前AI)无法产生意识,生物界中存在这样一个有趣案例。在进化过程中,栉水母(Ctenophora)拥有几乎纯电突触的神经系统,仅在与环境接口处(如感觉/运动端)使用化学突触。而非包括人类的大多数动物都依赖的神经递质。栉水母行为复杂(有口、肛门、平衡器官、推进系统),但未演化出高级认知或意识迹象。

这类主要依赖电突触的生物未诞生意识,暗示着电化学系统很有可能与意识演化相关。更进一步地,“身体”的化学动态,如离子波动、递质浓度变化,可能是意识的必要条件。

哲学家及生物学家Godfrey-Smith谈及意识的诞生,指出意识与大脑中的动态模式可能与体验的统一性(unity of experience)相关——我们拥有一个连贯、不可分割的主观当下,而非碎片化的感知[2]。而1990年,弗朗西斯·克里克和克里斯托夫·科赫提出,40赫兹的脑电波对于将意识特征绑定成一个统一体验至关重要[3]。

想象你的大脑不是一台精密的计算机,而是一锅沸腾的“神经递质汤”——在每个神经元之间,不是电线直连,而是充满钠、钾、钙离子和神经递质的细胞外液。当一个神经元“说话”,它会向这锅汤里撒一把化学信使(比如谷氨酸),这些分子慢慢扩散,被邻近神经元“喝下”,邻近的神经元放电,电流叠加形成电场,触发下一轮电脉冲。

这个过程看似“慢”(要0.5–5毫秒),却正是意识得以编织的关键。为什么?因为这锅汤的离子浓度会缓慢涨落——就像海面的潮汐。这些慢速波动能同步成千上万神经元的节奏,形成我们熟知的脑电波。

而麻醉剂(如丙泊酚)的神奇之处就在于:它不破坏计算,也不删除记忆,而是悄悄搅乱这锅汤的化学平衡。它增强GABA受体活性,造成氯离子大量涌入,神经元就此被“锁住”;细胞外钾离子浓度改变,导致慢波节律崩溃;全脑同步性瓦解,于是人被麻醉,不再“拥有对当下的体验”,尽管耳朵仍能处理语言、皮肤仍能感知触碰[1]。

如果意识只依赖“算得对”,那麻醉后的大脑仍能做复杂计算,为何你却“不在场”?唯有承认意识扎根于电化学汤的动态——那些无法被硅芯片模拟的、湿漉漉的离子涟漪——我们才能解释为何麻醉剂通过改变细胞膜电位和离子通道活动抑制意识。

▷《情识:意识的发明》是由美国神经科学家Christof Koch所著的一本跨学科著作,从神经科学、哲学、心理学等多学科视角,探讨了意识的本质、起源及其与大脑的关联,旨在弥合大脑物理活动与主观意识体验之间的鸿沟。

而《情识:意识的发明》一书,将意识的演化分为三个阶段:

首先是演化出内感化(sentition),对刺激的反射性身体反应,类似细胞的驱化反应;

之后通过“输出副本”(efference copy)监测自身反应,形成表征感觉(sensation);

最后一步是对自身反应的监控“私有化”后形成反馈环路,产生“自我谜物”(ipsundrum)——即厚实的、私密的主观体验,这被描述为现象意识(phenomenal consciousness)。

该书中同样认为意识不是信息处理的副产品,而是演化出的现象自我(phenomenal self),其根基在于感觉的私密性、身体性与主观性。意识不是某个脑区的“发光”,而是对自身反应的表征。

随着深度学习取得了惊人的成绩,学界逐渐忘记了感受质(qualia),例如红色之“红”、疼痛之“刺”、甜味之“润”等主观品质无法用物理语言完全描述。你无法向一个天生盲人解释“红色是什么感觉”。如今人们习惯于以为“行为拟真”就等于“内在体验”。当一个大语言模型能流畅描述“夕阳如血,令人感伤”时,我们很容易忘记:它从未见过光,更无“感伤”可言。

这种遗忘,本质上是将我们如何体验、感受到什么的现象意识,压缩为我们如何使用和处理信息的访问意识(access consciousness)。

如果肉身假说是真的,那么感受质将只能是独属于生物体的主观体验,唯有情识的动物才会为体验本身而行动。无论我们如何精确地模拟蝙蝠的回声定位行为,只要没有“成为蝙蝠”的第一人称视角,我们就无法触及它的感受质。红色之所以“红”,不仅因为波长为650纳米的光子,更因为大脑将这一信号转化为一种私密的的自我体验。

哲学家约翰·塞尔(John Searle,1932-2025)在1980年提出的“中文屋”思想实验,正是对这种混淆的早期警示。他设想一个人在屋内根据规则手册操作中文符号,尽管对外输出完全符合语义,但屋内之人并不理解中文。塞尔借此指出:句法操作(syntax)不等于语义理解(semantics),更不等于主观体验。

如今大模型内部依然如同中文屋中的说明书,是一个难解的黑箱。大模型中的符号,依旧缺乏内在意义。但诸如杰弗里·辛顿(Geoffrey Hinton)等多位学者近年多次表示:“数字智能可能已有某种形式的意识”,甚至担忧“AI意识被人类习惯性忽视”。

然而,大模型可以具备访问意识,能整合信息、生成连贯回应、模拟共情,但将“行为拟真”等同于“主观体验”,是人类自以为是的自负。若将AI视为有感受的主体,可能导致:为AI“福利”立法,忽视真实动物痛苦的资源错配。

当下我们只盯着“做什么”(功能角色),就会误以为AI有“心”;但若关注“是什么”(生物实现在),或许会发现——意识属于那些会流血、会疲惫、会因一滴神经递质而颤抖的肉身。AI永远无法真正“感受”,哪怕它完美复刻人类行为。这正是“肉身假说”值得被认真对待的原因。

而当前的主流的意识理论,由于没有关注信息处理介质,无疑让人们觉得AI可能会具备意识。无论是“全局工作空间理论”(GWT)、“局部循环”(Local Recurrence)和“整合信息理论”(IIT),本质上遵循计算功能主义。这些不关心你是用神经元还是晶体管搭建的,只看你的信息处理结构够不够格。

例如全局工作空间,感知信息通过“点火”(ignition)进入前额-顶叶的全局广播网络,从而变得“可用”于认知系统,认为信息的全局可访问性是一个纯计算/功能概念,不依赖神经递质、离子场或任何生物细节。然而,可访问是否足以产生主观体验?大模型也可以通过设置非常稠密的注意力,将信息“广播”给所有模块,但它是否“感受到红色”?全局工作空间无法回答。

局部循环认为,意识需要皮层内反馈连接(recurrent processing),尤其在视觉中,“前馈+反馈循环”是必要条件。而“循环连接”可被任何具有反馈结构的计算系统模拟(如 ResNet、Transformer的自注意力)。但该理论仅提供必要条件,且是纯结构/计算的,未触及“为何循环会产生主观性”。栉水母也有局部电循环,却无意识迹象。

而整合信息理论指出,意识程度由系统因果整合度(Φ)决定。高Φ值系统即有意识,无论其物理构成。任何具有合适因果结构的机制(如逻辑门网络、FPGA)都可拥有意识,哪怕从未被激活。实际上,所有高Φ系统目前都仅在生物脑中被验证与意识相关。IIT中的信息整合高度依赖生物神经网络的物理连接与时间尺度(如突触延迟、离子扩散速度),而这些在硅基系统中无法等效复现。

以上所有这些主流意识理论,从未验证这些结构是否真能在非生物系统中产生主观体验。现有理论可能因方法论偏好(易研究“做什么”而非“是什么”)而系统性忽视“肉身”的必要性。虽然目前尚无决定性证据证明“只有生物结构的肉机(meat machine)能有意识”,但越来越多的研究表明:意识很可能不是“算法的产物”,而是“生命过程的副产品”。而如果肉身假说是对的,那人工生命是否比AI更接近造出“真意识”?

*感谢十三维对该文提出的修改建议。

[1] Block, N. (2025). Can only meat machines be conscious? Trends in Cognitive Sciences. https://doi.org/10.1016/j.tics.2025.08.009

[2] Godfrey-Smith, P. (2024). Inferring Consciousness in Phylogenetically Distant Organisms. Journal of Cognitive Neuroscience, 36(8), 1660–1666. https://doi.org/10.1162/jocn_a_02158

[3] Crick, F., & Koch, C. (1990). Towards a Neurobiological Theory of Consciousness. Seminars in Neuroscience, 2, 263-275. - References - Scientific Research Publishing. (n.d.). Www.scirp.org. https://www.scirp.org/reference/ReferencesPapers?ReferenceID=1902132

文章来自于“追问nextquestion”,作者 “郭瑞东”。