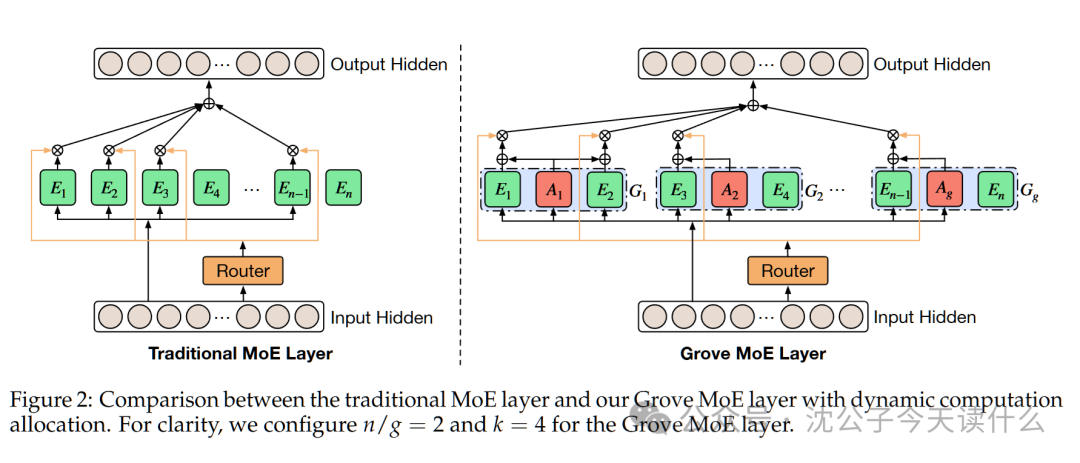

❝一句话概括,传统MoE就像公司派固定人数团队,Grove MoE则像智能调度系统,小项目派少数人,大项目集中火力,效率与效果兼得。(原论文题目见文末,点击阅读原文可直接跳转至原文链接,Published on arXiv on 11 Aug 25, by Inclusion AI, The Chinese University of Hong Kong, Zhejiang University)

亲爱的读者们,沈公子的公众号agent🤖和base model训练升级到v3.0,今后公众号文章行文会更流畅,处理公式和符号也完全达到人类专家水准,会大幅减少出现错乱和显示异常的情况,提升阅读体验。enjoying :)

当前,混合专家(MoE)模型是构建超大规模语言模型(如GPT-4、Llama 4)的主流技术。它的核心思想是“人多力量大,但不用所有人都上班”。模型里有很多“专家”(即小型的神经网络模块),对于每一个输入(比如一个词),一个“路由器”(Router)会智能地选择几个最相关的专家来处理它,而不是调动整个庞大的模型。这大大节省了计算资源。

然而,传统MoE架构存在一个显著的痛点:计算资源分配的“僵化”。无论输入的任务是简单(如“你好”)还是复杂(如一段需要深度推理的物理题),模型都会激活固定数量、同样大小的专家。这就像一个公司,不管项目大小,都必须派出固定人数(比如3个人)的团队,且每个人的能力水平都一样。对于小项目,这是资源浪费;对于大项目,可能又人手不足。

作者的核心动机就是要打破这种僵化,实现计算资源的动态按需分配。他们希望模型能像一个智能的系统,为复杂的任务自动分配更多的计算力,为简单的任务则分配较少的计算力,从而在保证效果的同时,将计算效率最大化。

想象一个世界顶级的手工艺品作坊,要制作一批极其精美的艺术品。

步骤1:一件艺术品来了,项目经理依然挑选最合适的4位工匠。

步骤2:关键变化 — 假设选中的4位工匠是"木雕组"的张三和李四,以及"上色组"的王五和"金属组"的赵六。

步骤3:"木雕组"的首席助理会先对木料进行一次完美的预处理。然后,张三和李四共享这块处理好的木料,各自完成自己独特的、高难度的雕刻部分。

步骤4:与此同时,"上色组"和"金属组"的首席助理也各自为王五和赵六准备基础材料。

步骤5:核心优势 — 因为张三和李四同属一组,他们的基础工作(木料预处理)被首席助理合并并只执行了一次,大大节省了时间和成本。整个作坊的计算量(总工时)就实现了动态调整。

传统MoE的计算

对于一个输入x,路由器计算每个专家的得分p,选出得分最高的k个。最终输出是这k个专家输出的加权和。

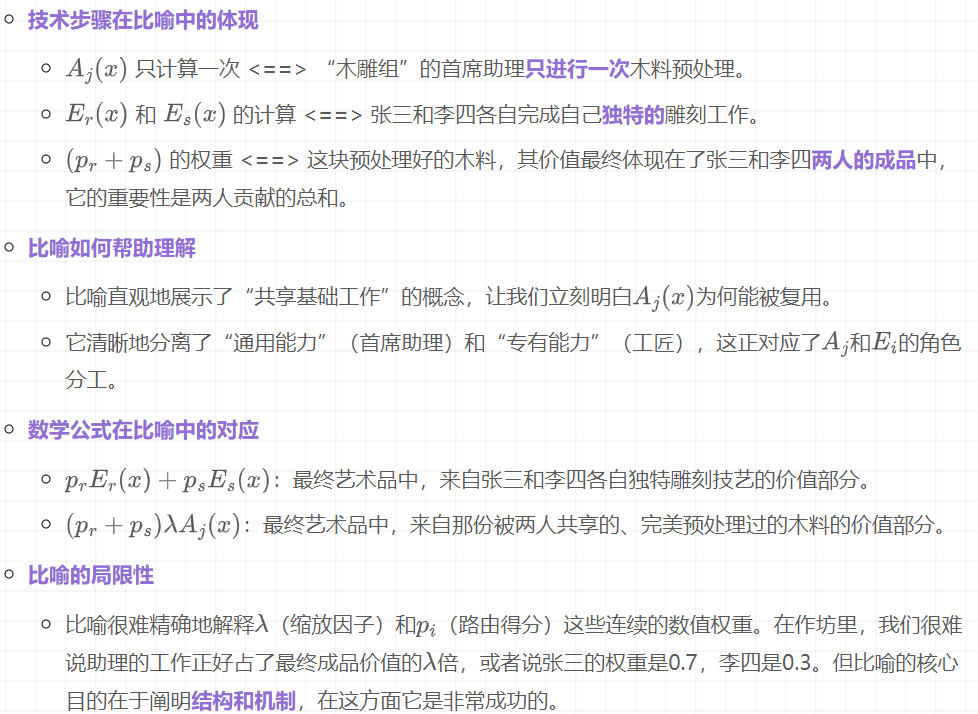

在Grove MoE中,一个专家的最终输出,是它自己独特的计算结果,加上它所在小组的“伴生专家”的计算结果。

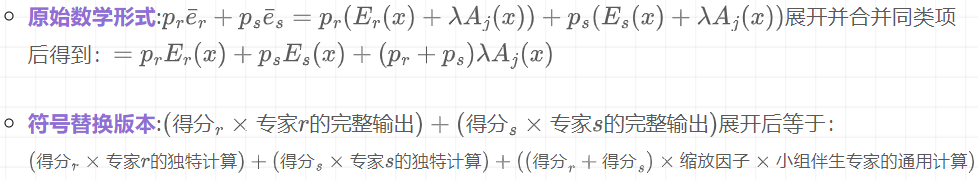

这是理解动态效率的关键。假设路由器选择了同一小组(组j)的两个专家,专家r和专家s。我们看看最终输出的计算会发生什么。

假设我们有一个训练好的GroveMoE模型,现在要对一个token的特征向量 进行处理。下面是其在某一个Grove MoE层内部的完整流程:

输入:来自上一层的、代表当前token的d维特征向量 x。

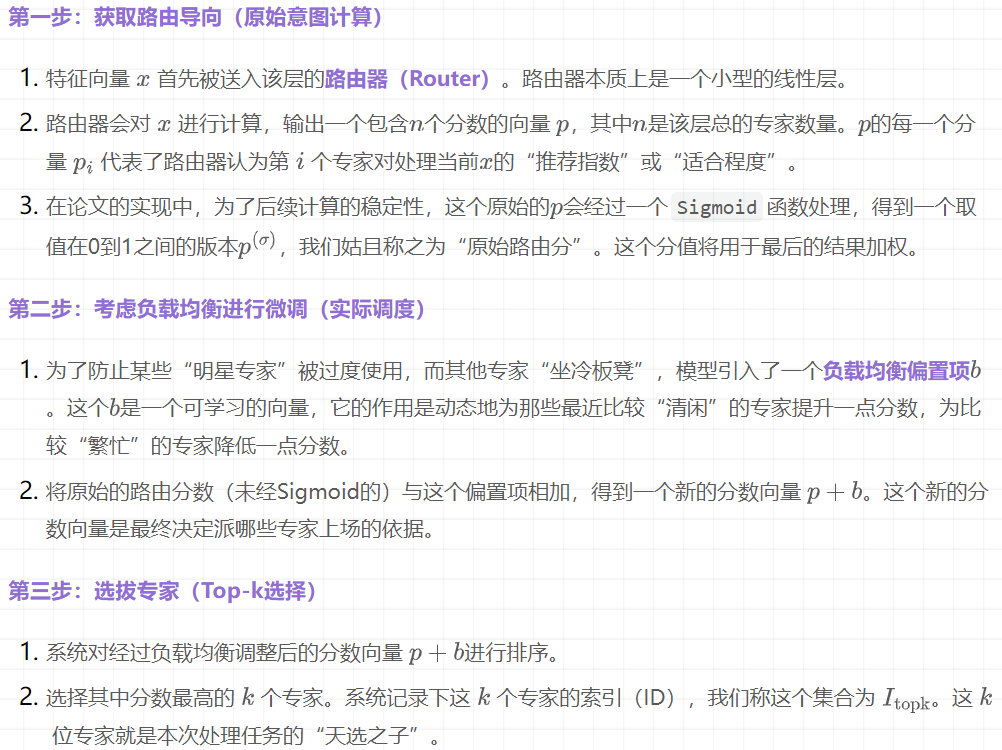

流程开始:

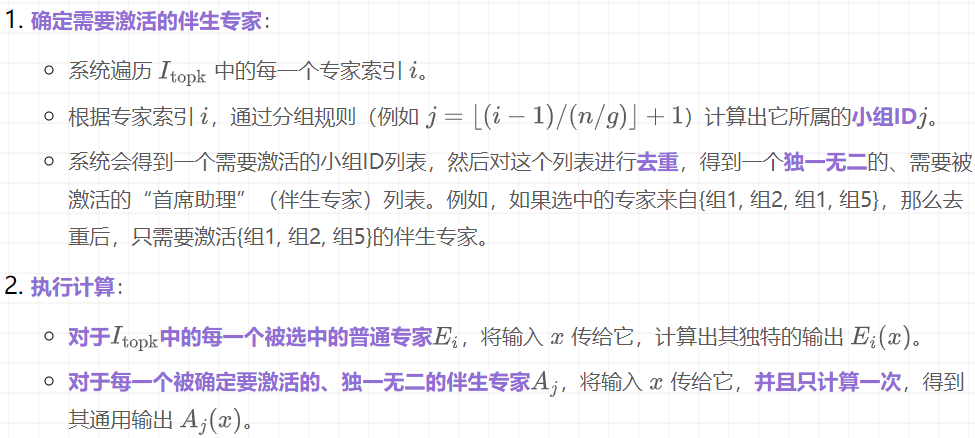

第四步:并行计算(专家与伴生专家同时开工)这一步是整个流程的核心,也是效率提升的关键所在。计算是并行展开的:

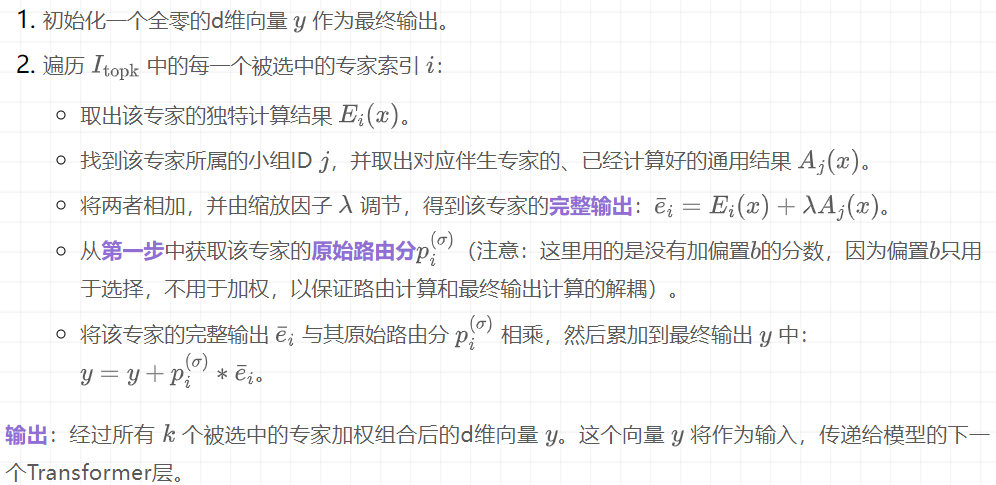

第五步:整合与加权(汇总成果)现在,所有的计算部件都已经准备就绪,需要将它们组合成最终的输出。

这个选择是非常合理的,因为它不仅全面,而且有针对性地包含了能凸显其"处理复杂任务"优势的领域。 - 评价指标:实验遵循了各个数据集公认的评价指标,如准确率(Accuracy),保证了比较的公正性。 - 基线方法:选择的对手非常有代表性,几乎囊括了当时所有顶尖的开源模型。

这个选择是极具说服力的,因为它包含了不同架构、不同大小的顶尖模型,能让GroveMoE的优势在多维度对比中显现出来。

文章来自于微信公众号“沈公子今天读什么”,作者是“Tensorlong 看天下”。

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner