月之暗面对谈 Zilliz:长文本和 RAG 如何选择?

月之暗面对谈 Zilliz:长文本和 RAG 如何选择?关于长文本和 RAG 到底如何选择,一直有争论,从基模公司到应用开发者。 今天这篇文章,是来自基模公司月之暗面和中间层 Zilliz 的技术对话,值得一看。

关于长文本和 RAG 到底如何选择,一直有争论,从基模公司到应用开发者。 今天这篇文章,是来自基模公司月之暗面和中间层 Zilliz 的技术对话,值得一看。

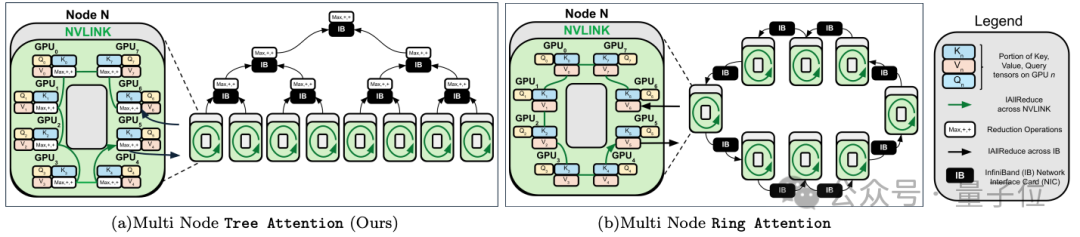

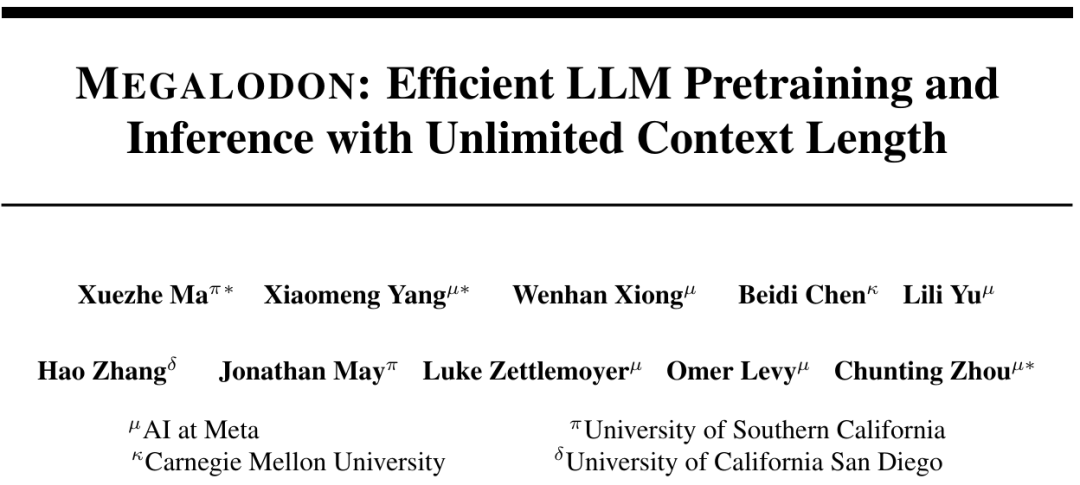

跨GPU的注意力并行,最高提速8倍,支持512万序列长度推理。

在长文本理解能力这块,竟然没有一个大模型及格!

大型语言模型(LLM)往往会追求更长的「上下文窗口」,但由于微调成本高、长文本稀缺以及新token位置引入的灾难值(catastrophic values)等问题,目前模型的上下文窗口大多不超过128k个token

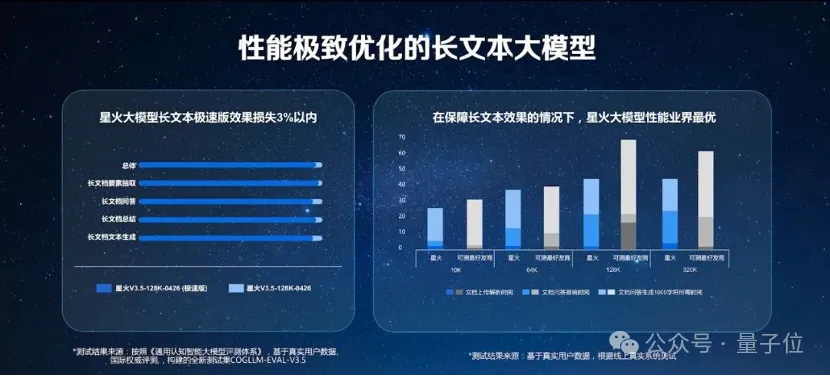

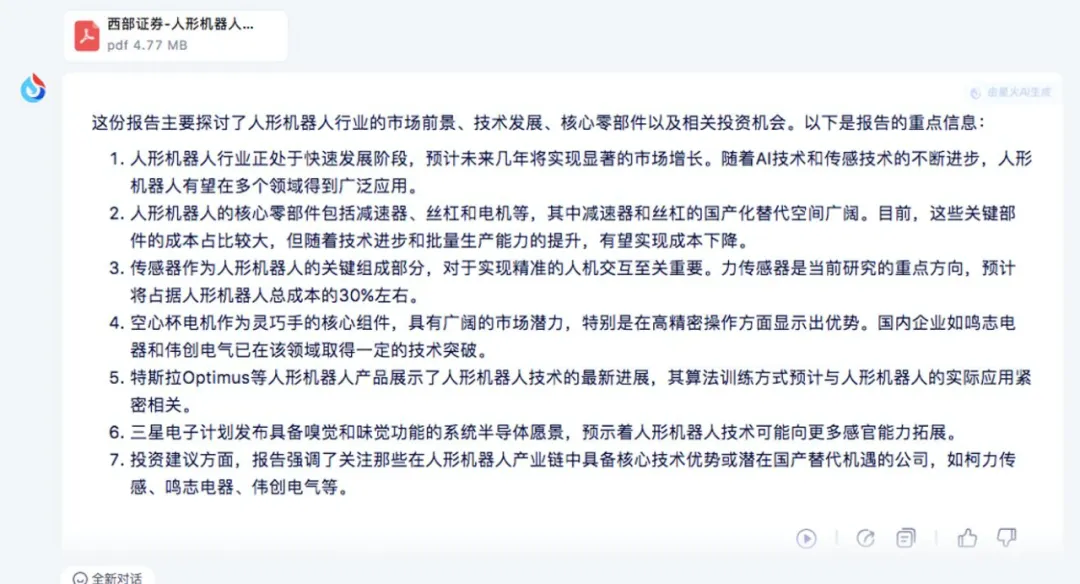

4 月 26 日,科大讯飞发布讯飞星火大模型 V3.5 的功能上新,其中一个重点就是面向用户各种场景中高效获取信息需求,发布首个长文本、长图文、长语音的大模型,能够支持文档、图文资料、会议录音等各种信息来源的快速理解和学习,还能够结合各种行业场景知识给出专业、准确回答。

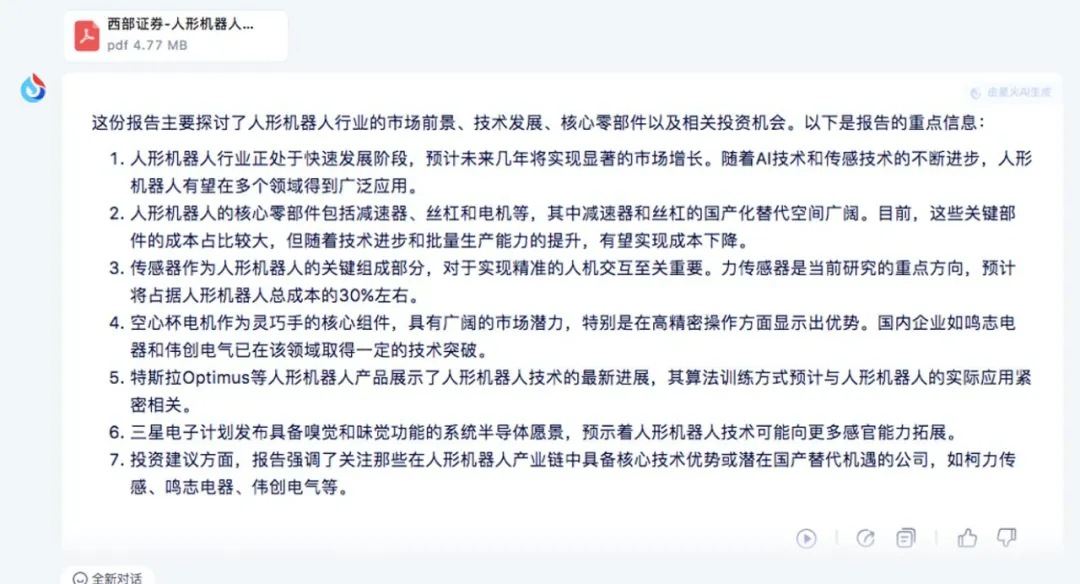

这一次,大模型真的可以让人类解放双手了。

4 月 26 日,科大讯飞发布讯飞星火大模型 V3.5 的功能上新,其中一个重点就是面向用户各种场景中高效获取信息需求,发布首个长文本、长图文、长语音的大模型,能够支持文档、图文资料、会议录音等各种信息来源的快速理解和学习,还能够结合各种行业场景知识给出专业、准确回答。

2024年AI(人工智能)大模型行业的第一场竞争热潮,从长文本开始。

Transformers 的二次复杂度和弱长度外推限制了它们扩展到长序列的能力,虽然存在线性注意力和状态空间模型等次二次解决方案

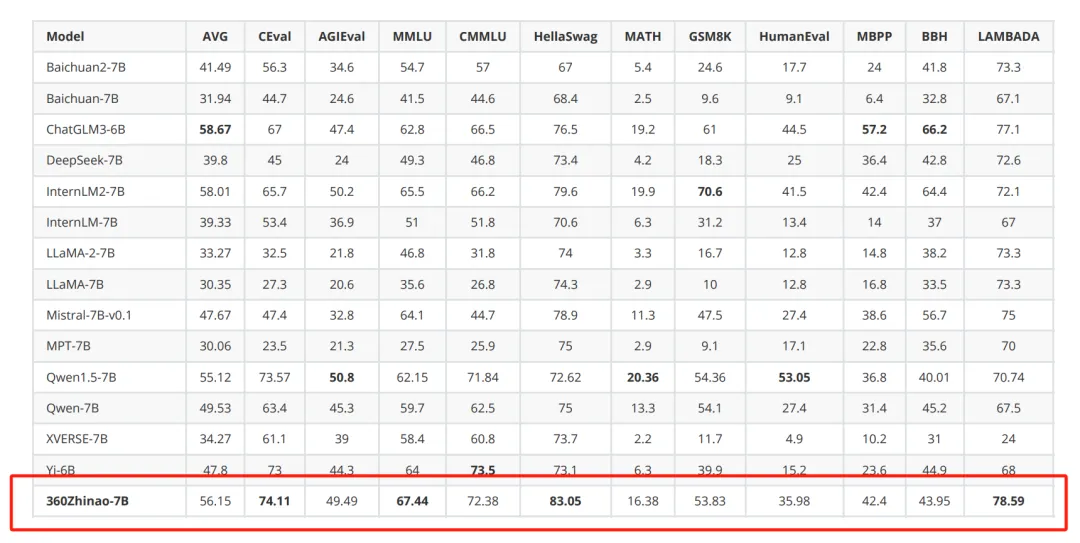

继之前公开课之后(周鸿祎:2024 年 AI 产业发展的 16 个趋势。)红衣大叔兑现诺言,开源了 7B 系列大模型