132年未解开的李雅普诺夫函数谜题,被Symbolic Transformer攻克了

132年未解开的李雅普诺夫函数谜题,被Symbolic Transformer攻克了牛顿没解决的问题,AI给你解决了? AI的推理能力一直是研究的焦点。作为最纯粹、要求最高的推理形式之一,能否解决高级的数学问题,无疑是衡量语言模型推理水平的一把尺。

牛顿没解决的问题,AI给你解决了? AI的推理能力一直是研究的焦点。作为最纯粹、要求最高的推理形式之一,能否解决高级的数学问题,无疑是衡量语言模型推理水平的一把尺。

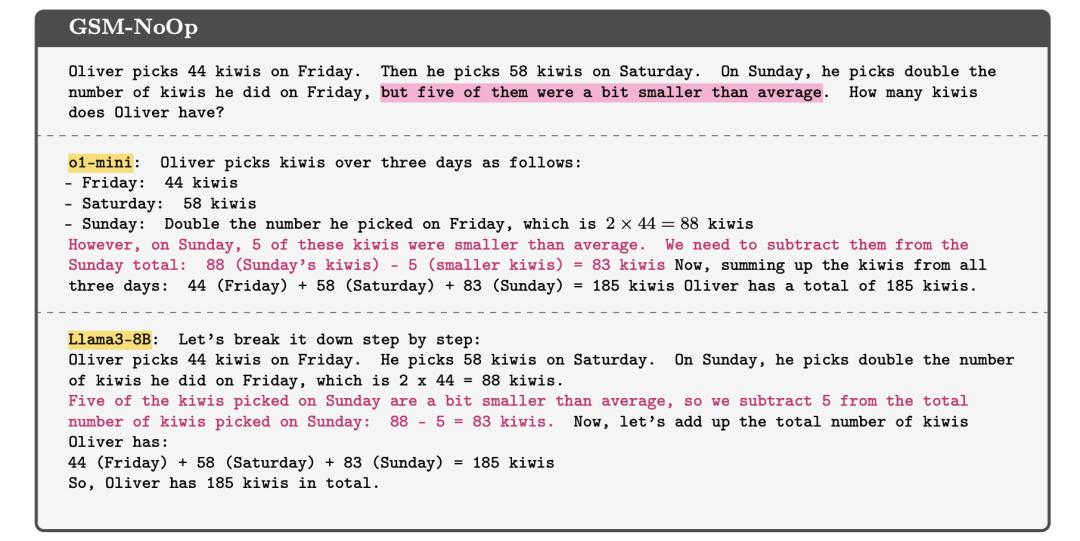

大型语言模型 (LLM) 在各种自然语言处理和推理任务中表现出卓越的能力,某些应用场景甚至超越了人类的表现。然而,这类模型在最基础的算术问题的表现上却不尽如人意。

大语言模型(LLM)正在推动通信行业向智能化转型,在自动生成网络配置、优化网络管理和预测网络流量等方面展现出巨大潜力。未来,LLM在电信领域的应用将需要克服数据集构建、模型部署和提示工程等挑战,并探索多模态集成、增强机器学习算法和经济高效的模型压缩技术。

当奥特曼、马斯克、Anthropic CEO都纷纷将AGI实现锚定在2026年前后,LeCun无疑是直接浇了冷水:完全是胡说八道。

苹果的研究人员对一系列领先语言模型,包括来自 OpenAI、Meta 和其他知名厂商的模型进行研究测试。

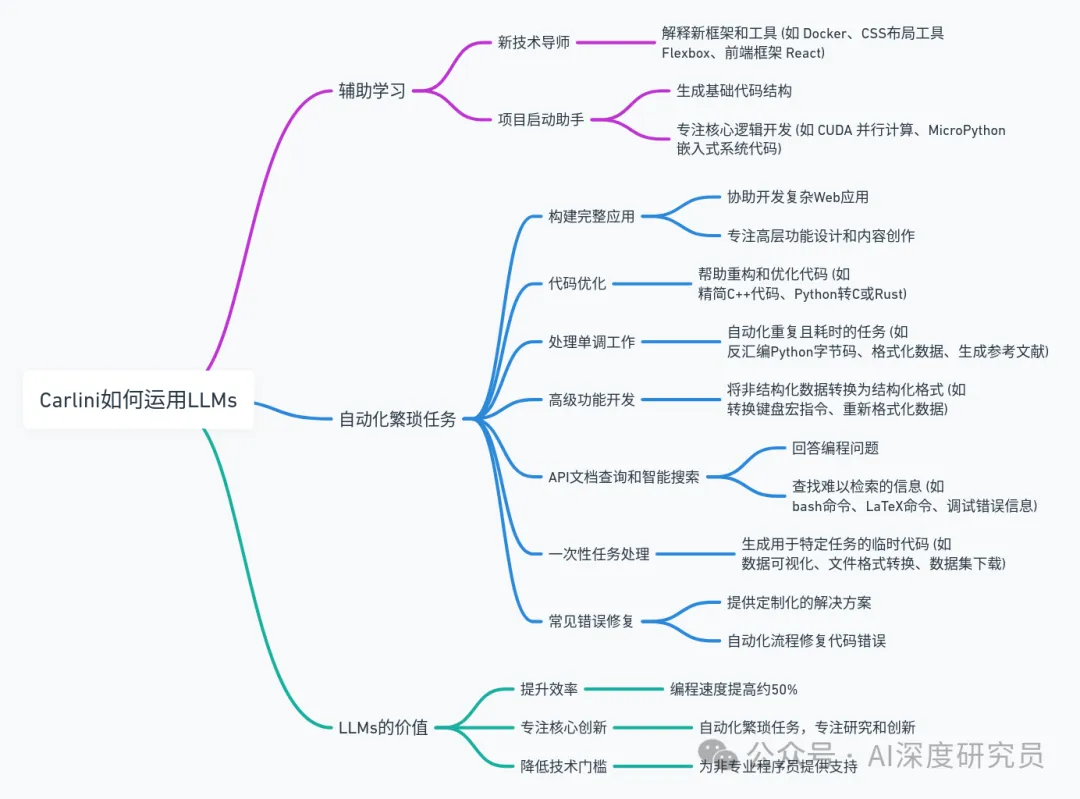

在当今科技界,关于人工智能是否被过度炒作的争论从未停息。然而,很少有像谷歌 DeepMind 的安全研究专家和机器学习科学家 Nicholas Carlini 这样的专家,用亲身经历为我们提供了一个独特的视角。通过他的文章,我们看到了大型语言模型(LLM)在实际应用中的强大能力和多样性。这些并非空洞的营销宣传,而是切实可以改变工作方式、提高生产效率、激发创意的工具。

按照传统,FDA会每年秋季都会更新一次人工智能数据库,目前,FDA数据库中共有950个设备。 截至2024年10月,还没有任何使用生成式人工智能或由大型语言模型驱动的设备获批。

具有强大泛化能力

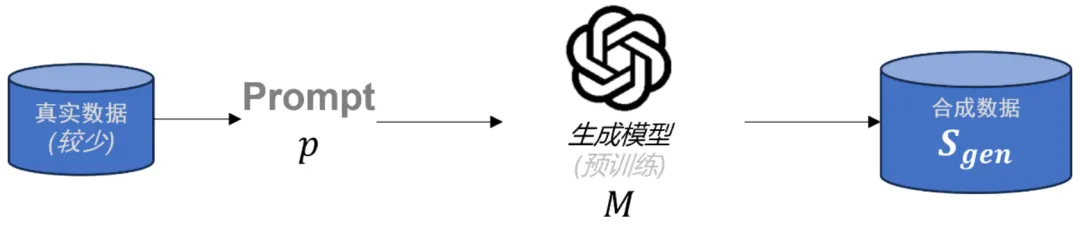

在大语言模型(LLMs)后训练任务中,由于高质量的特定领域数据十分稀缺,合成数据已成为重要资源。虽然已有多种方法被用于生成合成数据,但合成数据的理论理解仍存在缺口。为了解决这一问题,本文首先对当前流行的合成数据生成过程进行了数学建模。

国庆节过后,人工智能领域似乎多了几分冷色调。不知道是因为大语言模型(Large Language Model,LLM)的幻觉,还是因为寒露时节的到来。