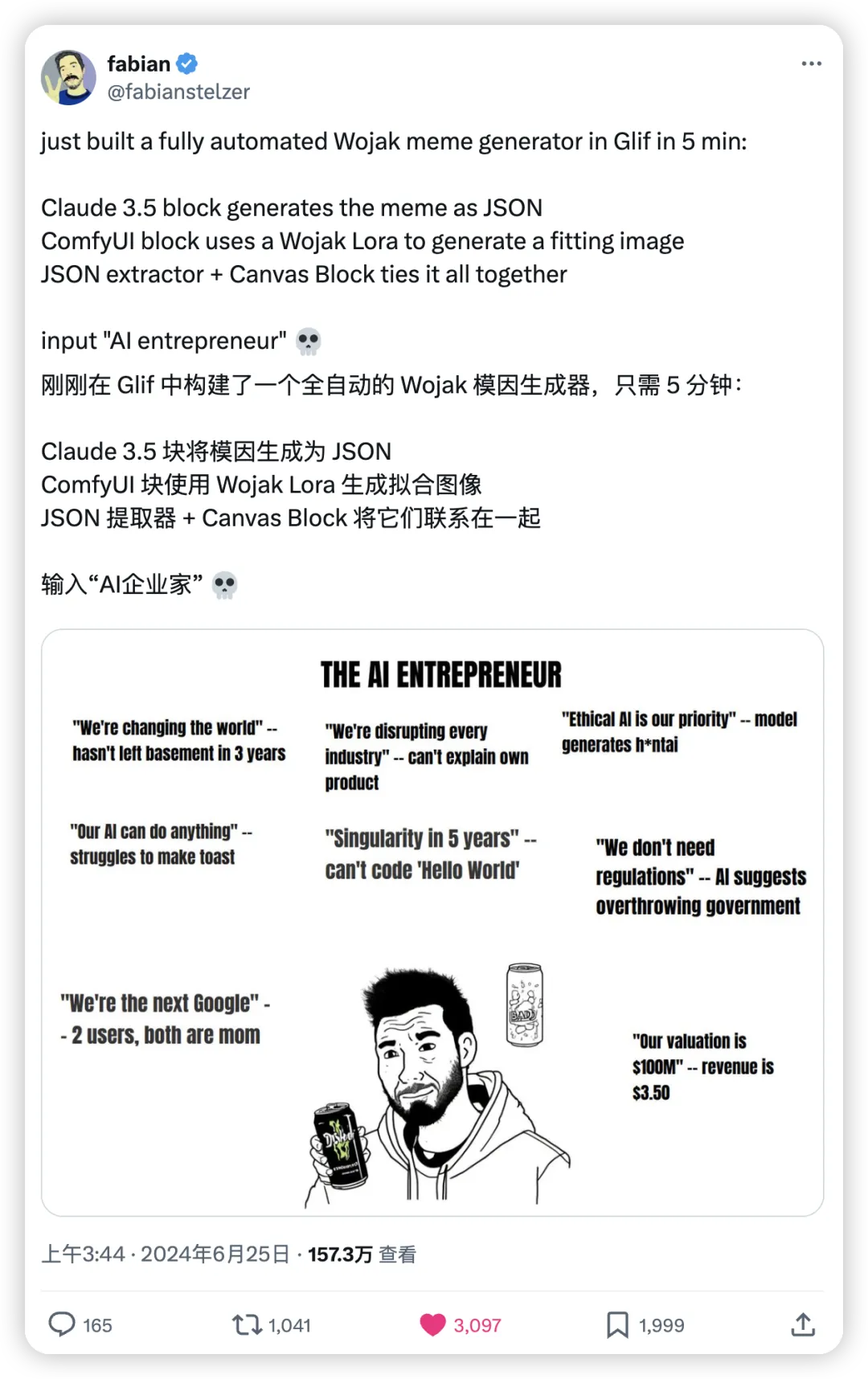

Glif 的作者五分钟做了个 AI 梗图生成器,结果风靡推特。

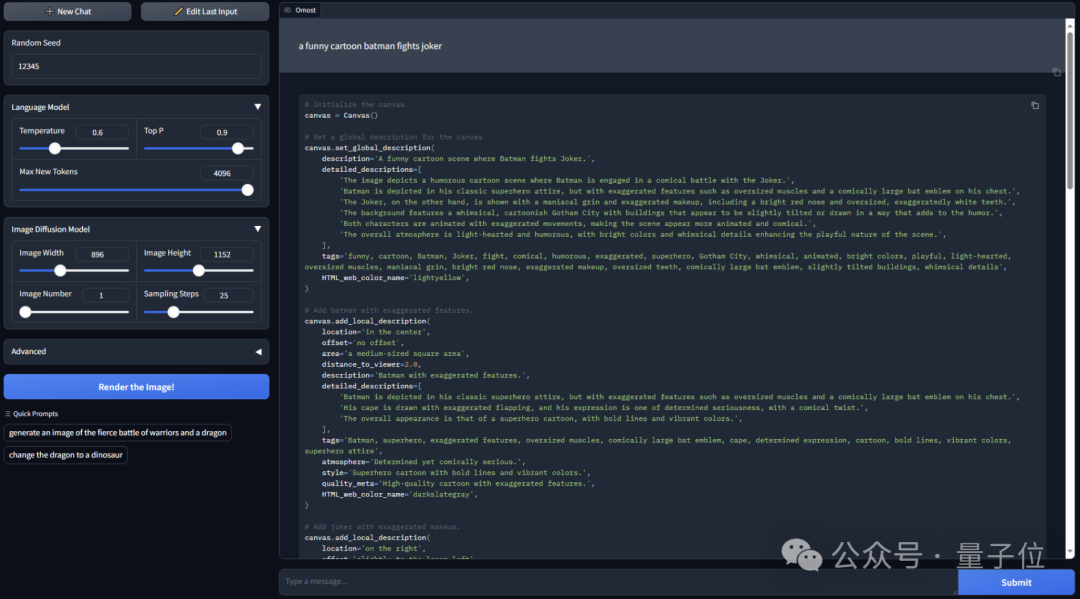

Glif 的作者五分钟做了个 AI 梗图生成器,结果风靡推特。推特上有这么一个作者,今天早上只用了五分钟,使用了 Claude 3.5、ComfyUI、JSON 提取器等模块,搭建了个生成 meme 梗图的生成器,截止目前已经 157.3w 人看过。

推特上有这么一个作者,今天早上只用了五分钟,使用了 Claude 3.5、ComfyUI、JSON 提取器等模块,搭建了个生成 meme 梗图的生成器,截止目前已经 157.3w 人看过。

超越扩散模型!自回归范式在图像生成领域再次被验证——

苹果OpenAI官宣合作,GPT-4o加持Siri,让AI个性化生成赛道热度飙升。

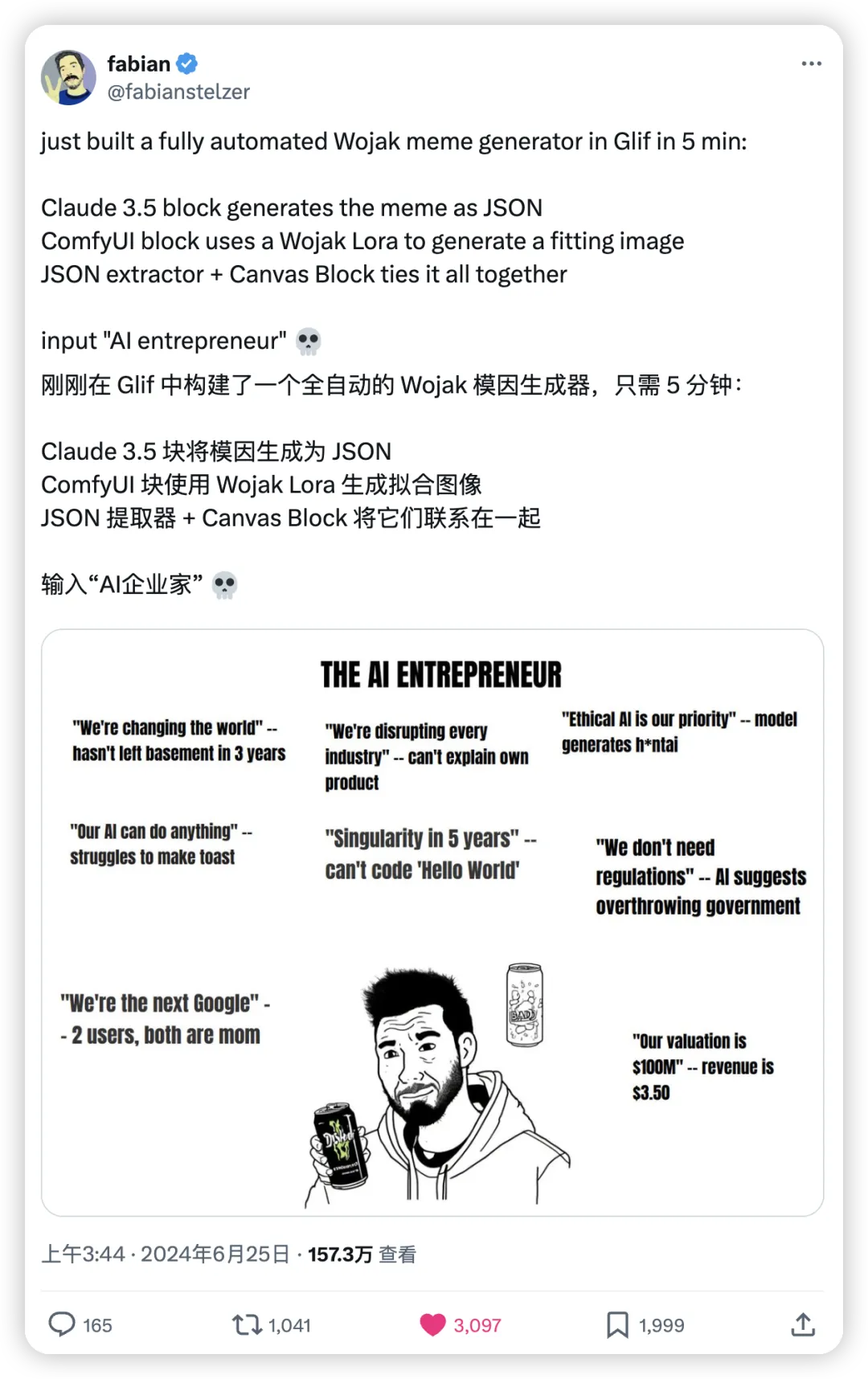

如何生成高难度、指令超复杂的视频呢?

重磅消息!Stable Diffusion 3,大概率会在明天开源。距离2月SD3的横空出世,已经过去了4个月。如果此事为真,生图圈子第一个出现开源碾压闭源的奇景!强大的MMDiT全新架构,将彻底改变AI生图的格局。现在,全体AI社区都在翘首以盼。

OpenAI在5月14日推出了新一代人工智能模型GPT-4o,支持文本、音频和图像的任意组合输入,并能够生成文本、音频和图像的任意组合输出。仅仅一天后,谷歌就在新一届I/O开发者大会上发布、更新了十多款产品,包括AI助手Project Astra、文生图模型Imagen3、对标Sora的文生视频模型Veo,以及备受瞩目的大模型Gemini 1.5 Pro的升级版。

ControlNet作者新项目,居然也搞起大模型和Agent了。

随着大模型产品可图的正式发布,快手也将持续为用户带来更丰富有趣的AI互动新体验。

七年前,一张帅气军装照的H5活动,成为现象级刷屏朋友圈的“始祖”。

在一个有点僵化的赛道里,如何获得用户? 在 3 月份的榜单里,有一款 AI 生图产品网站流量增长了 36.8%,流量达到 1110 万,排在全球 AI 产品网站流量榜的第 53 位,本月上升了 19 位。