18项任务200万视频编辑对,云天励飞联合多高校打造出大规模编辑数据集

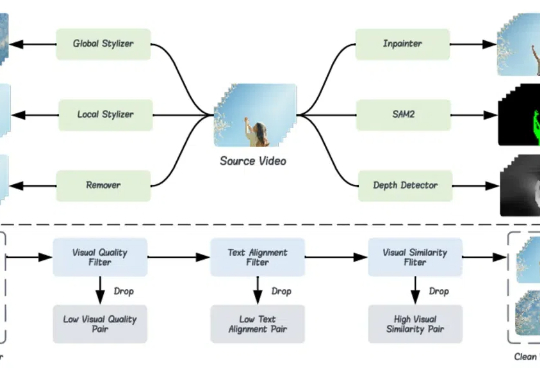

18项任务200万视频编辑对,云天励飞联合多高校打造出大规模编辑数据集为了解决视频编辑模型缺乏训练数据的问题,本文作者(来自香港中文大学、香港理工大学、清华大学等高校和云天励飞)提出了一个名为 Señorita-2M 的数据集。该数据集包含 200 万高质量的视频编辑对,囊括了 18 种视频编辑任务。

为了解决视频编辑模型缺乏训练数据的问题,本文作者(来自香港中文大学、香港理工大学、清华大学等高校和云天励飞)提出了一个名为 Señorita-2M 的数据集。该数据集包含 200 万高质量的视频编辑对,囊括了 18 种视频编辑任务。

双一流高校本科扩容”这一话题日前登上热搜,引发关注。清华大学此次拟扩招的新生将进入新成立的本科通识书院,着力培养具备人工智能思维、胜任人工智能技术、具有人工智能与不同学科深度交叉知识素养的复合型人才。

AGI明年降临?清华人大最新研究给狂热的AI世界泼了一盆冷水:人类距离真正的AGI,还有整整70年!若要实现「自主级智能,需要惊人的10²⁶参数,所需GPU总价竟是苹果市值的4×10⁷倍!

推理模型在复杂任务上表现惊艳,缺点是低下的token效率。UCSD清华等机构的研究人员发现,问题根源在于模型的「自我怀疑」!研究团队提出了Dynasor-CoT,一种无需训练、侵入性小且简单的方法。

国际可重构计算领域顶级会议 ——FPGA 2025 在落幕之时传来消息,今年的最佳论文颁发给了无问芯穹和上交、清华共同提出的视频生成大模型推理 IP 工作 FlightVGM,这是 FPGA 会议首次将该奖项授予完全由中国大陆科研团队主导的研究工作,同时也是亚太国家团队首次获此殊荣。

北京时间今天凌晨,Kimi 与清华大学合作研发的 Mooncake 项目技术报告获得计算机存储领域顶会 FAST 2025「最佳论文」奖。Mooncake 是月之暗面 Kimi 的底层推理服务平台。

大自然的分形之美,蕴藏着宇宙的设计规则。刚刚,何恺明团队祭出「分形生成模型」,首次实现高分辨率逐像素建模,让计算效率飙升4000倍,开辟AI图像生成新范式。

在科技界,快速崛起和巨额交易总是备受关注。本周,MongoDB 宣布以 2.2 亿美元的价格收购 Voyage AI——一家刚成立 17 个月、在嵌入(embedding)和重排序(reranking)模型领域处于行业领先地位的 AI 初创公司。

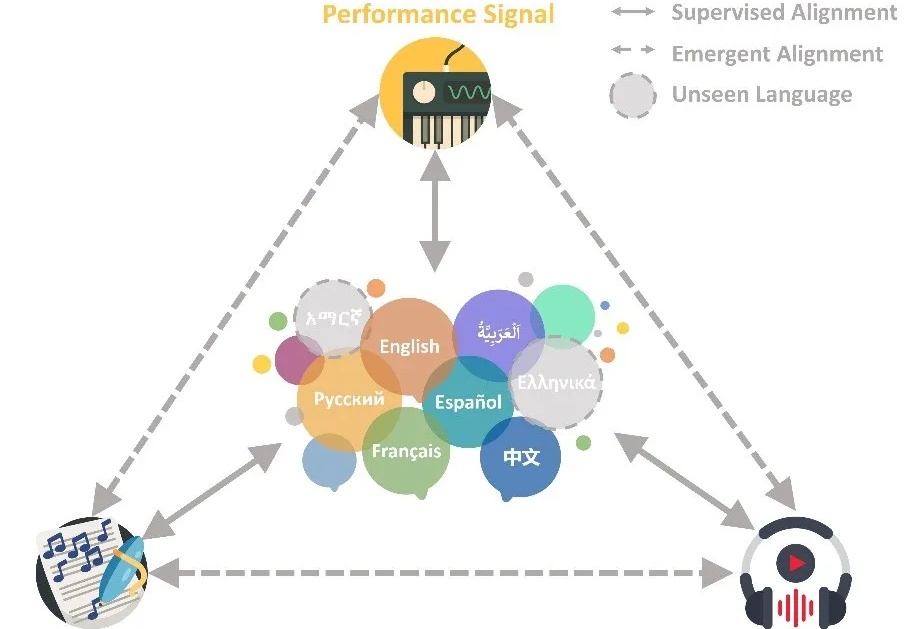

给AI看一眼图,它就能找到对应音乐。

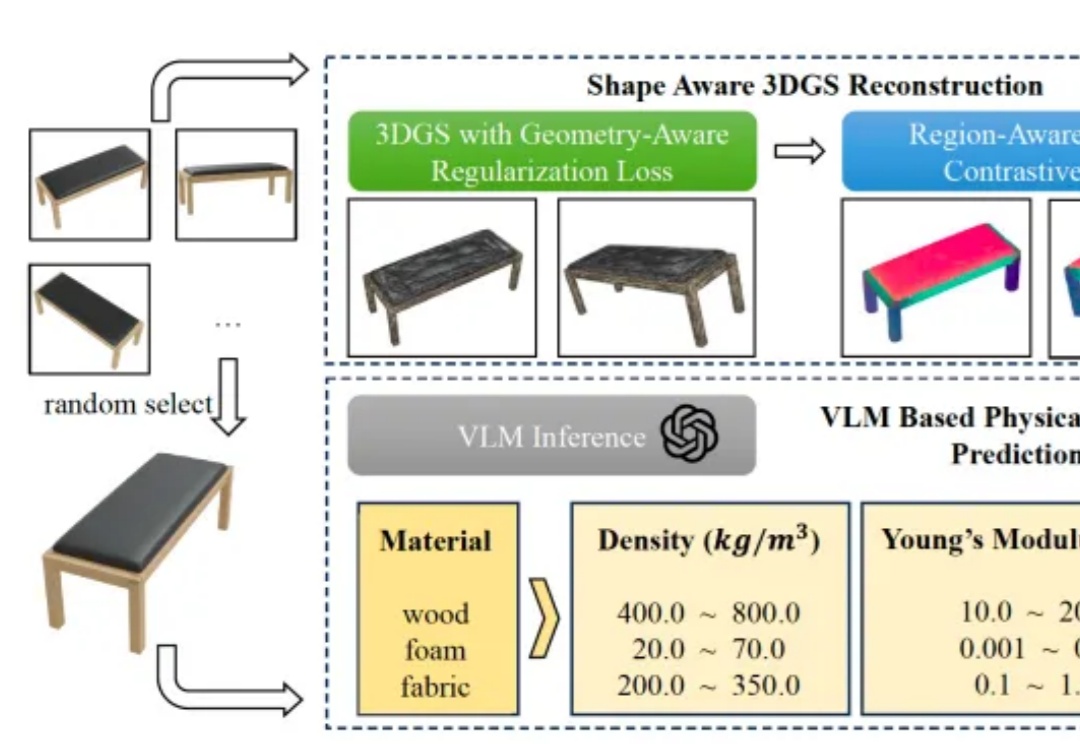

理解物体的物理属性,对机器人执行操作十分重要,但是应该如何实现呢?