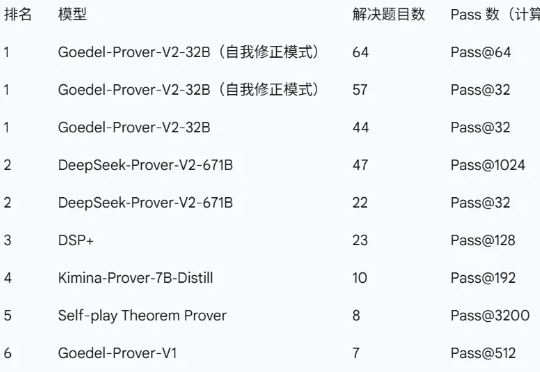

普林斯顿团队领衔发布最强开源数学定理证明模型:32B性能大幅超越前代SOTA DeepSeek 671B

普林斯顿团队领衔发布最强开源数学定理证明模型:32B性能大幅超越前代SOTA DeepSeek 671B近日,由普林斯顿大学牵头,联合清华大学、北京大学、上海交通大学、斯坦福大学,以及英伟达、亚马逊、Meta FAIR 等多家顶尖机构的研究者共同推出了新一代开源数学定理证明模型——Goedel-Prover-V2。

近日,由普林斯顿大学牵头,联合清华大学、北京大学、上海交通大学、斯坦福大学,以及英伟达、亚马逊、Meta FAIR 等多家顶尖机构的研究者共同推出了新一代开源数学定理证明模型——Goedel-Prover-V2。

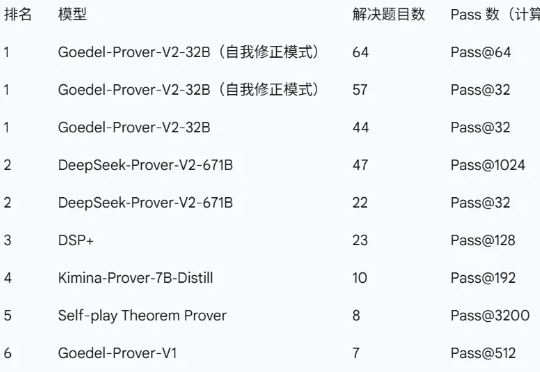

7 月 1 日,国际顶级学术期刊《Nature》旗下子刊《Nature Communications》正式刊登了来自清华、面壁等研究团队联合研发的高效端侧多模态大模型MiniCPM-V 核心研究成果。

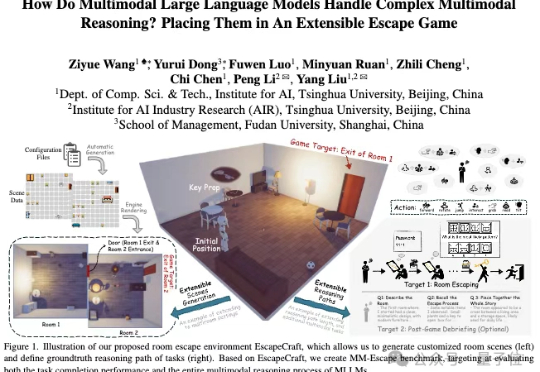

本文作者来自:南京大学、香港大学、中南大学、地平线、中国科学院计算所、上海交通大学、慕尼黑工业大学、清华大学。

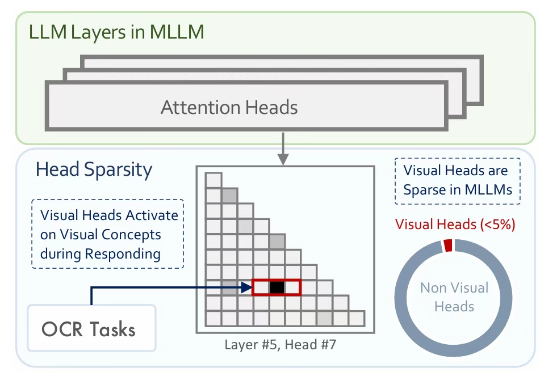

多模态大模型通常是在大型预训练语言模型(LLM)的基础上扩展而来。尽管原始的 LLM 并不具备视觉理解能力,但经过多模态训练后,这些模型却能在各类视觉相关任务中展现出强大的表现。

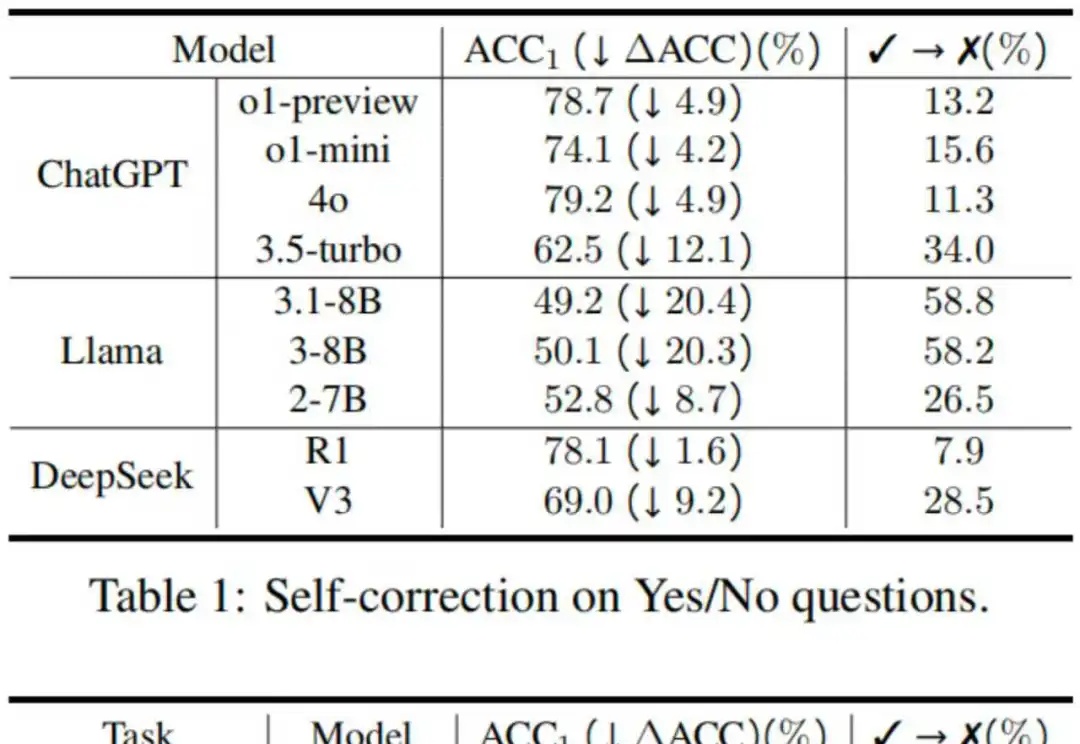

反思技术因其简单性和有效性受到了广泛的研究和应用,具体表现为在大语言模型遇到障碍或困难时,提示其“再想一下”,可以显著提升性能 [1]。然而,2024 年谷歌 DeepMind 的研究人员在一项研究中指出,大模型其实分不清对与错,如果不是仅仅提示模型反思那些它回答错误的问题,这样的提示策略反而可能让模型更倾向于把回答正确的答案改错 [2]。

近年来,多模态大模型(MLLMs)发展迅猛,从看图说话到视频理解,似乎无所不能。

Grok 4一夜爆火硅谷,幕后团队功不可没。今天,一张内部作战图在全网疯转,华人学者占比高达80%。清华、上交、浙大等校友云集,还有一位95后联创。

AI 科技评论独家获悉,百川智能技术联合创始人谢剑将离职。其离职原因尚未公开,下一步动向也暂无明确消息。谢剑硕士毕业于武汉大学人工智能方向,2012 年获得硕士学位后加入百度,后在职攻读博士,并获得清华大学计算机科学博士学位。他曾是百度集团内最年轻晋升为主任研发架构师的工程师之一,同时也是集团总技术委员会成员。

2025 年,大模型又一次刷新了人类的认知边界,AI 模拟高考成绩大幅跃升,已达到清华、北大的录取线。但另一方面,这也让人感到些许焦虑。

最少只用2张图,AI就能像人类一样理解3D空间了。ICCV 2025最新中稿的LangScene-X:以全新的生成式框架,仅用稀疏视图(最少只用2张图像)就能构建可泛化的3D语言嵌入场景,对比传统方法如NeRF,通常需要20个视角。