CVPR 2024 | 仅需文本或图像提示,新框架CustomNeRF精准编辑3D场景

CVPR 2024 | 仅需文本或图像提示,新框架CustomNeRF精准编辑3D场景自 2020 年神经辐射场 (Neural Radiance Field, NeRF) 提出以来,将隐式表达推上了一个新的高度。作为当前最前沿的技术之一

自 2020 年神经辐射场 (Neural Radiance Field, NeRF) 提出以来,将隐式表达推上了一个新的高度。作为当前最前沿的技术之一

近,来自澳大利亚蒙纳士大学、蚂蚁集团、IBM 研究院等机构的研究人员探索了模型重编程 (model reprogramming) 在大语言模型 (LLMs) 上应用,并提出了一个全新的视角

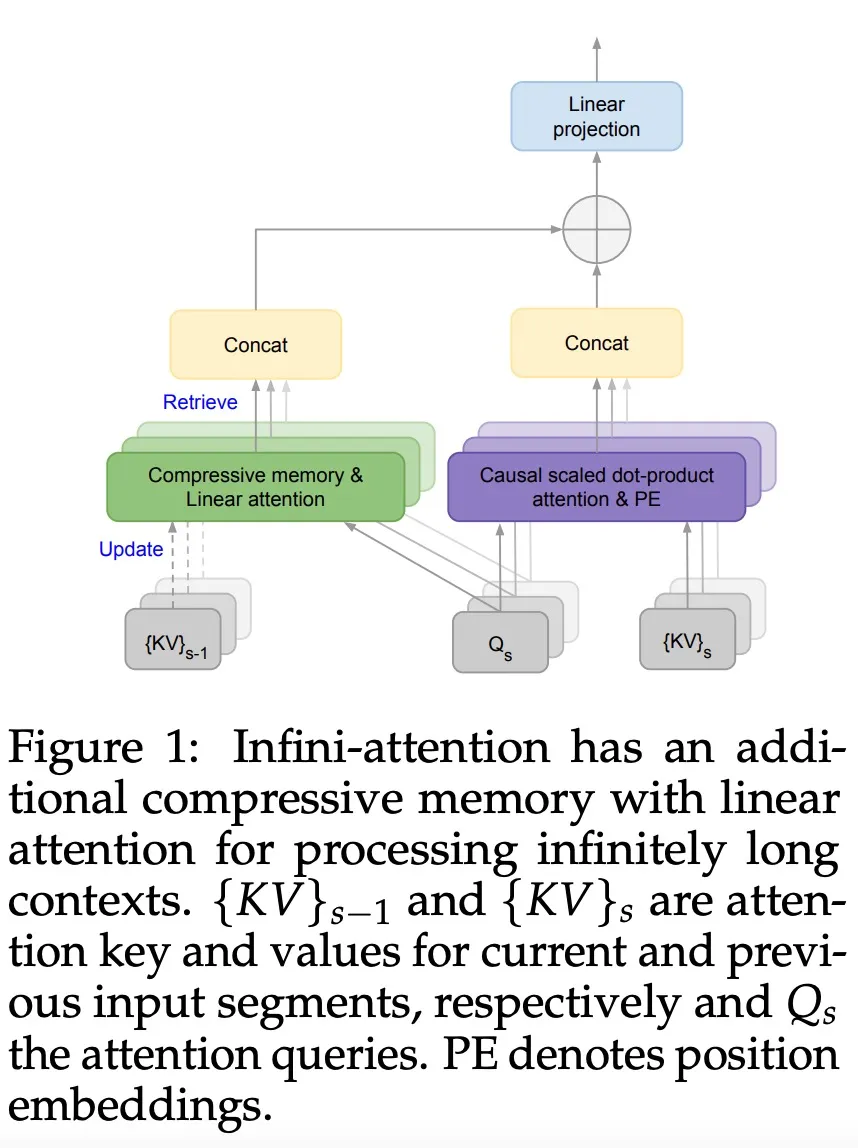

为解决大模型(LLMs)在处理超长输入序列时遇到的内存限制问题,本文作者提出了一种新型架构:Infini-Transformer,它可以在有限内存条件下,让基于Transformer的大语言模型(LLMs)高效处理无限长的输入序列。实验结果表明:Infini-Transformer在长上下文语言建模任务上超越了基线模型,内存最高可节约114倍。

它通过将压缩记忆(compressive memory)整合到线性注意力机制中,用来处理无限长上下文

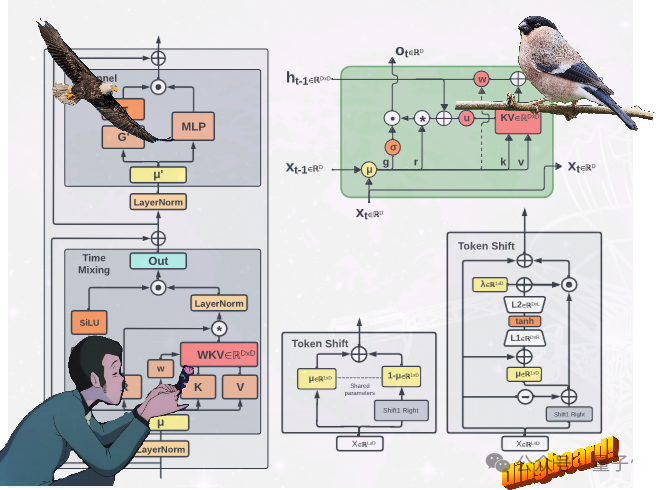

不走Transformer寻常路,魔改RNN的国产新架构RWKV,有了新进展: 提出了两种新的RWKV架构,即Eagle (RWKV-5) 和Finch(RWKV-6)。

随着大模型的参数量日益增长,微调整个模型的开销逐渐变得难以接受。 为此,北京大学的研究团队提出了一种名为 PiSSA 的参数高效微调方法,在主流数据集上都超过了目前广泛使用的 LoRA 的微调效果。

谷歌又放大招了,发布下一代 Transformer 模型 Infini-Transformer。

在实践中,人类预测的准确性依赖于「群体智慧」(wisdom of the crowd)效应,即通过聚集一群个体预测者,对未来事件的预测准确率会显著提高

大语言模型(LLM),通过在海量数据集上的训练,展现了超强的多任务学习、通用世界知识目标规划以及推理能力

大语言模型潜力被激发—— 无需训练大语言模型就能实现高精度时序预测,超越一切传统时序模型。