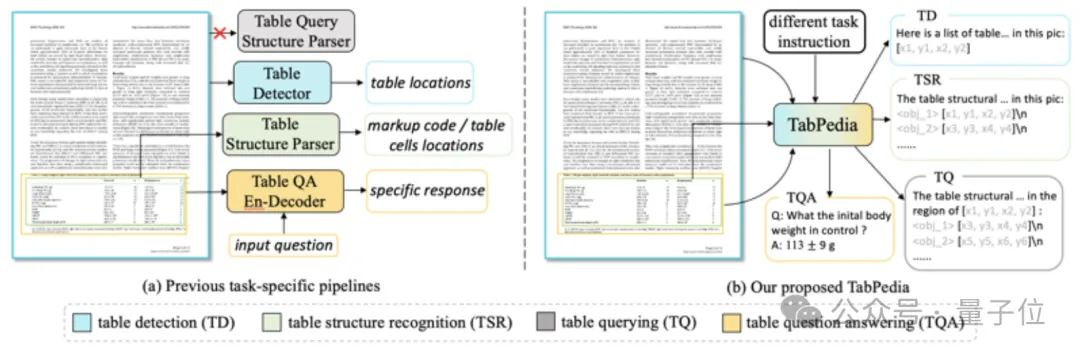

大模型理解复杂表格,字节&中科大出手了

大模型理解复杂表格,字节&中科大出手了只要一个大模型,就能解决打工人遇到的表格难题!

只要一个大模型,就能解决打工人遇到的表格难题!

在CV、ML等领域经常用到的神经场网格模型,如今有了理论框架描述其训练动力学和泛化性能。

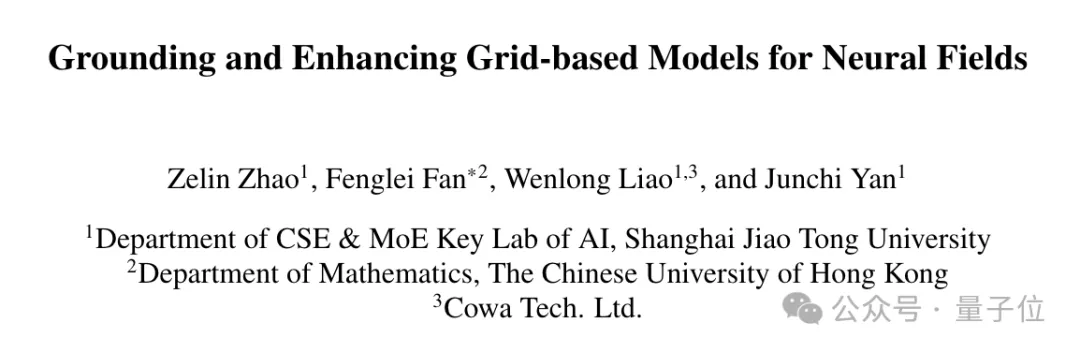

近年来,大语言模型(Large Language Models, LLMs)受到学术界和工业界的广泛关注,得益于其在各种语言生成任务上的出色表现,大语言模型推动了各种人工智能应用(例如ChatGPT、Copilot等)的发展。然而,大语言模型的落地应用受到其较大的推理开销的限制,对部署资源、用户体验、经济成本都带来了巨大挑战。

用KV缓存加速大模型的显存瓶颈,终于迎来突破。 北大、威斯康辛-麦迪逊、微软等联合团队提出了全新的缓存分配方案,只用2.5%的KV cache,就能保持大模型90%的性能。 这下再也不用担心KV占用的显存容量过高,导致显卡不够用了。

距上次Karpathy AI大课更新之后,又有了1个多月的时间。这次他带了超详细的4小时课程——从零开始实现1.24亿参数规模的GPT-2模型。

Transformer很强,Transformer很好,但Transformer在处理时序数据时存在一定的局限性。

近些年,语言建模领域进展非凡。Llama 或 ChatGPT 等许多大型语言模型(LLM)有能力解决多种不同的任务,它们也正在成为越来越常用的工具。

大型语言模型(LLM)的一个主要特点是「大」,也因此其训练和部署成本都相当高,如何在保证 LLM 准确度的同时让其变小就成了非常重要且有价值的研究课题。

360 度场景生成是计算机视觉的重要任务,主流方法主要可分为两类,一类利用图像扩散模型分别生成 360 度场景的多个视角。由于图像扩散模型缺乏场景全局结构的先验知识,这类方法无法有效生成多样的 360 度视角,导致场景内主要的目标被多次重复生成,如图 1 的床和雕塑。

近年来兴起的第一人称视角视频研究为理解人类社交行为提供了无法取代的直观视角,然而,绝大多数的既往工作都侧重于分析与摄像机佩戴者相关的行为,并未关注处于社交场景中其他社交对象的状态。